ko

ko  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Python은 강력한 라이브러리와 간단한 구문으로 인해 웹 스크래핑을 위한 최고의 선택으로 손꼽힙니다. 이 글에서는 웹 스크래핑의 기본을 살펴보고 첫 번째 웹 스크래퍼를 만들기 위한 Python 환경 설정 과정을 안내합니다. Beautiful Soup, Playwright, lxml 등 스크래핑 작업에 적합한 주요 Python 라이브러리를 소개합니다.

Python은 웹 스크래핑을 더 쉽게 할 수 있는 여러 라이브러리를 제공합니다. 다음은 가장 일반적으로 사용되는 몇 가지 라이브러리입니다:

HTTP(하이퍼텍스트 전송 프로토콜)는 웹에서 데이터를 전송하기 위한 애플리케이션 계층 프로토콜입니다. 브라우저에 URL을 입력하면 브라우저는 HTTP 요청을 생성하여 웹 서버로 전송합니다. 그러면 웹 서버는 HTTP 응답을 브라우저로 다시 보내 사용자에게 HTML 페이지로 렌더링합니다. 웹 스크래핑의 경우 이 프로세스를 모방하고 스크립트에서 HTTP 요청을 생성하여 프로그래밍 방식으로 웹 페이지의 HTTP 콘텐츠를 가져와야 합니다.

먼저 시스템에 Python이 설치되어 있는지 확인합니다. Python 공식 웹사이트에서 다운로드할 수 있습니다.

가상 환경은 종속성을 관리하는 데 도움이 됩니다. 다음 명령을 사용하여 가상 환경을 생성하고 활성화하세요:

python -m venv scraping_env

source scraping_env/bin/activate

그런 다음 다음 명령을 사용하여 필요한 패키지를 설치합니다:

pip install requests

pip install beautifulsoup4

pip install lxml

정적 HTML 콘텐츠를 스크랩하는 요청을 사용하는 간단한 웹 스크레이퍼부터 시작해 보겠습니다.

가장 일반적인 HTTP 요청 유형은 GET 요청으로, 지정된 URL에서 데이터를 검색하는 데 사용됩니다. 다음은 http://example.com 에 GET 요청을 수행하는 기본 예제입니다.

import requests

url = 'http://example.com'

response = requests.get(url)

요청 라이브러리는 응답을 처리하고 처리하는 여러 가지 방법을 제공합니다:

상태 코드 확인: 요청이 성공했는지 확인합니다.

if response.status_code == 200:

print('Request was successful!')

else:

print('Request failed with status code:', response.status_code)

콘텐츠 추출: 응답에서 텍스트 또는 JSON 콘텐츠를 추출합니다.

# 응답 콘텐츠를 텍스트로 가져오기

page_content = response.text

print(page_content)

# 응답 콘텐츠를 JSON으로 가져오기(응답이 JSON 형식인 경우)

json_content = response.json()

print(json_content)

리소스에 연결할 수 없거나 요청 시간이 초과되었거나 서버가 오류 HTTP 상태(예: 404 찾을 수 없음, 500 내부 서버 오류)를 반환할 때 HTTP 및 네트워크 오류가 발생할 수 있습니다. 이러한 상황을 처리하기 위해 요청에서 발생하는 예외 객체를 사용할 수 있습니다.

import requests

url = 'http://example.com'

try:

response = requests.get(url, timeout=10) # Set a timeout for the request

response.raise_for_status() # Raises an HTTPError for bad responses

except requests.exceptions.HTTPError as http_err:

print(f'HTTP error occurred: {http_err}')

except requests.exceptions.ConnectionError:

print('Failed to connect to the server.')

except requests.exceptions.Timeout:

print('The request timed out.')

except requests.exceptions.RequestException as req_err:

print(f'Request error: {req_err}')

else:

print('Request was successful!')

웹 스크래핑의 경우 HTML 콘텐츠에서 데이터를 추출해야 하는 경우가 많습니다. 이 파트에서는 Beautiful Soup이나 lxml과 같은 라이브러리를 사용하여 HTML 요소에서 데이터를 찾고 추출하는 방법에 대해 설명합니다.

HTML(하이퍼텍스트 마크업 언어)은 웹 페이지를 만들기 위한 표준 마크업 언어입니다. HTML은 <div>, <p>, <a> 등과 같은 태그로 표시되는 중첩된 요소로 구성됩니다. 각 태그는 속성을 가질 수 있으며 텍스트, 다른 태그 또는 둘 다를 포함할 수 있습니다.

XPath 및 CSS 선택기는 속성 또는 문서 내 위치에 따라 HTML 요소를 선택할 수 있는 다양한 방법을 제공합니다.

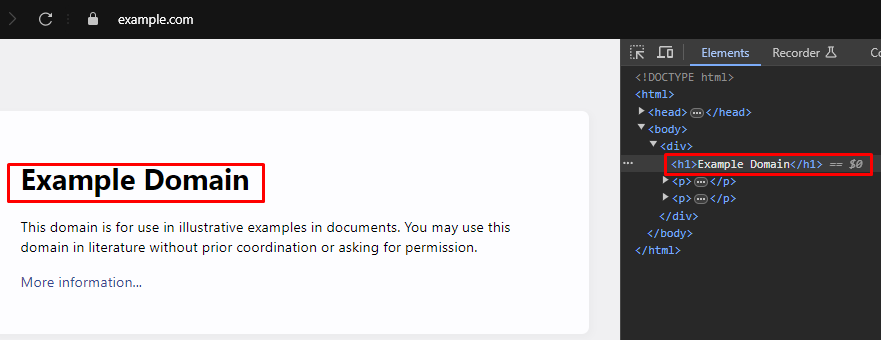

웹 스크래핑을 할 때 웹 페이지에서 특정 데이터를 추출하려면 HTML 요소를 대상으로 하는 올바른 XPath 또는 CSS 선택기를 식별해야 하는 경우가 많습니다. 이러한 선택기를 효율적으로 찾는 방법은 다음과 같습니다:

대부분의 최신 웹 브라우저에는 웹 페이지의 HTML 구조를 검사할 수 있는 개발자 도구가 내장되어 있습니다. 다음은 이러한 도구를 사용하는 방법에 대한 단계별 가이드입니다:

XPath: /html/body/div/h1

CSS Selector: body > div > h1

Beautiful Soup은 HTML 및 XML 문서를 구문 분석하기 위한 Python 라이브러리입니다. HTML 구조를 탐색하고 검색할 수 있는 간단한 메서드와 속성을 제공합니다.

from bs4 import BeautifulSoup

import requests

# 스크랩할 웹페이지의 URL

url = 'https://example.com'

# URL로 HTTP GET 요청을 보냅니다.

response = requests.get(url)

# Beautiful Soup을 사용하여 응답의 HTML 콘텐츠 구문 분석하기

soup = BeautifulSoup(response.content, 'html.parser')

# CSS 선택기를 사용하여 <div> 태그 안에 있는 모든 <h1> 태그를 찾습니다.

# 의 직계 자식인 <body> 태그

h1_tags = soup.select('body > div > h1')

# 찾은 <h1> 태그 목록을 반복하여 텍스트 콘텐츠를 인쇄합니다.

for tag in h1_tags:

print(tag.text)

구문 분석 오류는 HTML 또는 XML 구조가 예상과 다를 때 발생하며 데이터 추출에 문제를 일으킵니다. 이러한 오류는 AttributeError와 같은 예외를 처리하여 관리할 수 있습니다.

from bs4 import BeautifulSoup

import requests

# 스크랩할 웹페이지의 URL

url = 'https://example.com'

# URL로 HTTP GET 요청을 보냅니다.

response = requests.get(url)

try:

# Beautiful Soup을 사용하여 응답의 HTML 콘텐츠 구문 분석하기

soup = BeautifulSoup(response.content, 'html.parser')

# CSS 선택기를 사용하여 <div> 태그 안에 있는 모든 <h1> 태그를 찾습니다.

# 의 직계 자식인 <body> 태그

h1_tags = soup.select('body > div > h1')

# 찾은 <h1> 태그 목록을 반복하여 텍스트 콘텐츠를 인쇄합니다.

for tag in h1_tags:

print(tag.text)

except AttributeError as attr_err:

# 속성 오류가 발생할 수 있는 경우를 처리합니다(예: 응답.내용이 None인 경우).

print(f'Attribute error occurred: {attr_err}')

except Exception as parse_err:

# 구문 분석 중에 발생할 수 있는 다른 예외를 처리합니다.

print(f'Error while parsing HTML: {parse_err}')

Beautiful Soup 외에도 Python에서 HTML 및 XML 문서를 구문 분석하는 데 널리 사용되는 또 다른 라이브러리는 lxml입니다. BeautifulSoup은 구문 분석된 데이터를 탐색하고 조작하기 위한 편리한 인터페이스를 제공하는 데 중점을 두는 반면, lxml은 속도와 유연성으로 유명하기 때문에 성능이 중요한 작업에 선호됩니다.

from lxml.html import fromstring

import requests

# 스크랩할 웹페이지의 URL

url = 'https://example.com'

# URL로 HTTP GET 요청을 보냅니다.

response = requests.get(url)

# lxml의 fromstring 메서드를 사용하여 응답의 HTML 콘텐츠를 구문 분석합니다.

parser = fromstring(response.text)

# XPath를 사용하여 첫 번째 <h1> 태그의 텍스트 콘텐츠를 찾습니다.

# 태그 안에 있는 <body> 태그의 직계 자식인 <div> 태그입니다.

title = parser.xpath('/html/body/div/h1/text()')[0]

# 제목 인쇄

print(title)

Beautiful Soup과 마찬가지로 lxml을 사용하면 lxml.etree.XMLSyntaxError와 같은 예외를 포착하여 구문 분석 오류를 우아하게 처리할 수 있습니다.

from lxml.html import fromstring

from lxml import etree

import requests

# 스크랩할 웹페이지의 URL

url = 'https://example.com'

# URL로 HTTP GET 요청을 보냅니다.

response = requests.get(url)

try:

# lxml의 fromstring 메서드를 사용하여 응답의 HTML 콘텐츠를 구문 분석합니다.

parser = fromstring(response.text)

# XPath를 사용하여 첫 번째 <h1> 태그의 텍스트 콘텐츠를 찾습니다.

# 태그 안에 있는 <body> 태그의 직계 자식인 <div> 태그입니다.

title = parser.xpath('/html/body/div/h1/text()')[0]

# 제목 인쇄

print(title)

except IndexError:

# XPath 쿼리가 결과를 반환하지 않는 경우 처리하기

print('No <h1> tag found in the specified location.')

except etree.XMLSyntaxError as parse_err:

# 구문 분석 중 XML 구문 오류 처리

print(f'Error while parsing HTML: {parse_err}')

except Exception as e:

# 기타 예외 처리

print(f'An unexpected error occurred: {e}')

HTML 요소에서 데이터를 성공적으로 추출했다면 다음 단계는 이 데이터를 저장하는 것입니다. Python은 스크랩한 데이터를 저장하기 위한 여러 가지 옵션을 제공하며, 여기에는 CSV 파일, JSON 파일 및 데이터베이스에 저장하는 방법이 포함됩니다. 다음은 다양한 형식을 사용하여 추출한 데이터를 저장하는 방법에 대한 개요입니다:

CSV(쉼표로 구분된 값)는 표 형식의 데이터를 저장하는 데 간단하고 널리 사용되는 형식입니다. Python의 CSV 모듈을 사용하면 CSV 파일에 데이터를 쉽게 쓸 수 있습니다.

import csv

# 샘플 데이터

data = {

'title': 'Example Title',

'paragraphs': ['Paragraph 1', 'Paragraph 2', 'Paragraph 3']

}

# 데이터를 CSV 파일로 저장

with open('scraped_data.csv', mode='w', newline='', encoding='utf-8') as file:

writer = csv.writer(file)

writer.writerow(['Title', 'Paragraph'])

for paragraph in data['paragraphs']:

writer.writerow([data['title'], paragraph])

print('Data saved to scraped_data.csv')

JSON(JavaScript 객체 표기법)은 읽기 및 쓰기가 쉬운 경량 데이터 교환 형식입니다. Python의 JSON 모듈은 데이터를 JSON 형식으로 저장하는 메서드를 제공합니다.

import json

# 샘플 데이터

data = {

'title': 'Example Title',

'paragraphs': ['Paragraph 1', 'Paragraph 2', 'Paragraph 3']

}

# 데이터를 JSON 파일에 저장

with open('scraped_data.json', mode='w', encoding='utf-8') as file:

json.dump(data, file, ensure_ascii=False, indent=4)

print('Data saved to scraped_data.json')

Playwright는 동적 콘텐츠를 스크랩하고 웹 요소와 상호 작용할 수 있는 강력한 도구입니다. 정적 HTML 파서가 처리할 수 없는 자바스크립트가 많은 웹사이트를 처리할 수 있습니다.

Playwright를 설치하고 설정합니다:

pip install playwright

playwright install

Playwright를 사용하면 양식 작성 및 버튼 클릭과 같은 웹 요소와 상호 작용할 수 있습니다. AJAX 요청이 완료될 때까지 기다렸다가 계속 진행할 수 있으므로 동적 콘텐츠를 스크랩하는 데 이상적입니다.

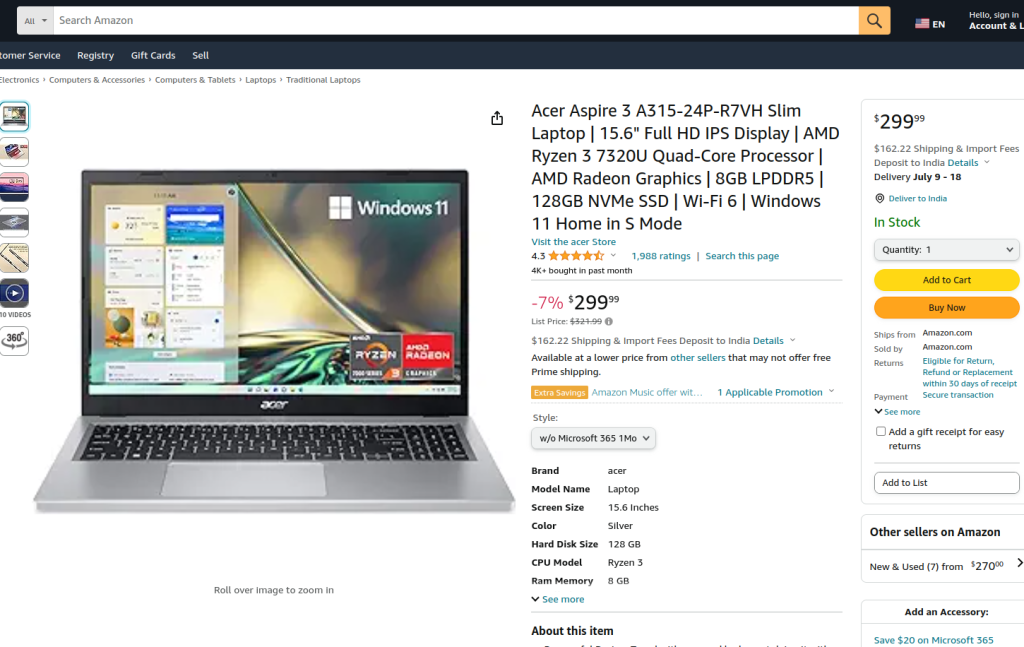

제공된 코드는 Playwright 및 lxml을 사용하여 Amazon 상품 페이지에서 웹 스크래핑을 수행합니다. 처음에는 필요한 모듈을 가져옵니다. 스크래핑 로직을 캡슐화하기 위해 실행 함수가 정의됩니다. 이 함수는 프록시 서버를 설정하고 프록시와 함께 비헤드리스 모드에서 새 브라우저 인스턴스를 실행하여 브라우저 동작을 관찰하는 것으로 시작합니다. 브라우저 컨텍스트 내에서 새 페이지가 열리고 지정된 Amazon 상품 URL로 이동하며, 페이지가 완전히 로드되도록 60초의 시간 제한이 설정됩니다.

그런 다음 스크립트는 페이지와 상호 작용하여 드롭다운 메뉴에서 특정 제품 스타일을 선택하고 로케이터 및 텍스트 매칭을 사용하여 제품 옵션을 선택합니다. 이러한 상호 작용이 완료되고 페이지가 다시 완전히 로드되면 페이지의 HTML 콘텐츠가 캡처됩니다.

그런 다음 HTML 콘텐츠는 lxml의 fromstring 메서드를 사용하여 구문 분석되어 요소 트리를 만듭니다. XPath 쿼리를 사용하여 제품 제목의 텍스트 콘텐츠를 ID가 productTitle인 특정 요소에서 추출합니다. 이 스크립트에는 XPath 쿼리가 결과를 반환하지 않거나 구문 분석 중에 XML 구문 오류가 발생하거나 기타 예기치 않은 예외가 발생하는 경우를 관리하는 오류 처리가 포함되어 있습니다. 마지막으로 추출된 제품 제목이 인쇄되고 브라우저 컨텍스트와 브라우저가 닫히면서 세션이 종료됩니다.

실행 함수는 sync_playwright로 시작된 Playwright 세션 내에서 실행되므로 전체 프로세스가 제어된 환경 내에서 관리되고 실행됩니다. 이 구조는 웹 스크래핑 작업을 수행하는 동안 견고성과 오류 복원력을 보장합니다.

from playwright.sync_api import Playwright, sync_playwright

from lxml.html import fromstring, etree

def run(playwright: Playwright) -> None:

# 프록시 서버 정의

proxy = {"server": "https://IP:PORT", "username": "LOGIN", "password": "PASSWORD"}

# 지정된 프록시를 사용하여 비헤드리스 모드에서 새 브라우저 인스턴스를 시작합니다.

browser = playwright.chromium.launch(

headless=False,

proxy=proxy,

slow_mo=50,

args=['--ignore-certificate-errors'],

)

# 새 브라우저 컨텍스트 만들기

context = browser.new_context(ignore_https_errors=True)

# 브라우저 컨텍스트에서 새 페이지 열기

page = context.new_page()

# 지정된 아마존 상품 페이지로 이동합니다.

page.goto(

"https://www.amazon.com/A315-24P-R7VH-Display-Quad-Core-Processor-Graphics/dp/B0BS4BP8FB/",

timeout=10000,

)

# 페이지가 완전히 로드될 때까지 기다립니다.

page.wait_for_load_state("load")

# 드롭다운 메뉴에서 특정 제품 스타일을 선택합니다.

page.locator("#dropdown_selected_style_name").click()

# 특정 제품 옵션 선택

page.click('//*[@id="native_dropdown_selected_style_name_1"]')

page.wait_for_load_state("load")

# 로드된 페이지의 HTML 콘텐츠 가져오기

html_content = page.content()

try:

# lxml의 fromstring 메서드를 사용하여 HTML 콘텐츠 구문 분석하기

parser = fromstring(html_content)

# XPath를 사용하여 제품 제목의 텍스트 콘텐츠를 추출합니다.

product_title = parser.xpath('//span[@id="productTitle"]/text()')[0].strip()

# 추출된 제품 제목 인쇄

print({"Product Title": product_title})

except IndexError:

# XPath 쿼리가 결과를 반환하지 않는 경우 처리하기

print('Product title not found in the specified location.')

except etree.XMLSyntaxError as parse_err:

# 구문 분석 중 XML 구문 오류 처리

print(f'Error while parsing HTML: {parse_err}')

except Exception as e:

# 기타 예외 처리

print(f'An unexpected error occurred: {e}')

# 브라우저 컨텍스트와 브라우저를 닫습니다.

context.close()

browser.close()

# sync_playwright를 사용하여 Playwright 세션을 시작하고 스크립트를 실행합니다.

with sync_playwright() as playwright:

run(playwright)

Python을 사용한 웹 스크래핑은 웹사이트에서 데이터를 수집하는 강력한 방법입니다. 설명한 도구는 다양한 목적으로 웹 데이터를 추출, 처리, 저장할 수 있도록 도와줍니다. 이 과정에서 프록시 서버를 사용해 IP 주소를 대체하고 요청 사이에 지연을 구현하는 것은 차단을 우회하는 데 매우 중요합니다. Beautiful Soup은 초보자에게 사용자 친화적인 반면, lxml은 효율성이 뛰어나 대용량 데이터 세트를 처리하는 데 적합합니다. 고급 스크래핑이 필요한 경우, 특히 동적으로 로드되는 자바스크립트 웹사이트에서는 Playwright가 매우 효과적인 것으로 입증되었습니다.

댓글: 0