fr

fr  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy est un framework robuste et de haut niveau conçu pour le web scraping et l'extraction de données, ce qui le rend idéal pour des tâches telles que l'analyse de données, la surveillance des prix, l'analyse du comportement des utilisateurs, la connaissance des médias sociaux et l'analyse du référencement. Ce framework est équipé pour traiter efficacement de grands volumes de données. Il comprend des mécanismes intégrés pour la gestion des requêtes HTTP, la gestion des erreurs et la conformité avec robots.txt, qui sont essentiels pour naviguer dans des projets de collecte de données web complexes et à grande échelle. Cette étude se penchera sur ce qu'est Scrapy, sur son fonctionnement et sur les fonctionnalités qu'il offre aux utilisateurs, afin de fournir une compréhension complète de ses capacités et de ses applications.

Le framework Scrapy est un puissant outil de scraping web open-source écrit en Python, conçu pour l'exploration et l'extraction de données structurées à partir de sites web. Il peut organiser les données extraites dans les formats JSON et CSV ou les stocker directement dans des bases de données telles que SQLite, MySQL, PostgreSQL et MongoDB. Scrapy prend en charge diverses méthodes d'analyse, notamment les sélecteurs CSS et XPath, et peut gérer les réponses JSON et XML, ce qui est crucial lorsqu'il s'agit d'API.

Scrapy fonctionne grâce à des "spiders", des robots d'indexation spécialisés qui suivent des instructions définies pour naviguer sur les pages web et récolter des données. Ces robots sont essentiellement des scripts qui identifient et capturent des types d'objets spécifiques tels que du texte, des images ou des liens. Un shell de crawling interactif fourni par Scrapy permet de tester et de déboguer ces spiders en temps réel, ce qui améliore considérablement le processus de configuration et d'optimisation du crawler.

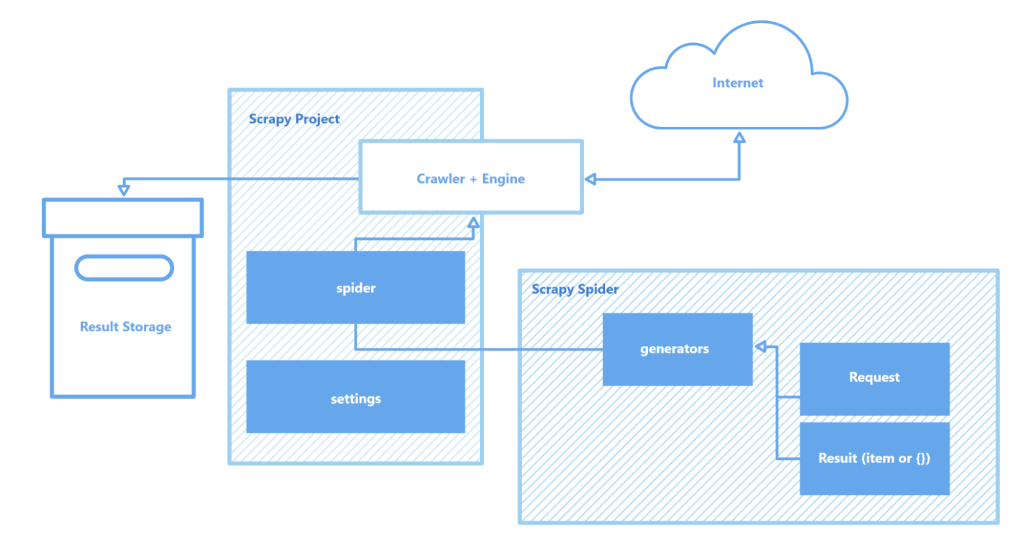

Les principaux éléments de l'architecture de Scrapy sont les suivants:

Dans l'ensemble, Scrapy s'impose comme l'un des outils de scraping web les plus robustes et les plus flexibles qui soient, adapté à toutes les tâches, des simples extractions de données aux projets complexes d'exploration du web à grande échelle.

Cette section met en évidence les principales caractéristiques du framework Scrapy: sa vitesse de collecte et de traitement des données, sa capacité à étendre ses fonctionnalités et sa portabilité. Ces attributs différencient Scrapy de ses concurrents et en font un choix populaire dans le domaine du web scraping.

Scrapy est basé sur Twisted, un moteur de réseau asynchrone open-source. Contrairement aux opérations synchrones où une tâche doit être achevée avant qu'une autre ne commence, Twisted permet d'exécuter des tâches en parallèle. Cela signifie que les spiders Scrapy peuvent envoyer plusieurs requêtes et traiter les réponses simultanément, améliorant ainsi la vitesse et l'efficacité de la collecte de données, en particulier pour les projets à grande échelle ou lors de l'analyse simultanée de plusieurs sites.

La vitesse de Scrapy est encore améliorée par plusieurs facteurs:

Ensemble, ces fonctionnalités font de Scrapy l'un des outils les plus rapides disponibles pour récupérer et collecter efficacement des données à partir d'une multitude de sites web, ce qui en fait une ressource inestimable pour des tâches telles que la surveillance du prix des produits, les offres d'emploi, la collecte d'informations, l'analyse des médias sociaux et la recherche académique.

L'architecture modulaire de Scrapy améliore son adaptabilité et son extensibilité, ce qui le rend bien adapté à une variété de tâches complexes de collecte de données. Sa prise en charge de l'intégration avec divers magasins de données tels que MongoDB, PostgreSQL et Elasticsearch, ainsi qu'avec des systèmes de gestion de file d'attente tels que Redis et RabbitMQ, permet de traiter efficacement d'importants volumes de données. En outre, Scrapy peut s'intégrer à des plateformes de surveillance ou de journalisation telles que Prometheus ou Logstash, ce qui permet de créer des configurations de scraper évolutives et personnalisables pour des projets allant de la collecte de données d'apprentissage automatique au développement de moteurs de recherche.

Composants extensibles de l'architecture de Scrapy:

En outre, la capacité de Scrapy à prendre en charge des modules personnalisés pour les interactions avec les API offre un cadre solide pour la mise à l'échelle et l'adaptation des solutions afin de répondre aux demandes de traitement de données à grande échelle et aux exigences de projets complexes.

Un autre avantage important de Scrapy est sa portabilité. Le framework prend en charge plusieurs systèmes d'exploitation, notamment Windows, macOS et Linux, ce qui le rend polyvalent pour une utilisation dans divers environnements de développement. L'installation est simple à l'aide du gestionnaire de paquets Python (pip), et grâce à la structure modulaire et à la configuration flexible de Scrapy, les projets peuvent facilement être transférés d'une machine à l'autre sans changements significatifs.

En outre, Scrapy prend en charge les environnements virtuels, qui isolent les dépendances du projet et évitent les conflits avec d'autres paquets installés. Cette fonctionnalité est particulièrement utile lorsque l'on travaille simultanément sur plusieurs projets ou que l'on déploie des applications sur un serveur, afin de garantir un environnement de développement propre et stable.

Pour un travail plus efficace avec Scrapy, il est recommandé d'utiliser un éditeur de code comme Visual Studio Code (VS Code) ou ses analogues, puisque l'interaction avec le framework se fait via la ligne de commande (CLI). Cela permet de gérer les projets, d'analyser les sites et de configurer les spiders plus efficacement. En outre, l'utilisation d'environnements virtuels pour gérer les dépendances permet d'éviter les conflits entre les bibliothèques et les versions des paquets, ce qui garantit un flux de travail plus fluide.

La création et l'exécution d'un projet dans Scrapy impliquent une série d'étapes simples:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Paramètres du projet

myproject/

__init__.py

items.py # Définitions du modèle de données

middlewares.py # Middlewares

pipelines.py # Traitement des données

settings.py # Paramètres de Scrapy

spiders/ # Dossier araignées

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Ici, "quotes" est le nom du spider défini dans la classe QuotesSpider. Scrapy exécutera le spider pour explorer l'URL spécifiée et extraire les données selon les paramètres définis.

scrapy crawl quotes -o quotes.json

Scrapy est un cadre robuste et gratuit de scraping web conçu pour fournir aux développeurs des outils complets pour l'extraction et le traitement automatisés de données à partir de pages web. Son architecture asynchrone et sa structure modulaire garantissent une vitesse élevée et une excellente évolutivité, ce qui facilite l'extension des fonctionnalités en fonction des besoins. En outre, l'intégration transparente de Scrapy avec diverses bibliothèques et solutions de stockage de données, ainsi que la prise en charge de protocoles personnalisés, simplifient la personnalisation du crawler pour répondre aux exigences spécifiques d'un projet. Cela rend le processus de web scraping non seulement plus efficace, mais aussi plus adaptable et plus convivial.

Commentaires: 0