fr

fr  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapoxy est un agrégateur de proxy automatisé qui aide à gérer différents outils et processus qui facilitent et sécurisent le web scraping. Une chose importante, Scrapoxy ne fournit pas de services de scraping, ni de serveurs proxy. Il se situe en arrière-plan et l'application aide à contrôler et à gérer les serveurs proxy et à acheminer les requêtes par le biais de chaque serveur afin d'éliminer les risques d'être bloqué en raison d'une activité de scraping excessive.

La technique de collecte d'informations à l'aide de Scrapoxy se déroule en trois étapes:

Ensuite, nous allons nous pencher sur le fonctionnement de Scrapoxy et sur les avantages qu'il offre. Une vue d'ensemble est fournie avec des captures d'écran de Scrapoxy, afin de faciliter la compréhension.

Pour commencer, examinons de près les caractéristiques de l'application. Scrapoxy sert d'agrégateur pour les serveurs proxy et augmente les capacités des outils de scraping en effectuant des tâches de collecte sûres et efficaces, il peut être considéré comme un outil de gestion des serveurs proxy avec quelques caractéristiques importantes:

Scrapoxy est un outil flexible qui accepte toute forme d'adresse IP, qu'elle soit dynamique ou statique, ce qui démontre son utilité en tant qu'outil. Il permet de configurer les éléments suivants:

En effet, Scrapoxy est un excellent choix pour un large éventail de tâches de web scraping et de gestion du trafic. En outre, il est compatible avec différents types de protocoles, tels que HTTP/HTTPS et SOCKS, et permet de les utiliser, ce qui permet de le configurer en fonction des exigences du projet en question.

Scrapoxy prend en charge la gestion de la rotation automatique des proxys, ce qui renforce l'anonymat et permet à l'utilisateur d'être bloqué lorsqu'il visite des sites web. La rotation des serveurs mandataires est un processus qui consiste à modifier les serveurs mandataires à des intervalles de temps spécifiques, et les autres adresses IP sont distribuées en conséquence pour préserver l'anonymat, et les sites web ciblés sont moins susceptibles d'être détectés et soumis à des restrictions.

Cette fonction unique remplit les deux objectifs de l'utilisation d'un serveur proxy, en améliorant la sécurité du trafic de trace et en minimisant les risques de blocage. Elle permet également d'équilibrer le trafic sans encombrer un seul proxy. La rotation automatique des serveurs mandataires est simple à mettre en œuvre dans le cadre de l'utilisation de Scrapoxy, à condition que le contrôle et la gestion de la vaste réserve d'adresses IP soient automatisés.

Une autre caractéristique de Scrapoxy est l'examen détaillé de tout le trafic envoyé et reçu dans le cadre du processus d'exploration du web, parallèlement à la session de l'utilisateur. Cette fonction est avantageuse car elle permet de surveiller plusieurs paramètres, à savoir

Ces informations sont à jour tout en fournissant un contrôle logique approfondi des avantages de la section métrique de Scrapoxy disponible. Avec ce type de contrôle, les utilisateurs pourraient comprendre l'efficacité de leurs sessions de scraping lorsqu'ils utilisent des serveurs proxy uniques et disposer de l'information dans un format facile qui leur permettrait d'approfondir l'information avec beaucoup plus de détails à des fins d'analyse.

Les fonctionnalités de Scrapoxy comprennent la surveillance et la détection automatique des serveurs proxy bloqués, ce qui signifie que les proxys qui sont hors ligne ou qui deviennent dysfonctionnels sont bloqués par Scrapoxy. Cela permet de s'assurer que le proxy invalide n'est pas utilisé pour le scraping et que la collecte des données se fait sans heurts.

En ce qui concerne les proxys bloqués, les utilisateurs disposent d'options via la gestion web de Scrapoxy et la mise à disposition d'une API. Dans l'interface web, il est possible de voir les serveurs proxy avec leurs statuts et de marquer manuellement un proxy comme étant bloqué. Cette fonctionnalité fait partie des capacités plus larges de Scrapoxy pour gérer efficacement les serveurs mandataires. Par ailleurs, l'API de Scrapoxy permet d'automatiser ce processus, ce qui rend la gestion des serveurs proxy beaucoup plus rationnelle et efficace.

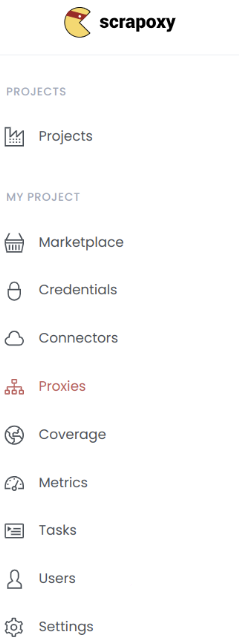

Alors, comment fonctionne Scrapoxy? Pour accéder à l'interface, Scrapoxy doit d'abord être installé via Docker ou Nodejs. Après l'installation, l'application offre une interface web fluide avec une UX conviviale où toutes les fonctions principales de Scrapoxy sont accessibles à l'utilisateur.

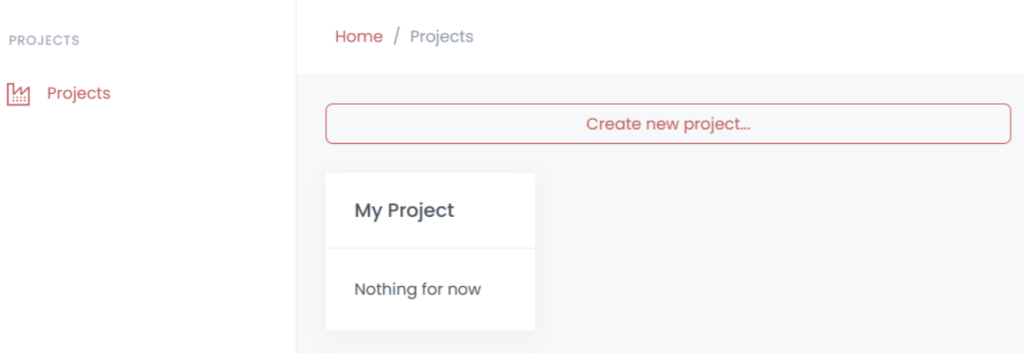

Pour tous les projets créés, cet onglet permet de les suivre. S'il n'y a aucun projet, vous pouvez vous rendre dans cette partie et sélectionner l'onglet "Paramètres" afin d'en créer un. Des données de base sont incluses dans chacune des entrées du projet, ainsi que la possibilité d'approfondir et de modifier la configuration.

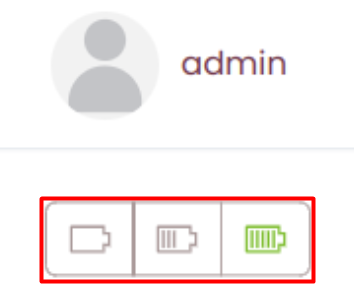

Un projet dans cette liste peut contenir plusieurs statuts avec la signification de l'état opérationnel:

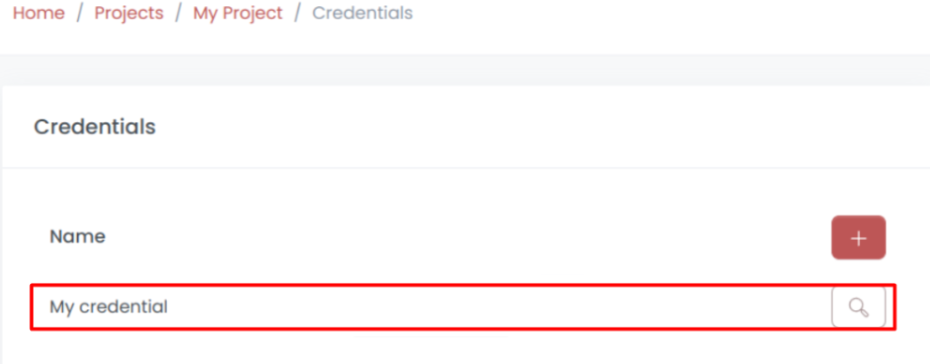

Une fois le projet configuré, un compte est généré, dont les paramètres sont le fournisseur, le nom et le jeton. Les comptes disposent de la configuration requise pour se connecter et s'autoriser à utiliser les fournisseurs de services en nuage. Lors de la saisie des informations d'identification du compte, le logiciel vérifie l'exactitude des détails fournis. Dès que les informations d'identification sont confirmées, les paramètres sont enregistrés et l'application passe à l'onglet nécessaire pour fournir les détails. Vous trouverez sur cette page le nom du projet, le nom du fournisseur de services en nuage et une option permettant de modifier les paramètres du compte en détail.

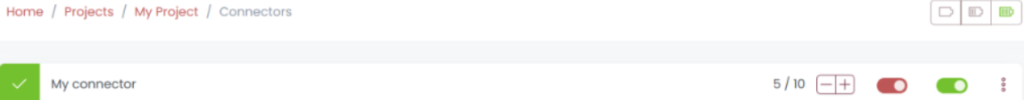

L'onglet Connecteurs affiche une liste de tous les connecteurs, qui sont des modules permettant à l'agrégateur Scrapoxy d'interagir avec divers fournisseurs de cloud pour créer et gérer des serveurs proxy.

Lors de la configuration d'un connecteur, les informations suivantes doivent être fournies:

Tous les connecteurs qui ont été ajoutés sont affichés dans la section "Connecteurs". Pour chacun des connecteurs présentés, les données suivantes peuvent être affichées dans la fenêtre centrale:

Les connecteurs ont trois états: "ON", "OFF" et "ERROR". Les connecteurs peuvent être édités si nécessaire pour mettre à jour les données et vérifier leur validité.

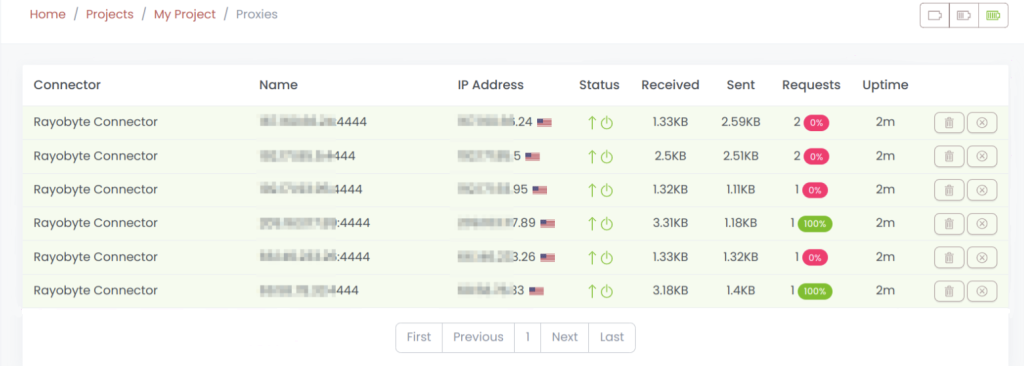

Cet onglet est assez polyvalent et permet d'afficher une liste de serveurs proxy, en spécifiant leurs noms, leurs adresses IP et leurs statuts. Cette page permet également de gérer les serveurs proxy. Dans ce cas, vous avez la possibilité de supprimer ou de désactiver les serveurs proxy en cas de besoin.

Dans la colonne d'état, les symboles représentent un état particulier de chaque serveur proxy:

À côté, une icône indique l'état de la connexion pour chaque proxy. Elle indique brièvement s'il est en ligne, hors ligne ou s'il y a un problème de connexion.

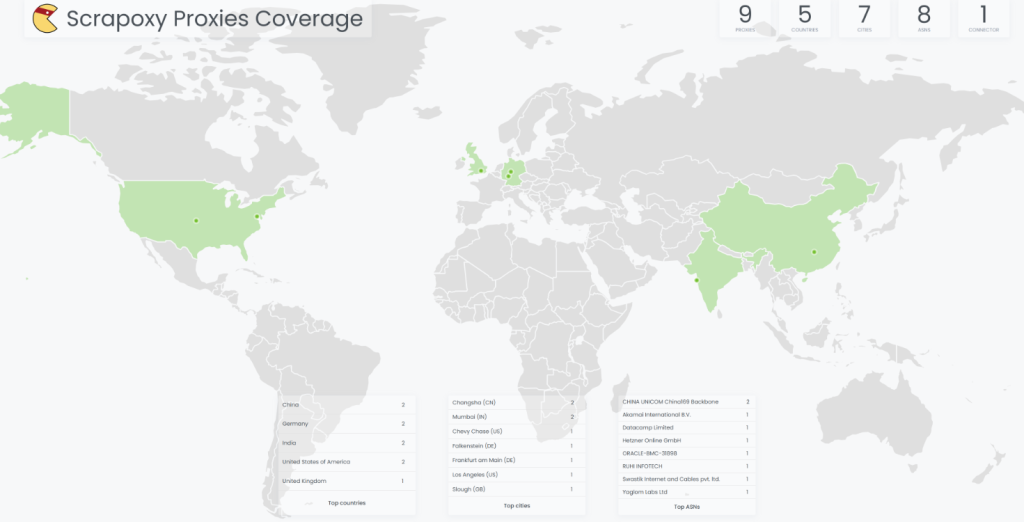

Lorsque vous importez une série de serveurs proxy dans Scrapoxy, le programme analyse automatiquement leur géolocalisation et génère une carte de couverture, accessible dans cette section. Cette fonction complète les statistiques par une carte, qui comprend:

En effet, l'évaluation de la source et la garantie d'une couverture complète de la carte du monde permettent d'améliorer l'efficacité du web scraping.

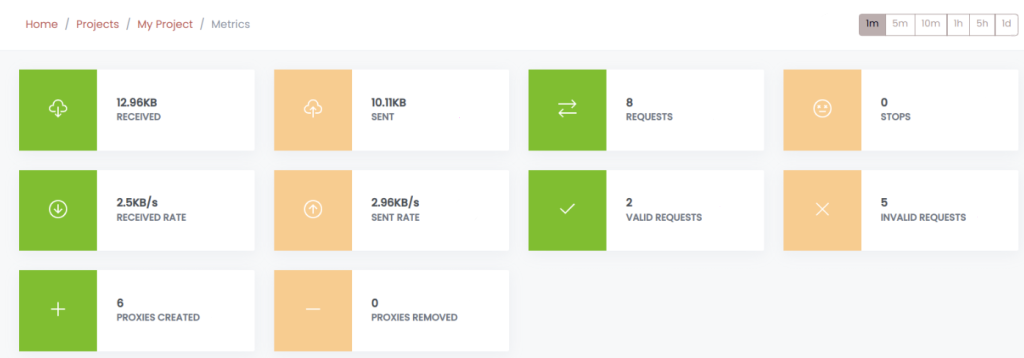

Cette section fournit une vue d'ensemble du projet et comprend une variété d'indicateurs. À partir de là, il est possible de diviser le panneau principal en plusieurs sections qui représentent les données essentielles des entreprises concernées. Sur le panneau supérieur, les utilisateurs ont la possibilité de sélectionner une certaine période de temps que Scrapoxy utilisera ensuite pour afficher des données analytiques. Les détails des serveurs proxy qui ont été exécutés dans les projets spécifiés sont donnés ci-dessous:

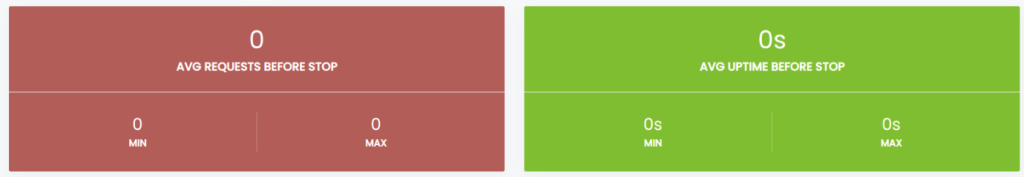

Des informations supplémentaires sont fournies pour l'analyse des serveurs proxy qui ont été supprimés du pool:

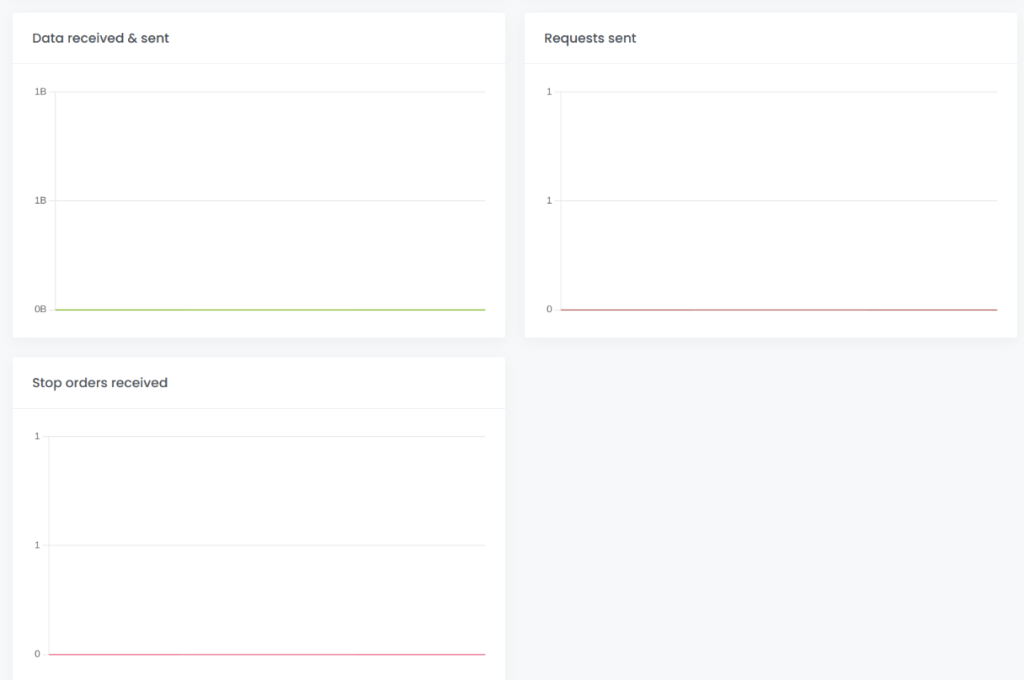

En outre, l'onglet contient des graphiques contenant des informations sur les données envoyées et reçues, le nombre de requêtes effectuées, le nombre d'ordres stop reçus dans les limites de temps supérieure et inférieure fixées.

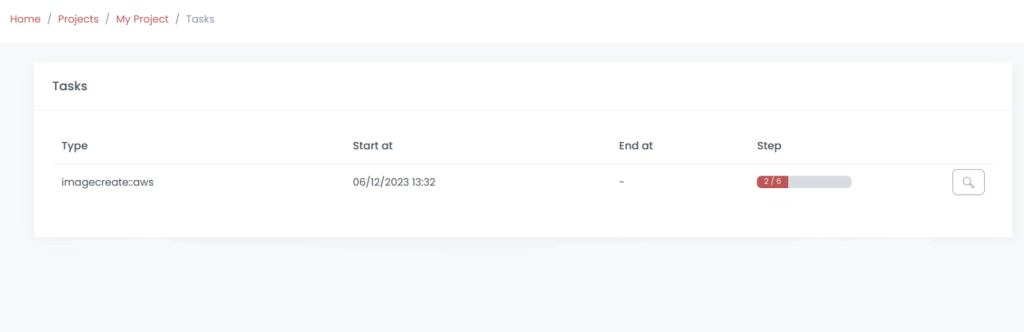

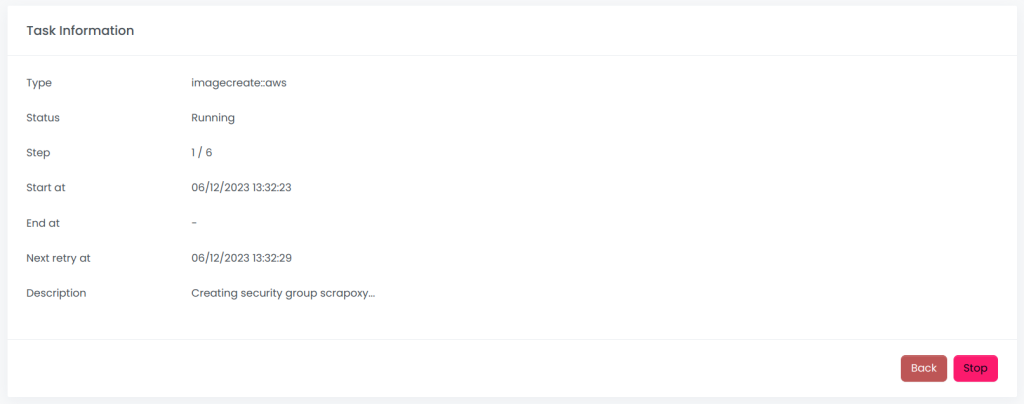

C'est ici que sont affichées toutes les tâches qui ont fait appel aux services de Scrapoxy. Ainsi, les informations suivantes sont présentées pour chaque tâche:

Lorsqu'une tâche est sélectionnée, vous avez la possibilité d'obtenir des informations plus détaillées sur cette tâche et sa composition, ainsi que de programmer des réexécutions. Une fonction d'arrêt des tâches est également prévue.

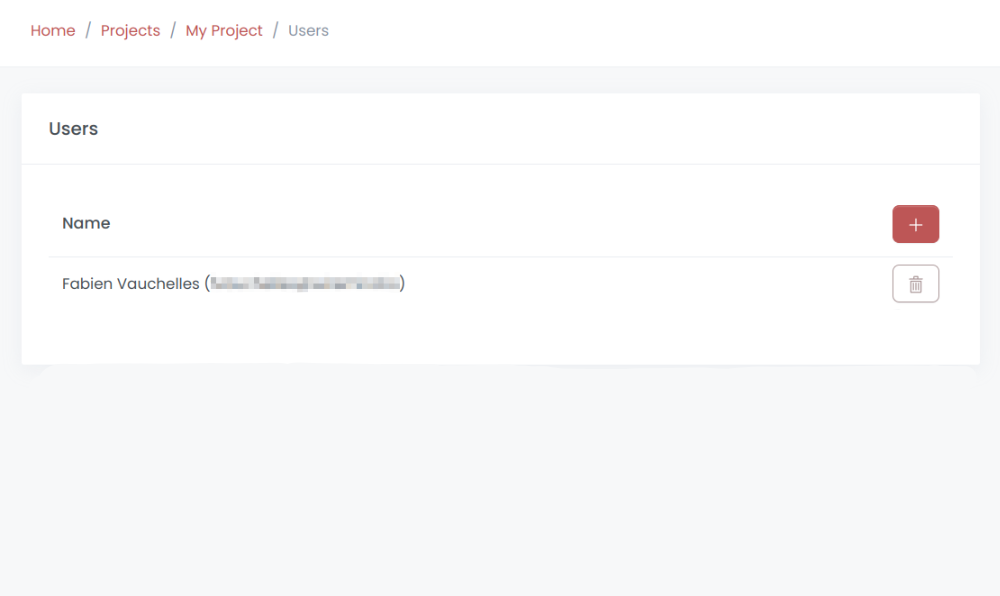

En ouvrant cet onglet, les utilisateurs peuvent voir tous les utilisateurs qui sont affectés aux projets ou qui y ont accès, y compris leur nom et leur adresse électronique. En outre, à partir de cet emplacement, les utilisateurs peuvent supprimer ou ajouter des utilisateurs sur une liste. Toutefois, il est important de noter qu'un utilisateur ne peut pas se supprimer lui-même d'un projet, car cette opération est effectuée par un autre utilisateur autorisé à le faire.

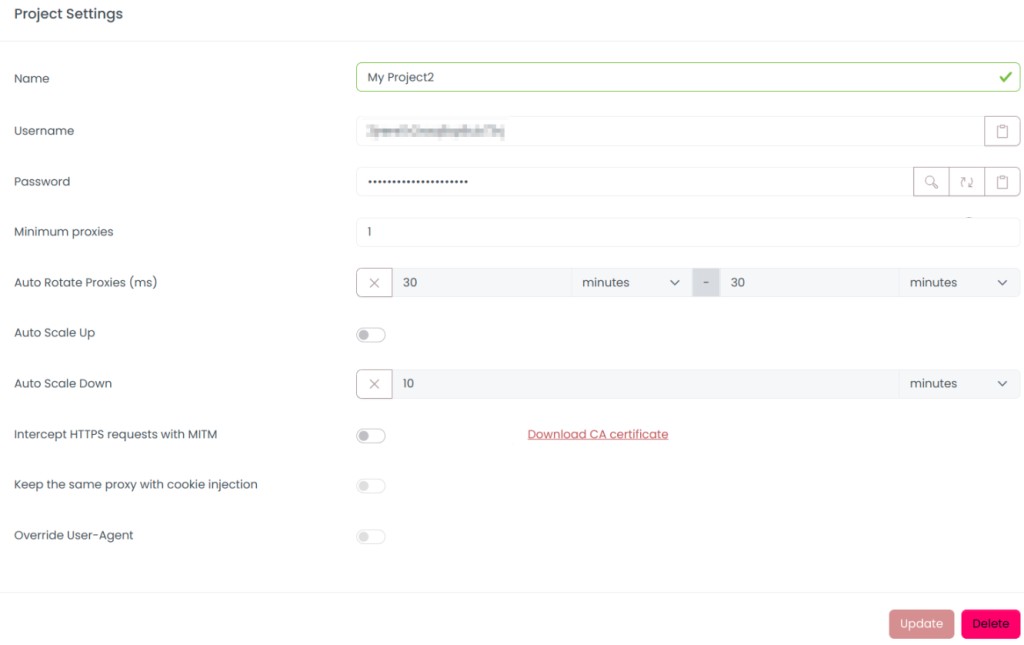

Lorsque vous vous connectez pour la première fois à Scrapoxy, cet onglet s'ouvre, vous permettant de configurer les paramètres du projet. Cette fenêtre contient des informations telles que

Une fois que tout a été modifié et reconfiguré, vous pouvez maintenant créer un nouveau compte pour le projet.

Pour intégrer Proxy-Seller à Scrapoxy et configurer le proxy, suivez les étapes utiles ci-dessous:

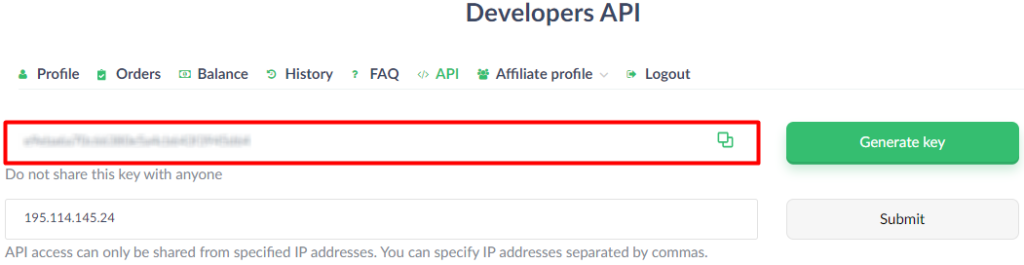

Connectez-vous à votre compte sur le site du Proxy-Seller et allez à la section API.

Conservez les jetons API du Proxy-Seller pour une utilisation ultérieure, car ils sont nécessaires pour relier le proxy à Scrapoxy.

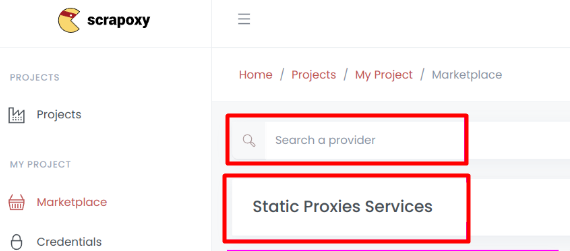

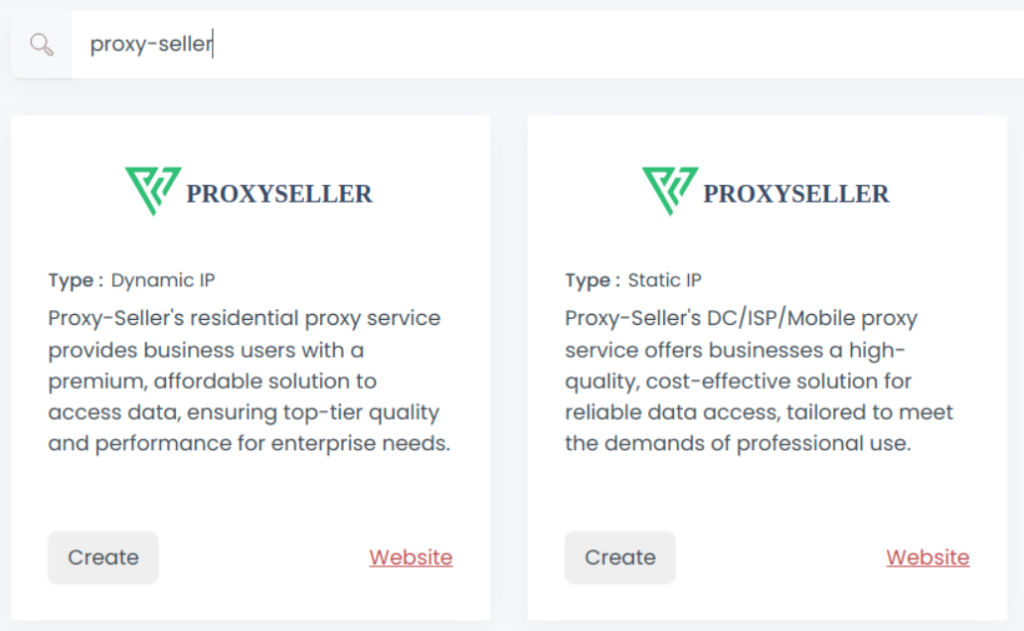

Lancez l'interface web de Scrapoxy et accédez à la "Place de marché". Utilisez la barre de recherche pour localiser le Proxy-Seller en filtrant avec le nom ou le type.

Choisissez le type de mandataire que vous souhaitez créer. Cliquez ensuite sur "Créer" pour tenter d'établir un nouveau compte.

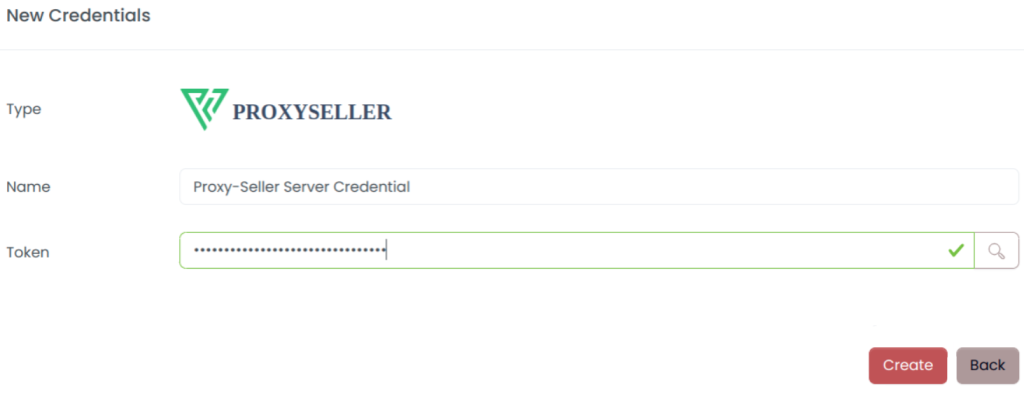

De la même manière que vous avez sauvegardé le jeton de votre compte, vous devez maintenant fournir le nom et le jeton. Une fois ces informations confirmées, cliquez sur le bouton "Créer".

Sélectionnez Proxy-Seller comme fournisseur. Procédez à la création d'un nouveau connecteur. Une fois créé, le nouveau connecteur sera affiché sous la liste principale où vous pourrez l'activer ou le désactiver.

![]()

La configuration du proxy pour Scrapoxy est maintenant terminée, et les tâches d'analyse des données dans le rotateur de proxy de l'application seront effectuées en utilisant les proxys connectés.

En résumé, Scrapoxy est peut-être le meilleur agrégateur de proxy car il vous permet de gérer et de distribuer efficacement plusieurs serveurs proxy pour les besoins du web scraping. De plus, le gestionnaire de proxy aide à dissimuler l'identité de l'auteur des requêtes et simplifie grandement les processus d'extraction de données. Scrapoxy est une application simple qui peut être utilisée séparément ou en équipe en collaborant avec presque tous les fournisseurs de proxy et qui est gratuite.

Commentaires: 0