it

it  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy è un framework robusto e di alto livello progettato per lo scraping del web e l'estrazione dei dati, che lo rende ideale per attività come il parsing dei dati, il monitoraggio dei prezzi, l'analisi del comportamento degli utenti, gli approfondimenti sui social media e l'analisi SEO. Questo framework è in grado di gestire grandi volumi di dati in modo efficiente. Include meccanismi integrati per la gestione delle richieste HTTP, la gestione degli errori e la garanzia di conformità con robots.txt, che sono essenziali per gestire progetti di raccolta di dati web complessi e su larga scala. Questa recensione approfondisce cos'è Scrapy, come funziona e le caratteristiche che offre agli utenti, fornendo una comprensione completa delle sue capacità e applicazioni.

Il framework Scrapy è un potente strumento open-source di web scraping scritto in Python, progettato per il crawling ad alta efficienza e l'estrazione di dati strutturati dai siti web. Può organizzare i dati estratti in formati JSON e CSV o memorizzarli direttamente in database come SQLite, MySQL, PostgreSQL e MongoDB. Scrapy supporta diversi metodi di parsing, tra cui i selettori CSS e XPath, e può gestire risposte JSON e XML, un aspetto fondamentale quando si ha a che fare con le API.

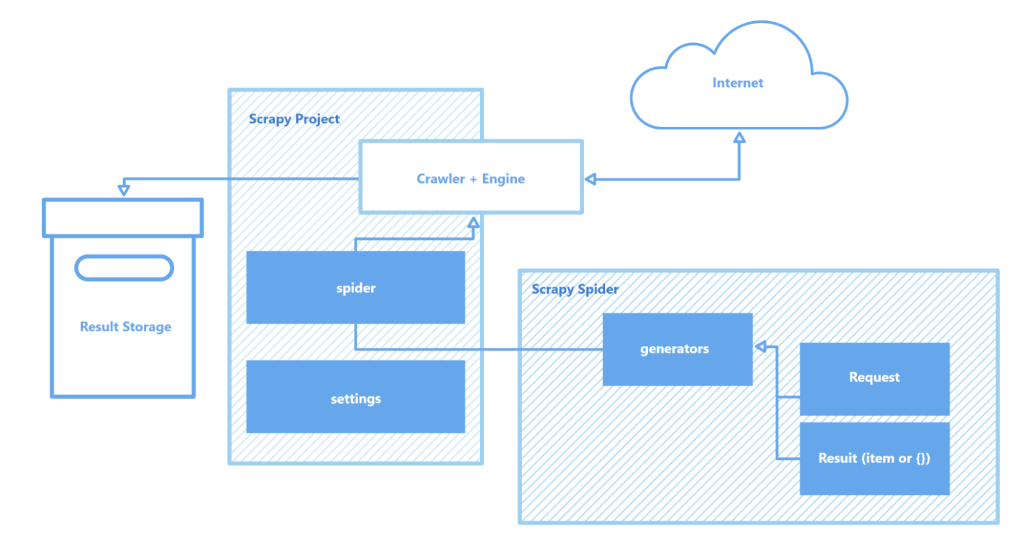

Scrapy opera attraverso "spiders" - crawler specializzati che seguono istruzioni definite per navigare nelle pagine web e raccogliere dati. Questi spider sono essenzialmente script che identificano e catturano tipi specifici di oggetti come testo, immagini o link. Una shell di crawling interattiva fornita da Scrapy consente di testare e debuggare questi spider in tempo reale, migliorando notevolmente il processo di configurazione e ottimizzazione del crawler.

I componenti chiave dell'architettura di Scrapy includono:

Nel complesso, Scrapy si distingue come uno degli strumenti di scraping web più robusti e flessibili disponibili, adatto a qualsiasi tipo di attività, dalla semplice estrazione di dati a complessi progetti di web mining su larga scala.

Questa sezione evidenzia le caratteristiche principali del framework Scrapy: la velocità di raccolta ed elaborazione dei dati, la capacità di estendere le funzionalità e la portabilità. Questi attributi differenziano Scrapy dai suoi concorrenti e lo rendono una scelta popolare nell'arena dello scraping web.

Scrapy è alimentato da Twisted, un motore di rete asincrono open-source. A differenza delle operazioni sincrone, in cui un'attività deve essere completata prima che ne inizi un'altra, Twisted consente l'esecuzione di attività in parallelo. Ciò significa che gli spider di Scrapy possono inviare più richieste ed elaborare le risposte simultaneamente, migliorando la velocità e l'efficienza nella raccolta dei dati, in particolare per progetti su larga scala o per la scansione di più siti contemporaneamente.

La velocità di Scrapy è ulteriormente incrementata da diversi fattori:

L'insieme di queste caratteristiche fa di Scrapy uno degli strumenti più veloci disponibili per lo scraping e la raccolta di dati da una moltitudine di siti web, rendendolo una risorsa preziosa per attività come il monitoraggio dei prezzi dei prodotti, gli annunci di lavoro, la raccolta di notizie, l'analisi dei social media e la ricerca accademica.

L'architettura modulare di Scrapy ne migliora l'adattabilità e l'estensibilità, rendendolo adatto a una varietà di compiti complessi di raccolta dati. Il supporto per l'integrazione con vari archivi di dati come MongoDB, PostgreSQL ed Elasticsearch, nonché con sistemi di gestione delle code come Redis e RabbitMQ, consente di gestire efficacemente grandi volumi di dati. Inoltre, Scrapy può integrarsi con piattaforme di monitoraggio o di logging come Prometheus o Logstash, consentendo configurazioni di scraper scalabili e personalizzabili per progetti che vanno dalla raccolta di dati di machine learning allo sviluppo di motori di ricerca.

Componenti estensibili dell'architettura di Scrapy:

Inoltre, la capacità di Scrapy di supportare moduli personalizzati per le interazioni con le API fornisce un quadro robusto per scalare e adattare le soluzioni alle esigenze di elaborazione dei dati su larga scala e ai requisiti di progetti complessi.

Un altro vantaggio significativo di Scrapy è la sua portabilità. Il framework supporta diversi sistemi operativi, tra cui Windows, macOS e Linux, rendendolo versatile per l'uso in vari ambienti di sviluppo. L'installazione è semplice grazie al gestore di pacchetti Python (pip) e, grazie alla struttura modulare e alla configurazione flessibile di Scrapy, i progetti possono essere facilmente trasferiti da una macchina all'altra senza modifiche significative.

Inoltre, Scrapy supporta gli ambienti virtuali, che isolano le dipendenze del progetto ed evitano conflitti con altri pacchetti installati. Questa caratteristica è particolarmente preziosa quando si lavora su più progetti contemporaneamente o quando si distribuiscono applicazioni su un server, garantendo un ambiente di sviluppo pulito e stabile.

Per un lavoro più efficace con Scrapy, si consiglia di utilizzare un editor di codice come Visual Studio Code (VS Code) o i suoi analoghi, poiché l'interazione con il framework avviene tramite la riga di comando (CLI). Ciò consente di gestire in modo più efficiente i progetti, la scansione dei siti e la configurazione degli spider. Inoltre, l'uso di ambienti virtuali per gestire le dipendenze può aiutare a evitare conflitti tra le librerie e le versioni dei pacchetti, garantendo un flusso di lavoro più fluido.

La creazione e l'esecuzione di un progetto in Scrapy comporta una serie di passaggi semplici:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Impostazioni del progetto

myproject/

__init__.py

items.py # Definizioni del modello di dati

middlewares.py # Middlewares

pipelines.py # Elaborazione dei dati

settings.py # Impostazioni di Scrapy

spiders/ # Cartella Ragni

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Qui, "quotes" è il nome dello spider definito nella classe QuotesSpider. Scrapy eseguirà lo spider per eseguire il crawling dell'URL specificato ed estrarre i dati in base alle impostazioni definite.

scrapy crawl quotes -o quotes.json

Scrapy è un robusto framework gratuito per lo scraping del web, progettato per fornire agli sviluppatori strumenti completi per l'estrazione e l'elaborazione automatica dei dati dalle pagine web. La sua architettura asincrona e la sua struttura modulare garantiscono un'elevata velocità e un'eccellente scalabilità, facilitando l'espansione delle funzionalità in base alle necessità. Inoltre, la perfetta integrazione di Scrapy con varie librerie e soluzioni di archiviazione dei dati, insieme al supporto di protocolli personalizzati, semplifica la personalizzazione del crawler per soddisfare i requisiti specifici del progetto. Questo rende il processo di scraping del web non solo più efficiente, ma anche più adattabile e facile da usare.

Commenti: 0