es

es  English

English  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy es un framework robusto y de alto nivel diseñado para el scraping web y la extracción de datos, por lo que es ideal para tareas como el análisis sintáctico de datos, la monitorización de precios, el análisis del comportamiento de los usuarios, el conocimiento de las redes sociales y el análisis SEO. Este framework está equipado para manejar grandes volúmenes de datos de forma eficiente. Incluye mecanismos integrados para gestionar peticiones HTTP, gestionar errores y garantizar el cumplimiento de robots.txt, que son esenciales para navegar por proyectos de recopilación de datos web complejos y a gran escala. Esta revisión profundizará en qué es Scrapy, cómo funciona y las características que ofrece a los usuarios, proporcionando una comprensión completa de sus capacidades y aplicaciones.

El framework Scrapy es una potente herramienta de scraping web de código abierto escrita en Python, diseñada para rastrear y extraer datos estructurados de sitios web con gran eficiencia. Puede organizar los datos extraídos en formatos JSON y CSV o almacenarlos directamente en bases de datos como SQLite, MySQL, PostgreSQL y MongoDB. Scrapy admite varios métodos de análisis sintáctico, incluidos selectores CSS y XPath, y puede manejar respuestas JSON y XML, algo crucial cuando se trata de API.

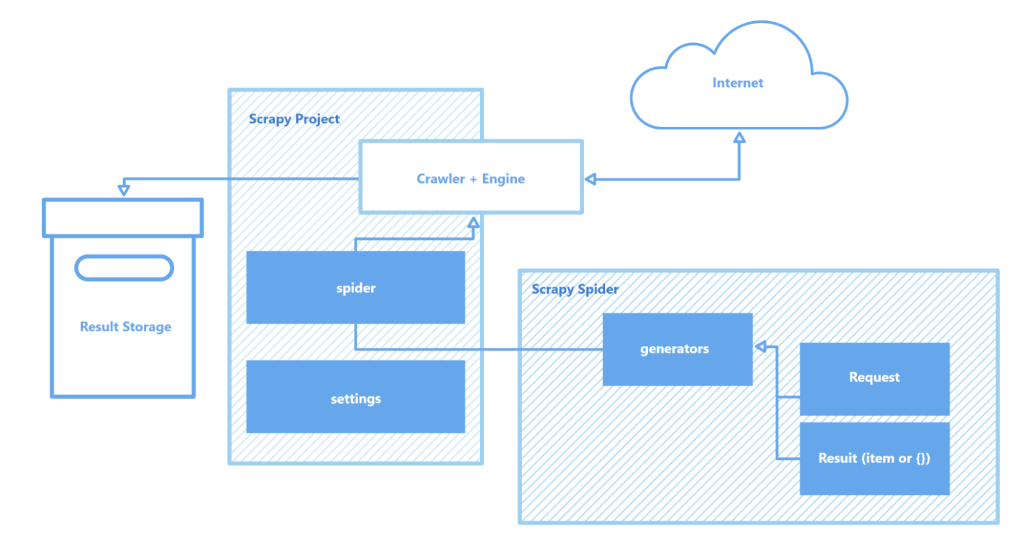

Scrapy opera a través de "arañas" - rastreadores especializados que siguen instrucciones definidas para navegar por páginas web y recopilar datos. Estas arañas son esencialmente scripts que identifican y capturan tipos específicos de objetos como texto, imágenes o enlaces. Un intérprete de comandos de rastreo interactivo proporcionado por Scrapy permite probar y depurar estas arañas en tiempo real, lo que mejora enormemente el proceso de configuración y optimización del rastreador.

Los componentes clave de la arquitectura de Scrapy son:

En general, Scrapy destaca como una de las herramientas de raspado web más robustas y flexibles disponibles, adecuada para todo, desde tareas sencillas de extracción de datos hasta complejos proyectos de minería web a gran escala.

Esta sección destaca las características clave del framework Scrapy: su velocidad en la recogida y procesamiento de datos, la posibilidad de ampliar su funcionalidad y su portabilidad. Estos atributos diferencian a Scrapy de sus competidores y lo establecen como una opción popular en el ámbito del web scraping.

Scrapy funciona con Twisted, un motor de red asíncrono de código abierto. A diferencia de las operaciones síncronas, en las que una tarea debe completarse antes de que comience otra, Twisted permite que las tareas se ejecuten en paralelo. Esto significa que las arañas de Scrapy pueden enviar varias solicitudes y procesar las respuestas simultáneamente, lo que aumenta la velocidad y la eficacia en la recopilación de datos, sobre todo en proyectos a gran escala o cuando se escanean varios sitios a la vez.

La velocidad de Scrapy se ve reforzada por varios factores:

Juntas, estas características establecen a Scrapy como una de las herramientas más rápidas disponibles para raspar y recopilar datos de forma eficiente de multitud de sitios web, lo que la convierte en un recurso inestimable para tareas como la monitorización de precios de productos, listados de empleo, recopilación de noticias, análisis de medios sociales e investigación académica.

La arquitectura modular de Scrapy mejora su adaptabilidad y extensibilidad, por lo que es muy adecuado para una variedad de tareas complejas de recopilación de datos. Su soporte para la integración con varios almacenes de datos como MongoDB, PostgreSQL y Elasticsearch, así como sistemas de gestión de colas como Redis y RabbitMQ, permite el manejo eficaz de grandes volúmenes de datos. Además, Scrapy puede integrarse con plataformas de monitorización o registro como Prometheus o Logstash, lo que permite configuraciones de scraper escalables y personalizables para proyectos que van desde la recopilación de datos de aprendizaje automático hasta el desarrollo de motores de búsqueda.

Componentes extensibles de la arquitectura de Scrapy:

Además, la capacidad de Scrapy para admitir módulos personalizados para interacciones API proporciona un marco sólido para escalar y adaptar soluciones que satisfagan las demandas de procesamiento de datos a gran escala y los requisitos de proyectos complejos.

Otra ventaja significativa de Scrapy es su portabilidad. El framework es compatible con múltiples sistemas operativos, incluidos Windows, macOS y Linux, lo que lo hace versátil para su uso en diversos entornos de desarrollo. La instalación es sencilla utilizando el gestor de paquetes de Python (pip), y gracias a la estructura modular de Scrapy y su configuración flexible, los proyectos pueden transferirse fácilmente entre máquinas sin cambios significativos.

Además, Scrapy soporta entornos virtuales, que aíslan las dependencias del proyecto y evitan conflictos con otros paquetes instalados. Esta característica es especialmente valiosa cuando se trabaja en varios proyectos simultáneamente o cuando se despliegan aplicaciones en un servidor, garantizando un entorno de desarrollo limpio y estable.

Para un trabajo más eficaz con Scrapy, se recomienda utilizar un editor de código como Visual Studio Code (VS Code) o sus análogos, ya que la interacción con el framework se realiza a través de la línea de comandos (CLI). Esto permite gestionar proyectos, escanear sitios y configurar arañas de forma más eficiente. Además, el uso de entornos virtuales para gestionar dependencias puede ayudar a evitar conflictos entre librerías y versiones de paquetes, garantizando un flujo de trabajo más fluido.

Crear y ejecutar un proyecto en Scrapy implica una serie de pasos sencillos:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Configuración del proyecto

myproject/

__init__.py

items.py # Definiciones de modelos de datos

middlewares.py # Middlewares

pipelines.py # Tratamiento de datos

settings.py # Configuración de Scrapy

spiders/ # Carpeta Arañas

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Aquí, "quotes" es el nombre de la araña definida en la clase QuotesSpider. Scrapy ejecutará la araña para rastrear la URL especificada y extraer los datos según la configuración que hayas definido.

scrapy crawl quotes -o quotes.json

Scrapy es un marco de trabajo de raspado web robusto y gratuito diseñado para ofrecer a los desarrolladores herramientas completas para la extracción y el procesamiento automatizados de datos de páginas web. Su arquitectura asíncrona y su estructura modular garantizan una alta velocidad y una excelente escalabilidad, facilitando la ampliación de la funcionalidad según sea necesario. Además, la perfecta integración de Scrapy con diversas bibliotecas y soluciones de almacenamiento de datos, junto con la compatibilidad con protocolos personalizados, simplifica la personalización del rastreador para satisfacer los requisitos específicos de cada proyecto. Esto hace que el proceso de web scraping no sólo sea más eficiente, sino también más adaptable y fácil de usar.

Comentarios: 0