it

it  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Helium Scraper è uno strumento avanzato per lo scraping del web, progettato per automatizzare il processo di estrazione dei dati dai siti web.

Questo strumento è ampiamente utilizzato nell'e-commerce per monitorare i prezzi e la disponibilità dei prodotti, consentendo alle aziende di analizzare i concorrenti e di mettere a punto le proprie strategie di prezzo. Inoltre, serve come risorsa preziosa nelle ricerche di marketing, raccogliendo dati sulle recensioni e sulle preferenze dei consumatori, che aiutano ad ottenere una comprensione completa delle dinamiche di mercato e del comportamento dei consumatori. Helium Scraper svolge anche un ruolo cruciale nella gestione della reputazione, automatizzando il monitoraggio delle menzioni online di aziende o prodotti e facilitando risposte tempestive ai feedback del pubblico.

Helium Scraper è dotato di diverse caratteristiche uniche che semplificano sia la configurazione iniziale che il processo di scraping. Una delle sue caratteristiche principali è l'interfaccia visiva, che consente agli utenti di estrarre i dati senza dover ricorrere alla codifica. Questo rende lo strumento altamente accessibile anche agli utenti che non possiedono conoscenze tecniche approfondite o competenze di programmazione.

Helium Scraper include modelli di progetto integrati che semplificano l'avvio di nuovi progetti di scraping. Questi modelli sono preconfigurati per indirizzare tipi di dati specifici, come dettagli di prodotti, prezzi, recensioni e informazioni di contatto da varie piattaforme online e siti di social media.

Gli utenti possono accedere a un'ampia selezione di modelli visitando il forum ufficiale di Helium Scraper. Questo forum ospita modelli creati sia dagli sviluppatori di Helium Scraper che dalla sua comunità di utenti. Dopo aver scaricato un modello, è possibile personalizzarlo facilmente per adattarlo ai requisiti specifici di un progetto. Questa caratteristica non solo riduce i tempi di configurazione, ma accelera anche il processo di raccolta dei dati.

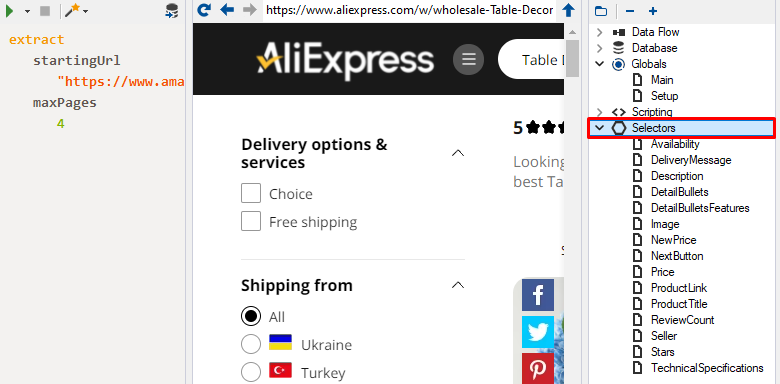

Helium Scraper dispone di selettori di dati avanzati che migliorano la capacità di identificare e selezionare con precisione gli elementi delle pagine web. Questi selettori sono altamente personalizzabili e si adattano agli ambienti dinamici delle moderne applicazioni web, dove gli ID e le classi degli elementi possono cambiare frequentemente. Questa adattabilità è fondamentale per eseguire efficacemente lo scraping di dati da siti web contemporanei e interattivi, dove i metodi di scraping tradizionali potrebbero non essere sufficienti.

I selettori avanzati di Helium Scraper consentono di creare regole di selezione complesse, permettendo agli utenti di adattare il processo di raccolta dei dati alle specifiche esigenze di accuratezza. Utilizzando sofisticati algoritmi per il riconoscimento dei modelli e la logica predittiva, questi selettori aiutano a garantire che vengano raccolte solo informazioni pertinenti e accurate, riducendo così la probabilità di catturare dati irrilevanti o errori.

L'integrazione di query SQL-like di Helium Scraper ne migliora la funzionalità, consentendo agli utenti di eseguire complesse operazioni di elaborazione dei dati direttamente durante il processo di scraping. Questa caratteristica si distingue perché consente non solo di filtrare e ordinare i dati, ma anche di aggregarli subito dopo l'estrazione. Queste funzionalità semplificano la preparazione dei dati per l'analisi e l'esportazione, riducendo significativamente la necessità di fasi di post-elaborazione.

Gli utenti possono costruire query sofisticate per generare report dettagliati, analizzare le tendenze del mercato o preparare i dati per i successivi processi aziendali. Questa funzionalità offre una comprensione approfondita dei dati raccolti e facilita rapidi aggiustamenti della strategia in risposta all'evoluzione delle condizioni di mercato. L'inclusione di funzionalità di interrogazione di tipo SQL trasforma Helium Scraper da semplice strumento di raccolta dati in una solida piattaforma di elaborazione analitica.

Helium Scraper si distingue da altri strumenti per il fatto di offrire il prezzo sotto forma di un pagamento unico, che garantisce l'accesso perpetuo alle sue caratteristiche. È importante notare che tutte le funzionalità sono disponibili per qualsiasi livello di abbonamento, con variazioni solo nel numero di utenti simultanei consentiti e nell'entità del supporto online fornito. Inoltre, gli utenti hanno la possibilità di testare lo strumento con una versione di prova di 10 giorni. Di seguito analizzeremo in dettaglio le varie tariffe disponibili e le loro caratteristiche specifiche.

Ideale per i singoli utenti, questo piano fornisce l'accesso completo a tutte le funzionalità dello scraper. Include tre mesi di aggiornamenti globali e aggiornamenti di routine illimitati. Al prezzo di 99 dollari, è un'opzione conveniente per chi inizia o per chi gestisce progetti più piccoli.

Progettato per un massimo di due utenti, questo piano include un mese di supporto premium e sei mesi di aggiornamenti globali. È adatto ai professionisti che cercano un supporto più esteso e un accesso agli aggiornamenti più lungo, con un costo una tantum di 199 dollari.

Per i piccoli team, questo piano consente a un massimo di cinque dipendenti di utilizzare lo scraper. Offre tre mesi di supporto premium e un abbonamento annuale agli aggiornamenti chiave, rendendolo ideale per i progetti di collaborazione all'interno delle aziende. Questo piano è disponibile al prezzo di 399 dollari.

L'opzione più completa è pensata per progetti su larga scala e fino a dieci membri del team. Questo piano offre sei mesi di supporto online premium e due anni di accesso agli aggiornamenti chiave, per le aziende con esigenze di scraping di dati estese. Il costo dell'abbonamento è di 699 dollari.

| Tariffa | Basic | Professional | Business | Enterprise |

|---|---|---|---|---|

| Prezzo | $99 | $199 | $399 | $699 |

| Accesso a tutte le funzioni dello scraper | Sì | Sì | Sì | Sì |

| Numero di utenti | 1 | 2 | 5 | 10 |

| Supporto premium | No | 1 mese | 3 mesi | 6 mesi |

| Numero illimitato di aggiornamenti di base | Sì | Sì | Sì | Sì |

L'interfaccia di Helium Scraper è stata realizzata per garantire la comodità e l'efficienza dell'utente, con un design visivo semplice e privo di elementi inutili. Di seguito, analizzeremo in dettaglio tutte le schede e le opzioni principali che facilitano la navigazione e il funzionamento senza interruzioni.

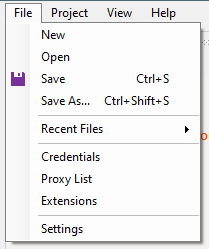

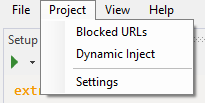

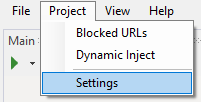

In questa scheda gli utenti possono creare un nuovo progetto, caricarne uno esistente e salvare i progetti secondo le necessità. Le opzioni aggiuntive includono:

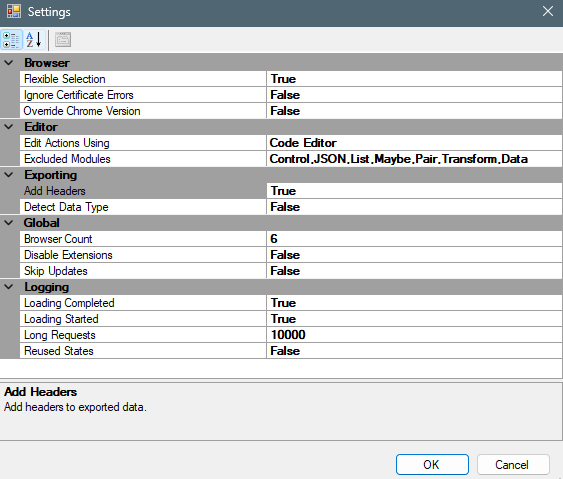

Inoltre, nella sezione "Impostazioni" gli utenti possono regolare le impostazioni globali del parser per personalizzare il processo di scraping in base alle proprie esigenze.

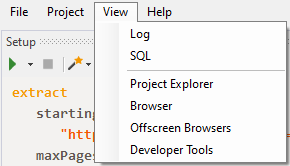

La scheda successiva è suddivisa in due opzioni principali:

Sono inclusi ulteriori strumenti per migliorare la trasparenza e la gestibilità del processo di scraping:

In seguito analizzeremo in dettaglio la finestra di lavoro principale e le sue varie funzionalità.

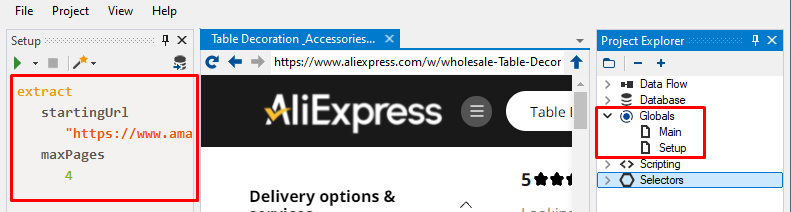

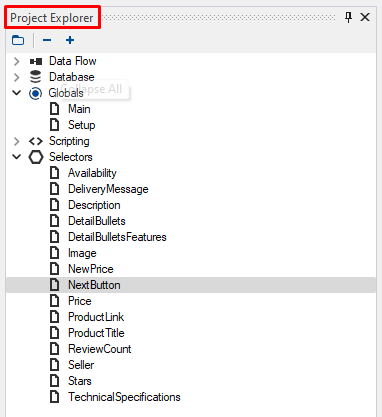

La finestra di lavoro principale, situata sul lato destro dello schermo, funge da fulcro centrale per la gestione di tutti gli aspetti dei progetti di scraping. Qui gli utenti possono navigare tra i loro progetti, visualizzare la struttura dei dati raccolti e accedere agli script disponibili. Per utilizzare questo menu, gli utenti devono prima creare un progetto all'avvio del programma.

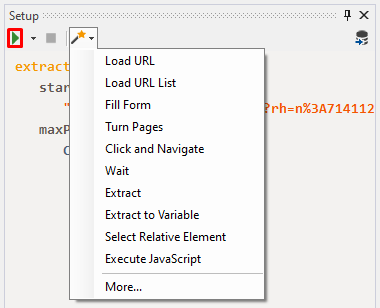

Sul lato sinistro della schermata, l'utente può configurare lo script di parsing e osservarne la struttura. Quest'area consente anche di avviare o arrestare lo script. Facendo clic sull'icona raffigurata nella schermata, si può aprire un menu che fornisce ulteriori opzioni per il progetto.

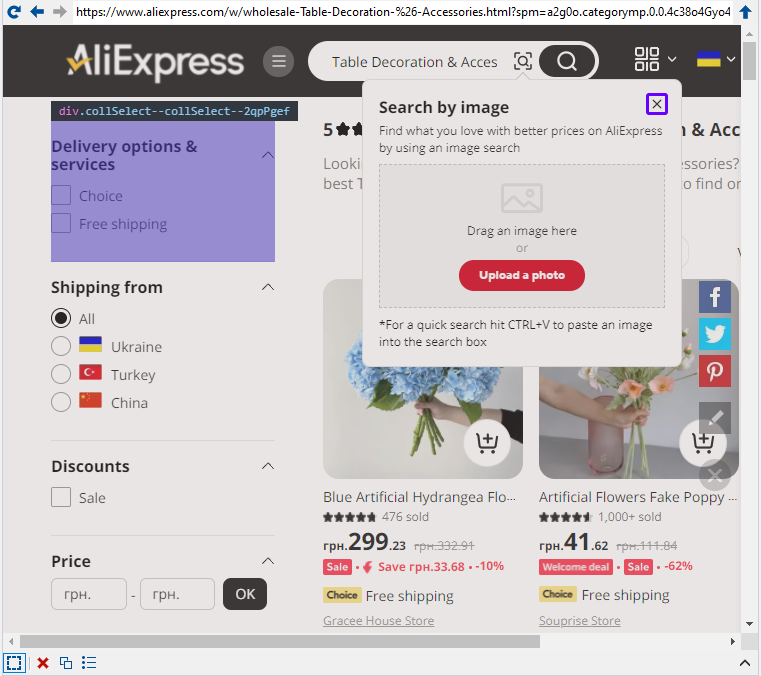

Al centro dello schermo è presente una finestra del browser, che offre un maggiore controllo sul processo di scraping attraverso l'interfaccia visiva della pagina da scrapare.

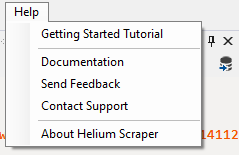

La scheda "Aiuto" di Helium Scraper fornisce risorse essenziali per la formazione e l'assistenza. Include una "Guida introduttiva" per i nuovi utenti, una "Documentazione" completa con tutorial dettagliati e informazioni utili, un'opzione per "Inviare feedback" agli sviluppatori, una funzione "Contatta il supporto" per risolvere i problemi tecnici e una sezione "Informazioni su Helium Scraper" che fornisce informazioni sulla versione e sul copyright.

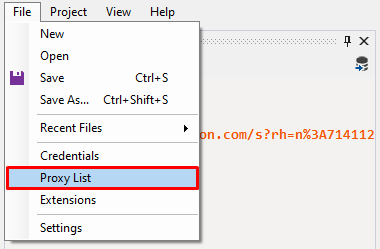

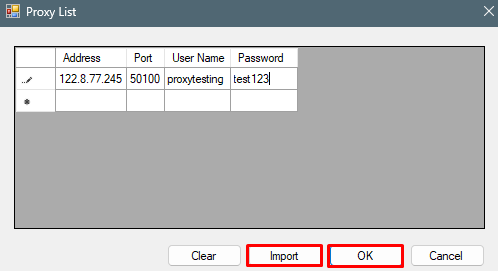

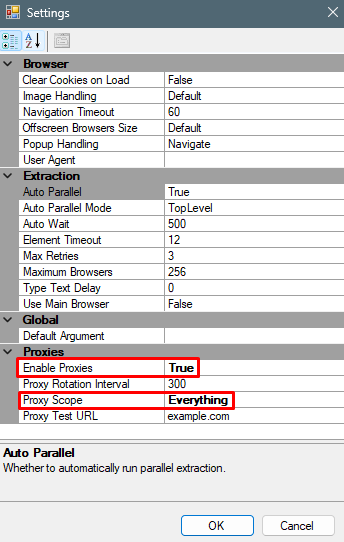

L'impostazione di un proxy in Helium Scraper è fondamentale per anonimizzare le attività e aggirare le restrizioni imposte dai siti web. L'utilizzo di un proxy aiuta a prevenire il blocco dell'IP durante le richieste frequenti alla stessa risorsa, distribuisce il carico per migliorare le prestazioni e consente di accedere a contenuti con restrizioni regionali. Per integrare un server proxy in Helium Scraper, seguite questi passaggi:

Questa configurazione assicura che il server proxy funzioni su tutti i browser in esecuzione. Per configurazioni più complesse, come la rotazione del proxy, consultare la documentazione sul sito ufficiale. In particolare, l'utilizzo di server proxy residenziali per lo scraping del web può migliorare significativamente l'efficacia delle attività di scraping, fornendo un elevato fattore di fiducia e un'ampia selezione di geolocalizzazioni, essenziale per le attività complesse.

Si può concludere che Helium Scraper è uno strumento potente per migliorare i processi di raccolta e analisi dei dati. La sua interfaccia visiva e la capacità di utilizzare query di tipo SQL consentono agli utenti di automatizzare il monitoraggio dei siti web dei concorrenti, di analizzare le variazioni di prezzo e la disponibilità dei prodotti e di monitorare le menzioni dei marchi online.

Commenti: 0