es

es  English

English  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Las herramientas de Web scraping son software especializado diseñado para extraer automáticamente datos de sitios web, organizándolos en un formato utilizable. Estas herramientas son esenciales para diversas tareas como la recopilación de datos, el archivo digital y la realización de análisis en profundidad. Con la capacidad de extraer y analizar meticulosamente los datos de las páginas, las herramientas avanzadas de web scraping garantizan la precisión y relevancia de la información que recopilan.

Su capacidad para manejar la extracción de datos a gran escala las convierte en un recurso fundamental para las empresas dedicadas al análisis de la competencia, la investigación de mercado y la generación de leads. Estas herramientas no sólo agilizan los procesos, sino que también proporcionan ventajas competitivas significativas al ofrecer conocimientos profundos rápidamente.

En este artículo, exploraremos las principales herramientas de raspado web de 2024. Cubriremos una gama de opciones que incluyen herramientas basadas en navegador, marcos de programación, bibliotecas, API y soluciones de software como servicio (SaaS).

Al seleccionar una herramienta de web scraping, hay varios factores clave a tener en cuenta:

La elección de una herramienta de raspado web depende en gran medida de la complejidad de la tarea y el volumen de datos que se procesan. Para tareas más sencillas, las extensiones del navegador suelen ser suficientes. Son fáciles de instalar y no requieren conocimientos de programación, por lo que son una buena opción para tareas sencillas de recopilación de datos. Para soluciones más complejas y personalizables, los frameworks son más adecuados, ya que ofrecen más flexibilidad y control. Si se requiere un alto nivel de automatización y gestión, los scrapers orientados a API proporcionan un servicio totalmente gestionado que puede manejar grandes volúmenes de datos de manera eficiente.

Hemos curado una lista de los 11 mejores scrapers que atienden a una variedad de necesidades. Esta selección incluye potentes programas diseñados para tareas complejas de raspado web, así como herramientas universales que son fáciles de usar y no requieren conocimientos de programación. Tanto si eres un desarrollador experimentado que necesita sólidas capacidades de extracción de datos como si eres un principiante que busca recopilar datos web fácilmente, esta lista tiene opciones que se adaptan a diferentes niveles de experiencia y demandas de proyectos.

Bright Data ofrece una robusta plataforma de raspado web de nivel empresarial que incluye un IDE de Web Scraper con plantillas de código listas para usar. Estas plantillas se gestionan y actualizan periódicamente, lo que garantiza que las operaciones de raspado sigan siendo eficaces aunque cambie el diseño del sitio web de destino.

Bright Data también utiliza la rotación de proxy y permite guardar los datos raspados en varios formatos como JSON y CSV, o directamente en soluciones de almacenamiento en la nube como Google Cloud Storage o Amazon S3.

Características:

El raspador está disponible a partir de 4,00 dólares al mes, y ofrece una versión de prueba gratuita para que los usuarios prueben sus capacidades. Está bien valorado en G2, donde tiene una puntuación de 4,6 sobre 5,0.

Octoparse es una herramienta de raspado web sin código y fácil de usar que simplifica las tareas de raspado sin requerir ninguna habilidad de codificación. Diseñado tanto para usuarios experimentados como novatos, ofrece un enfoque visual para la extracción de datos, requiriendo un mínimo o ningún conocimiento de codificación.

Una de las características más destacadas de Octoparse es su asistente de IA. Esta función ayuda a los usuarios mediante la detección automática de patrones de datos en sitios web y ofrece consejos útiles para la extracción eficaz de datos. Además, Octoparse ofrece una biblioteca de plantillas preestablecidas para sitios web populares, que se pueden utilizar para obtener datos al instante.

Características:

El raspador comienza en $ 75,00 por mes e incluye una prueba gratuita. Tiene una calificación de 4,5/5,0 en Capterra y de 4,3/5,0 en G2.

WebScraper.io es una extensión para Chrome y Firefox que está diseñada para un uso regular y programado para extraer grandes cantidades de datos de forma manual o automática.

Es gratuita para uso local, con un servicio Cloud de pago disponible para programar y gestionar trabajos de scraping a través de una API. Esta herramienta también admite el raspado de sitios web dinámicos y guarda los datos en formatos estructurados como CSV, XLSX o JSON.

WebScraper.io facilita el raspado web a través de una interfaz de apuntar y hacer clic, lo que permite a los usuarios crear mapas de sitios y seleccionar elementos sin ningún conocimiento de codificación. También es versátil para casos de uso como investigación de mercado, generación de leads y proyectos académicos.

Características:

El rascador tiene un precio de 50 dólares al mes y ofrece una prueba gratuita. Tiene una valoración de Capterra de 4,7 sobre 5.

Empezar a utilizar Scraper API es fácil para los no desarrolladores, ya que todo lo que necesitan los usuarios es una clave API y una URL para empezar a hacer scraping. Además de soportar renderizaciones JavaScript, Scraper API es totalmente personalizable, permitiendo a los usuarios personalizar los parámetros de solicitud y encabezado con el fin de satisfacer sus necesidades.

Características:

Debe dar el siguiente formato a sus solicitudes al punto final de la API:

import requests

payload = {'api_key': 'APIKEY', 'url': 'https://httpbin.org/ip'}

r = requests.get('http://api.scraperapi.com', params=payload)

print(r.text)

Este raspador está disponible a un precio introductorio de 49 dólares al mes y viene con una prueba gratuita. Tiene una calificación Capterra de 4,6 sobre 5 y una calificación G2 de 4,3 sobre 5.

Scraping Dog destaca por su sencillez y facilidad de uso, proporcionando una API que se puede integrar rápidamente en diversas aplicaciones y flujos de trabajo. Es una solución que sirve para un amplio espectro de requisitos de scraping, desde tareas sencillas de recopilación de datos hasta operaciones más complejas.

Scrapingdog también es compatible con el renderizado JS, que se puede utilizar para el raspado de sitios web que requieren múltiples llamadas a la API para cargar completamente.

Características:

He aquí un ejemplo básico de cómo utilizar el punto final API de Scraping Dog:

import requests

url = "https://api.scrapingdog.com/scrape"

params = {

"api_key": "5e5a97e5b1ca5b194f42da86",

"url": "http://httpbin.org/ip",

"dynamic": "false"

}

response = requests.get(url, params=params)

print(response.text)

El rascador está disponible a partir de 30 dólares al mes e incluye una prueba gratuita. Tiene una valoración en Trustpilot de 4,6 sobre 5.

Apify es una plataforma de software abierto que facilita el desarrollo y la ejecución de herramientas de extracción de datos, automatización web e integración web a escala. Es una plataforma versátil basada en la nube que proporciona un conjunto completo de herramientas de raspado web y automatización. Está diseñada para desarrolladores que necesitan construir, ejecutar y escalar tareas de web scraping y extracción de datos sin gestionar servidores.

Apify también viene con una biblioteca de raspado web de código abierto llamada Crawlee y es compatible tanto con Python como con JavaScript. Con Apify, puedes integrar tu contenido fácilmente con aplicaciones de terceros como Google Drive, GitHub y Slack, así como crear tus propias integraciones con webhooks y APIs.

Características:

El rascador comienza en $ 49 por mes e incluye una versión gratuita. Tiene una valoración de 4,8 sobre 5 tanto en Capterra como en G2.

ScrapingBee es una API de raspado web versátil que está diseñada para manejar una amplia gama de tareas de raspado web de manera eficiente. Destaca en áreas como el scraping inmobiliario, el seguimiento de precios y la extracción de reseñas, lo que permite a los usuarios recopilar datos sin problemas y sin temor a ser bloqueados.

La flexibilidad y eficacia de ScrapingBee lo convierten en un recurso inestimable para desarrolladores, profesionales del marketing e investigadores que pretenden automatizar y agilizar el proceso de recopilación de datos de diversas fuentes online.

Características:

Este scraper está disponible a partir de 49 dólares al mes e incluye una versión gratuita. Presume de una calificación perfecta de 5,0 sobre 5 en Capterra.

Diffbot destaca por sus capacidades avanzadas de IA y aprendizaje automático, lo que lo hace muy eficaz para la extracción de contenido de páginas web. Es una solución totalmente automatizada que es genial para extraer datos estructurados.

Diffbot es ideal para equipos de marketing y empresas centradas en la generación de leads, estudios de mercado y análisis de sentimiento. Su capacidad para procesar y estructurar datos sobre la marcha lo convierte en una poderosa herramienta para aquellos que necesitan una extracción de datos rápida y precisa sin necesidad de una extensa configuración técnica.

Características:

El rascador tiene un precio de 299 dólares al mes e incluye una prueba gratuita. Tiene una valoración de Capterra de 4,5 sobre 5.

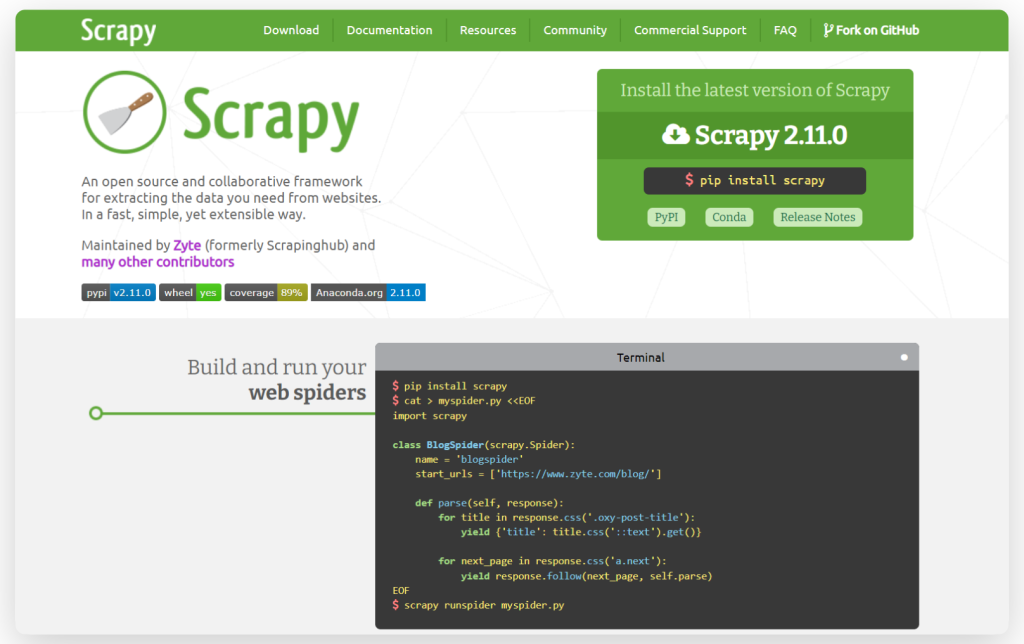

Scrapy es un robusto framework de rastreo y scraping web de código abierto conocido por su velocidad y eficiencia. Escrito en Python, Scrapy es compatible con múltiples sistemas operativos, incluyendo Linux, Windows, Mac y BSD. El framework permite la creación de agentes de búsqueda personalizados y ofrece flexibilidad para personalizar sus componentes sin necesidad de alterar el núcleo del sistema. Esto convierte a Scrapy en una herramienta versátil para los desarrolladores que buscan adaptar sus herramientas de scraping a requisitos específicos.

Características:

He aquí un sencillo ejemplo de cómo usar Scrapy para scrapear datos de una web:

import scrapy

class BlogSpider(scrapy.Spider):

name = 'blogspider'

start_urls = ['https://www.zyte.com/es/blog/']

def parse(self, response):

for title in response.css('.oxy-post-title'):

yield {'title': title.css('::text').get()}

for next_page in response.css('a.next'):

yield response.follow(next_page, self.parse)

Beautiful Soup es una librería Python que facilita el scrapeo de información de páginas web. Es una gran herramienta para principiantes y se utiliza a menudo para proyectos rápidos de scraping, o cuando se necesita hacer scraping de un sitio web con estructura HTML simple.

Características:

He aquí un ejemplo básico de cómo usar Beautiful Soup:

from bs4 import BeautifulSoup

html_doc ="""<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

soup = BeautifulSoup(html_doc, 'html.parser')

print(soup.title.string) # Outputs "The Dormouse's story"

Cheerio es una librería rápida, flexible y fácil de usar en Node.js que imita la funcionalidad principal de jQuery. Utiliza el parseador parse5 por defecto, Cheerio también ofrece la opción de utilizar el htmlparser2, más tolerante a errores. Esta biblioteca es capaz de analizar casi cualquier documento HTML o XML, por lo que es una excelente opción para los desarrolladores que necesitan capacidades de raspado web eficientes y versátiles.

Características:

He aquí un sencillo ejemplo de Cheerio:

const cheerio = require('cheerio');

// some product webpage

const html = `

<html>

<head>

<title>Sample Page</title>

</head>

<body>

<h1>Welcome to a Product Page</h1>

<div class="products">

<div class="item">Product 1</div>

<div class="item">Product 2</div>

<div class="item">Product 3</div>

</div>

</body>

</html>

`;

const $ = cheerio.load(html);

$('.item').each(function () {

const product = $(this).text();

console.log(product);

});

En resumen, cada scraper aporta características únicas adecuadas para diferentes necesidades de scraping. Cheerio y Beautiful Soup son bibliotecas de análisis de HTML optimizadas para Node.js y Python, respectivamente. Scrapy, otra herramienta basada en Python, sobresale en el manejo de scripts complejos y la gestión de grandes conjuntos de datos como parte de un marco integral de raspado y análisis web.

Para aquellos que evalúan plataformas o servicios para el raspado web, aquí hay recomendaciones adaptadas basadas en criterios de selección comunes:

Comentarios: 0