ua

ua  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy - швидкий високорівневий фреймворк для парсингу даних, моніторингу цін, аналізу поведінки користувачів, збору думок у соціальних мережах, SEO-аналізу та інших сфер, де потрібно досліджувати й обробляти великі обсяги інформації з інтернету. Він також пропонує вбудовані механізми для управління HTTP-запитами, опрацювання помилок і дотримання правил robots.txt, що робить його ефективним рішенням для складних і масштабних проєктів зі збору та аналізу веб-даних. У цьому огляді буде розглянуто, що собою являє Scrapy, як він працює і які можливості надає користувачам.

Фреймворк Scrapy являє собою відкрите програмне забезпечення для запуску веб-скреперів на Python. Він призначений для автоматичного сканування сайтів (краулінгу) і вилучення різноманітних структурованих веб-даних, які потім можна організувати у файли форматів JSON і CSV або в бази даних, як-от SQLite, MySQL, PostgreSQL і MongoDB. Scrapy може застосовувати різні методи парсингу, включно з CSS-селекторами і XPath, а також дає змогу працювати безпосередньо з JSON і XML-відповідями, що важливо під час взаємодії з API.

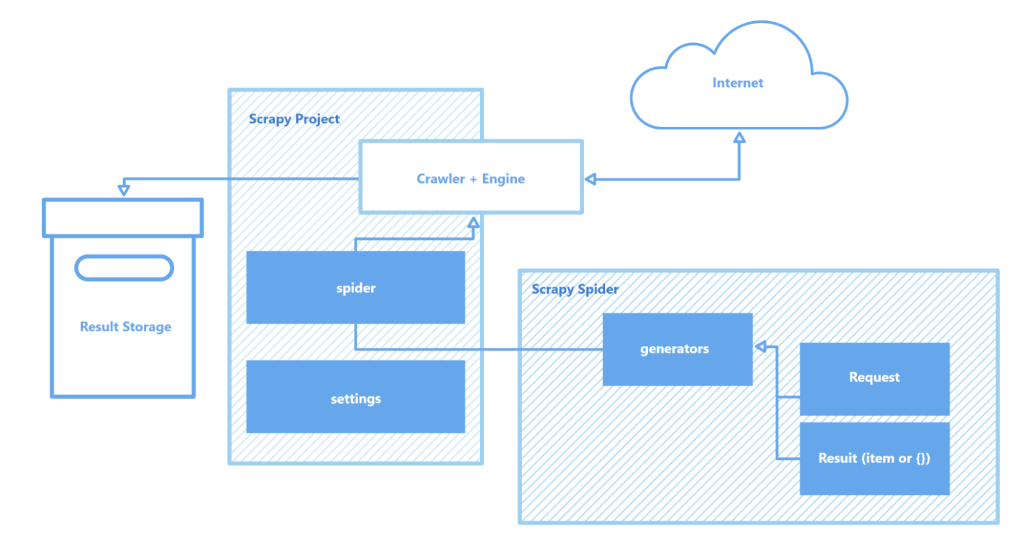

Робота Scrapy заснована на використанні "павуків" - краулерів, які автономно виконують задані інструкції зі сканування веб-сторінок і збору даних. Кожен краулер - це невелика програма (скрипт) для пошуку об'єктів певного типу, як-от текст, зображення або посилання, і їхнього подальшого збереження. Крім того, Scrapy пропонує інтерактивну оболонку для краулінгу, яка дає змогу тестувати гіпотези та перевіряти поведінку "павука" в реальному часі. Це значно прискорює процес налаштування та оптимізації парсера.

Інші важливі компоненти архітектури фреймворка Scrapy:

Фреймворк Scrapy є одним із найбільш затребуваних інструментів для веб-скрейпінгу, пропонуючи розробникам потужні та гнучкі можливості для ефективного збирання даних із різноманітних джерел.

У цьому розділі розглядаються ключові особливості фреймворка Scrapy, включно зі швидкістю збору та обробки даних, можливостями для функціонального розширення і портативністю. Вони вирізняють Scrapy з-поміж конкурентів і роблять його одним із найпопулярніших інструментів у сфері веб-скрейпінгу.

Scrapy побудований на основі асинхронного мережевого open source-движка Twisted. У синхронному підході виконання одного завдання блокує виконання наступного до його завершення, тоді як в асинхронному режимі Twisted можливе паралельне виконання завдань. Це означає, що "павуки" Scrapy можуть одночасно надсилати безліч запитів і обробляти відповіді, не чекаючи відповіді та завершення попередніх операцій. Такий підхід прискорює процес збору даних і дає змогу більш ефективно використовувати обчислювальні ресурси, що важливо під час роботи над великими проєктами та сканування безлічі сайтів одночасно.

Швидкість роботи Scrapy також забезпечується низкою інших факторів:

Поєднання цих можливостей робить Scrapy одним з найшвидших інструментів для сканування і збору даних з безлічі веб-сайтів. Це особливо важливо в таких галузях, як аналіз цін на товари, парсинг вакансій, моніторинг новин і соціальних мереж, а також під час збору даних для різних досліджень.

Scrapy має модульну архітектуру, що дає змогу легко розширювати й адаптувати її під конкретні завдання. Фреймворк підтримує інтеграцію з різними сховищами даних, як-от MongoDB, PostgreSQL і Elasticsearch, а також із системами управління чергами, зокрема Redis і RabbitMQ. Крім того, бібліотеку можна інтегрувати з платформами для моніторингу або логування, такими як Prometheus або Logstash. Це дає змогу налаштовувати і масштабувати скрапери для роботи з великими обсягами веб-даних і складними проєктами, чи то збір інформації для машинного навчання, чи то розробка пошукових систем.

Функціонал яких елементів архітектури Scrapy можна розширити:

Крім цього, Scrapy підтримує створення користувацьких модулів для роботи з API, що забезпечує гнучке налаштування і масштабування рішень для обробки великих обсягів даних і виконання складних проєктів.

Ще однією з переваг Scrapy є його портативність. Фреймворк підтримує роботу на Windows, macOS і Linux, що робить його зручним для використання в різноманітних середовищах розробки. Scrapy легко встановлюється через менеджер пакетів Python (pip), а завдяки модульній структурі та гнучкості його конфігурації проекти можуть переноситися між різними машинами без значних змін.

Крім того, фреймворк підтримує віртуальні оточення (virtual environments), що дає змогу ізолювати залежності проєкту й уникнути конфліктів з іншими встановленими пакетами. Це особливо важливо під час роботи над кількома проектами одночасно або під час розгортання додатків на сервері.

Для зручнішої роботи в Scrapy рекомендується використовувати редактор коду, такий як Visual Studio Code (VS Code) або його аналоги, оскільки взаємодія з фреймворком здійснюється за допомогою командного рядка (CLI). З його допомогою можна запускати проєкти, сканувати сайти, налаштовувати "павуків" та інше. Крім цього, слід використовувати віртуальні середовища для управління залежностями. Це дасть змогу уникнути конфліктів між бібліотеками та версіями пакетів.

Створення та запуск проєкту в Scrapy включає кілька кроків.

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Налаштування проекту

myproject/

__init__.py

items.py # Визначення моделей даних

middlewares.py # Проміжні шари (middlewares)

pipelines.py # Обробка даних

settings.py # Налаштування Scrapy

spiders/ # Папка для павуків

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Тут "quotes" - це ім'я павука, вказане в класі QuotesSpider. Scrapy почне сканувати вказаний URL і витягувати дані згідно з налаштуваннями павука.

scrapy crawl quotes -o quotes.json

Scrapy - безкоштовний фреймворк для веб-скрапінгу, який пропонує розробникам широкі можливості для автоматизованого вилучення та обробки даних з інтернет-сторінок. Його асинхронна архітектура і модульна структура забезпечують високу швидкість роботи, відмінну масштабованість і можливість розширення функціоналу. Водночас інтеграція з різними бібліотеками і сховищами даних, а також підтримка кастомних протоколів дають змогу легко знайти й адаптувати краулер до специфічних вимог проєктів, що робить процес веб-скрапінгу простішим і зручнішим.

Коментарі: 0