id

id  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Polski

Polski Scrapy adalah kerangka kerja tingkat tinggi yang kuat yang dirancang untuk penguraian web dan ekstraksi data, sehingga ideal untuk tugas-tugas seperti penguraian data, pemantauan harga, analisis perilaku pengguna, wawasan media sosial, dan analisis SEO. Framework ini dilengkapi untuk menangani data dalam jumlah besar secara efisien. Framework ini memiliki mekanisme bawaan untuk mengelola permintaan HTTP, penanganan kesalahan, dan memastikan kepatuhan terhadap robots.txt, yang sangat penting untuk menavigasi proyek pengumpulan data web berskala besar dan kompleks. Ulasan ini akan mempelajari apa itu Scrapy, bagaimana fungsinya, dan fitur-fitur yang ditawarkannya kepada pengguna, memberikan pemahaman yang komprehensif tentang kemampuan dan aplikasinya.

Kerangka kerja Scrapy adalah alat scraping web sumber terbuka yang kuat yang ditulis dalam bahasa Python, yang dirancang untuk merayapi dan mengekstraksi data terstruktur dengan efisiensi tinggi dari situs web. Scrapy dapat mengatur data yang diekstrak ke dalam format JSON dan CSV atau langsung menyimpannya di dalam basis data seperti SQLite, MySQL, PostgreSQL, dan MongoDB. Scrapy mendukung berbagai metode penguraian termasuk pemilih CSS dan XPath dan dapat menangani respons JSON dan XML, yang sangat penting saat berurusan dengan API.

Scrapy beroperasi melalui "spiders" - perayap khusus yang mengikuti instruksi yang ditentukan untuk menavigasi halaman web dan mengambil data. Spider ini pada dasarnya adalah skrip yang mengidentifikasi dan menangkap jenis objek tertentu seperti teks, gambar, atau tautan. Cangkang perayap interaktif yang disediakan oleh Scrapy memungkinkan pengujian dan debugging secara real-time terhadap spider-spider ini, yang sangat meningkatkan proses pengaturan dan pengoptimalan perayap.

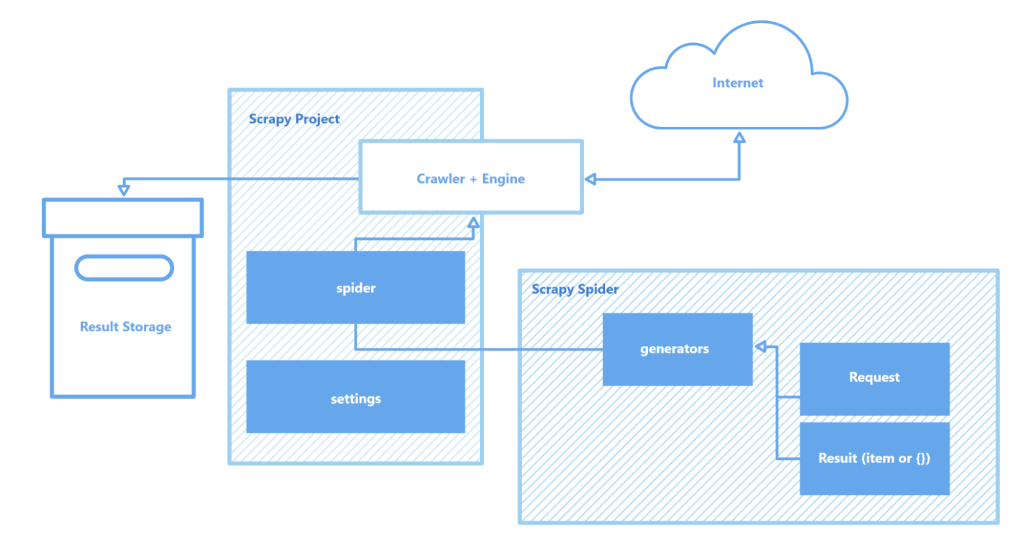

Komponen utama dari arsitektur Scrapy meliputi:

Secara keseluruhan, Scrapy menonjol sebagai salah satu alat pengikisan web yang paling kuat dan fleksibel yang tersedia, cocok untuk segala hal, mulai dari tugas ekstraksi data sederhana hingga proyek penambangan web berskala besar yang kompleks.

Bagian ini menyoroti fitur-fitur utama dari kerangka kerja Scrapy: kecepatannya dalam pengumpulan dan pemrosesan data, kemampuan untuk memperluas fungsionalitas, dan portabilitas. Atribut-atribut ini membedakan Scrapy dari para pesaingnya dan menjadikannya sebagai pilihan populer di arena web scraping.

Scrapy didukung oleh Twisted, sebuah mesin jaringan sumber terbuka asinkron. Tidak seperti operasi sinkron di mana satu tugas harus diselesaikan sebelum tugas lainnya dimulai, Twisted memungkinkan tugas dijalankan secara paralel. Ini berarti Scrapy spider dapat mengirim beberapa permintaan dan memproses respons secara bersamaan, meningkatkan kecepatan dan efisiensi dalam pengumpulan data, terutama untuk proyek berskala besar atau ketika memindai beberapa situs secara bersamaan.

Kecepatan Scrapy semakin didorong oleh beberapa faktor:

Bersama-sama, fitur-fitur ini menjadikan Scrapy sebagai salah satu alat tercepat yang tersedia untuk mengikis dan mengumpulkan data secara efisien dari banyak situs web, menjadikannya sumber daya yang tak ternilai untuk tugas-tugas seperti pemantauan harga produk, daftar lowongan kerja, pengumpulan berita, analisis media sosial, dan penelitian akademis.

Arsitektur modular Scrapy meningkatkan kemampuan beradaptasi dan perluasannya, sehingga cocok untuk berbagai tugas pengumpulan data yang kompleks. Dukungannya untuk integrasi dengan berbagai penyimpanan data seperti MongoDB, PostgreSQL, dan Elasticsearch, serta sistem manajemen antrean seperti Redis dan RabbitMQ, memungkinkan penanganan volume data yang besar secara efektif. Selain itu, Scrapy dapat berintegrasi dengan platform pemantauan atau pencatatan seperti Prometheus atau Logstash, memungkinkan konfigurasi scraper yang dapat diskalakan dan disesuaikan untuk berbagai proyek mulai dari pengumpulan data pembelajaran mesin hingga pengembangan mesin pencari.

Komponen yang dapat diperluas dari arsitektur Scrapy:

Selain itu, kemampuan Scrapy untuk mendukung modul khusus untuk interaksi API menyediakan kerangka kerja yang kuat untuk menskalakan dan menyesuaikan solusi untuk memenuhi tuntutan pemrosesan data skala besar dan persyaratan proyek yang kompleks.

Keuntungan signifikan lainnya dari Scrapy adalah portabilitasnya. Framework ini mendukung berbagai sistem operasi termasuk Windows, macOS, dan Linux, membuatnya serbaguna untuk digunakan di berbagai lingkungan pengembangan. Pemasangannya sangat mudah menggunakan manajer paket Python (pip), dan berkat struktur modular Scrapy dan konfigurasi yang fleksibel, proyek dapat dengan mudah ditransfer antar mesin tanpa perubahan yang signifikan.

Selain itu, Scrapy mendukung lingkungan virtual, yang mengisolasi ketergantungan proyek dan menghindari konflik dengan paket yang terinstal. Fitur ini sangat berharga ketika mengerjakan beberapa proyek secara bersamaan atau ketika men-deploy aplikasi ke server, memastikan lingkungan pengembangan yang bersih dan stabil.

Untuk pekerjaan yang lebih efektif dengan Scrapy, disarankan untuk menggunakan editor kode seperti Visual Studio Code (VS Code) atau yang serupa, karena interaksi dengan kerangka kerja dilakukan melalui baris perintah (CLI). Hal ini memungkinkan untuk mengelola proyek, memindai situs, dan mengonfigurasi spider dengan lebih efisien. Selain itu, menggunakan lingkungan virtual untuk mengelola ketergantungan dapat membantu menghindari konflik antara pustaka dan versi paket, memastikan alur kerja yang lebih lancar.

Membuat dan menjalankan proyek di Scrapy melibatkan serangkaian langkah mudah:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Pengaturan proyek

myproject/

__init__.py

items.py # Definisi model data

middlewares.py # Middleware

pipelines.py # Pemrosesan data

settings.py # Pengaturan bekas

spiders/ # Folder spider

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Di sini, "quotes" adalah nama spider yang didefinisikan dalam kelas QuotesSpider. Scrapy akan mengeksekusi spider untuk merayapi URL yang ditentukan dan mengekstrak data sesuai dengan pengaturan yang Anda tentukan.

scrapy crawl quotes -o quotes.json

Scrapy adalah kerangka kerja scraping web gratis yang kuat yang dirancang untuk memberikan alat yang komprehensif kepada para pengembang untuk ekstraksi dan pemrosesan data otomatis dari halaman web. Arsitektur asinkron dan struktur modularnya memastikan kecepatan tinggi dan skalabilitas yang sangat baik, memfasilitasi perluasan fungsionalitas sesuai kebutuhan. Selain itu, integrasi Scrapy yang mulus dengan berbagai pustaka dan solusi penyimpanan data, bersama dengan dukungan untuk protokol khusus, menyederhanakan penyesuaian crawler untuk memenuhi persyaratan proyek tertentu. Hal ini membuat proses scraping web tidak hanya lebih efisien tetapi juga lebih mudah beradaptasi dan ramah pengguna.

Komentar: 0