id

id  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Polski

Polski Alat pengikis web adalah perangkat lunak khusus yang dirancang untuk secara otomatis menarik data dari situs web, mengaturnya menjadi format yang dapat digunakan. Alat-alat ini sangat penting untuk berbagai tugas seperti pengumpulan data, pengarsipan digital, dan melakukan analitik yang mendalam. Dengan kemampuan untuk dengan cermat mengekstrak dan menganalisis data halaman, alat pengikis web canggih memastikan ketepatan dan relevansi informasi yang mereka kumpulkan.

Kemampuan mereka untuk menangani ekstraksi data skala besar membuat mereka menjadi sumber penting bagi bisnis yang terlibat dalam analisis pesaing, riset pasar, dan generasi pemimpin. Alat -alat ini tidak hanya merampingkan proses tetapi juga memberikan keunggulan kompetitif yang signifikan dengan menawarkan wawasan mendalam dengan cepat.

Dalam artikel ini, kami akan menjelajahi alat pengikis web teratas tahun 2024. Kami akan membahas berbagai opsi termasuk alat berbasis browser, kerangka kerja pemrograman, perpustakaan, API, dan solusi perangkat lunak-sebagai-layanan (SaaS).

Saat memilih alat pengikis web, ada beberapa faktor kunci yang perlu dipertimbangkan:

Pilihan alat pengikis web sangat tergantung pada kompleksitas tugas dan volume data yang sedang diproses. Untuk tugas yang lebih sederhana, ekstensi browser seringkali cukup. Mereka mudah dipasang dan tidak memerlukan pengetahuan pemrograman, menjadikannya pilihan yang baik untuk tugas pengumpulan data langsung. Untuk solusi yang lebih kompleks dan dapat disesuaikan, kerangka kerja lebih cocok karena mereka menawarkan lebih banyak fleksibilitas dan kontrol. Jika tingkat otomatisasi dan manajemen yang tinggi diperlukan, pencakar yang berorientasi pada API menyediakan layanan yang dikelola sepenuhnya yang dapat menangani volume besar data secara efisien.

Kami telah mengkuratori daftar 11 pencakar terbaik yang memenuhi berbagai kebutuhan. Pilihan ini mencakup program kuat yang dirancang untuk tugas pengikis web yang kompleks, serta alat universal yang ramah pengguna dan tidak memerlukan pengetahuan pemrograman. Apakah Anda seorang pengembang berpengalaman yang membutuhkan kemampuan ekstraksi data yang kuat atau pemula yang ingin mengumpulkan data web dengan mudah, daftar ini memiliki opsi yang sesuai dengan berbagai tingkat keahlian dan permintaan proyek.

Bright Data menawarkan platform pengikis web kelas perusahaan yang kuat yang mencakup Web Scraper IDE dengan templat kode siap pakai. Template ini dikelola dan diperbarui secara teratur, memastikan bahwa operasi pengikisan tetap efektif bahkan jika tata letak situs web target berubah.

Data Bright juga menggunakan rotasi proxy dan memungkinkan Anda menyimpan data yang dikikis dalam berbagai format seperti JSON dan CSV, atau langsung ke solusi penyimpanan cloud seperti Google Cloud Storage atau Amazon S3.

Fitur:

Scraper tersedia mulai dari $ 4,00 per bulan, dan menawarkan versi uji coba gratis bagi pengguna untuk menguji kemampuannya. Ini dianggap baik pada G2, di mana ia memiliki peringkat 4,6 dari 5,0.

Octoparse adalah alat pengikis web tanpa kode, yang mudah digunakan yang menyederhanakan tugas pengikis tanpa memerlukan keterampilan pengkodean apa pun. Dirancang untuk pengguna berpengalaman dan pemula, ia menawarkan pendekatan visual untuk ekstraksi data, membutuhkan keterampilan pengkodean minimal hingga tidak ada.

Salah satu fitur yang menonjol dari gurita adalah asisten AI -nya. Fitur ini membantu pengguna dengan pola data pendeteksian otomatis di situs web dan menawarkan tips praktis untuk ekstraksi data yang efektif. Selain itu, Octoparse menawarkan perpustakaan templat preset untuk situs web populer, yang dapat digunakan untuk mendapatkan data secara instan.

Fitur:

Scraper mulai dari $ 75,00 per bulan dan termasuk uji coba gratis. Ini dinilai 4.5/5.0 pada Capterra dan 4.3/5.0 pada G2.

Webscraper.io adalah ekstensi Chrome dan Firefox yang dirancang untuk penggunaan reguler dan dijadwalkan untuk mengekstraksi sejumlah besar data baik secara manual maupun otomatis.

Ini gratis untuk penggunaan lokal, dengan layanan cloud berbayar tersedia untuk menjadwalkan dan mengelola pekerjaan mengikis melalui API. Alat ini juga mendukung pengikis situs web dinamis dan menyimpan data dalam format terstruktur seperti CSV, XLSX, atau JSON.

Webscraper.io memfasilitasi pengikisan web melalui antarmuka point-and-klik, memungkinkan pengguna untuk membuat peta situs dan memilih elemen tanpa keahlian pengkodean. Ini juga serbaguna untuk penggunaan kasus seperti riset pasar, generasi pemimpin, dan proyek akademik.

Fitur:

Scraper ini dihargai $ 50 per bulan dan menawarkan uji coba gratis. Ini memiliki peringkat Capterra 4,7 dari 5.

Memulai dengan Scraper API mudah bagi non-pengembang, karena yang dibutuhkan semua pengguna adalah kunci API dan URL untuk mulai mengikis. Selain mendukung rendering JavaScript, Scraper API sepenuhnya dapat disesuaikan, memungkinkan pengguna untuk menyesuaikan parameter permintaan dan header untuk memenuhi kebutuhan mereka.

Fitur:

Anda harus memformat permintaan Anda ke titik akhir API sebagai berikut:

import requests

payload = {'api_key': 'APIKEY', 'url': 'https://httpbin.org/ip'}

r = requests.get('http://api.scraperapi.com', params=payload)

print(r.text)

Scraper ini tersedia dengan harga pengantar $ 49 per bulan dan dilengkapi dengan uji coba gratis. Ini memiliki peringkat Capterra 4,6 dari 5 dan peringkat G2 4,3 dari 5.

Scrapingdog menonjol karena kesederhanaan dan kemudahan penggunaannya, menyediakan API yang dapat dengan cepat diintegrasikan ke dalam berbagai aplikasi dan alur kerja. Ini adalah solusi yang melayani spektrum luas persyaratan pengikis, dari tugas pengumpulan data sederhana hingga operasi yang lebih kompleks.

ScrapingDog juga mendukung rendering JS, yang dapat digunakan untuk mengikis situs web yang memerlukan beberapa panggilan API untuk memuat sepenuhnya.

Fitur:

Berikut adalah contoh dasar tentang cara menggunakan titik akhir API anjing pengikis:

import requests

url = "https://api.scrapingdog.com/scrape"

params = {

"api_key": "5e5a97e5b1ca5b194f42da86",

"url": "http://httpbin.org/ip",

"dynamic": "false"

}

response = requests.get(url, params=params)

print(response.text)

Scraper tersedia mulai dari $ 30 per bulan dan termasuk uji coba gratis. Ini memiliki peringkat trustpilot 4,6 dari 5.

Apify adalah platform perangkat lunak terbuka yang memudahkan untuk mengembangkan dan menjalankan ekstraksi data, otomatisasi web, dan alat integrasi web pada skala. Ini adalah platform berbasis cloud serbaguna yang menyediakan rangkaian komprehensif alat pengikis dan otomatisasi web. Ini dirancang untuk pengembang yang perlu membangun, menjalankan, dan skala tugas pengikis web dan ekstraksi data tanpa mengelola server.

Apify juga dilengkapi dengan perpustakaan pengikis web open-source yang disebut Crawlee dan kompatibel dengan Python dan JavaScript. Dengan Apify, Anda dapat mengintegrasikan konten Anda dengan mudah dengan aplikasi pihak ketiga seperti Google Drive, GitHub, dan Slack, serta membuat integrasi Anda sendiri dengan webhook dan API.

Fitur:

Scraper mulai dari $ 49 per bulan dan termasuk versi gratis. Ini memiliki peringkat 4,8 dari 5 pada Capterra dan G2.

ScrapingBee adalah API Mengikis Web serbaguna yang dibuat untuk menangani berbagai tugas pengikisan web secara efisien. Ini unggul di bidang -bidang seperti pengikisan real estat, pemantauan harga, dan meninjau ekstraksi, memungkinkan pengguna untuk mengumpulkan data dengan mulus tanpa takut diblokir.

Fleksibilitas dan keefektifan ScrapingBee menjadikannya sumber yang sangat berharga bagi pengembang, pemasar, dan peneliti yang bertujuan untuk mengotomatisasi dan merampingkan proses pengumpulan data dari berbagai sumber online.

Fitur:

Scraper ini tersedia mulai dari $ 49 per bulan dan termasuk versi gratis. Ini menawarkan peringkat sempurna 5,0 dari 5 di Capterra.

DiffBot menonjol dengan kemampuan pembelajaran AI dan mesin canggih, membuatnya sangat efektif untuk ekstraksi konten dari halaman web. Ini adalah solusi sepenuhnya otomatis yang sangat bagus dalam mengekstraksi data terstruktur.

Diffbot sangat ideal untuk tim pemasaran dan bisnis yang berfokus pada generasi pemimpin, riset pasar, dan analisis sentimen. Kemampuannya untuk memproses dan menyusun data dengan cepat menjadikannya alat yang ampuh bagi mereka yang membutuhkan ekstraksi data yang cepat dan akurat tanpa perlu pengaturan teknis yang luas.

Fitur:

Scraper ini dihargai $ 299 per bulan dan termasuk uji coba gratis. Ini memiliki peringkat Capterra 4,5 dari 5.

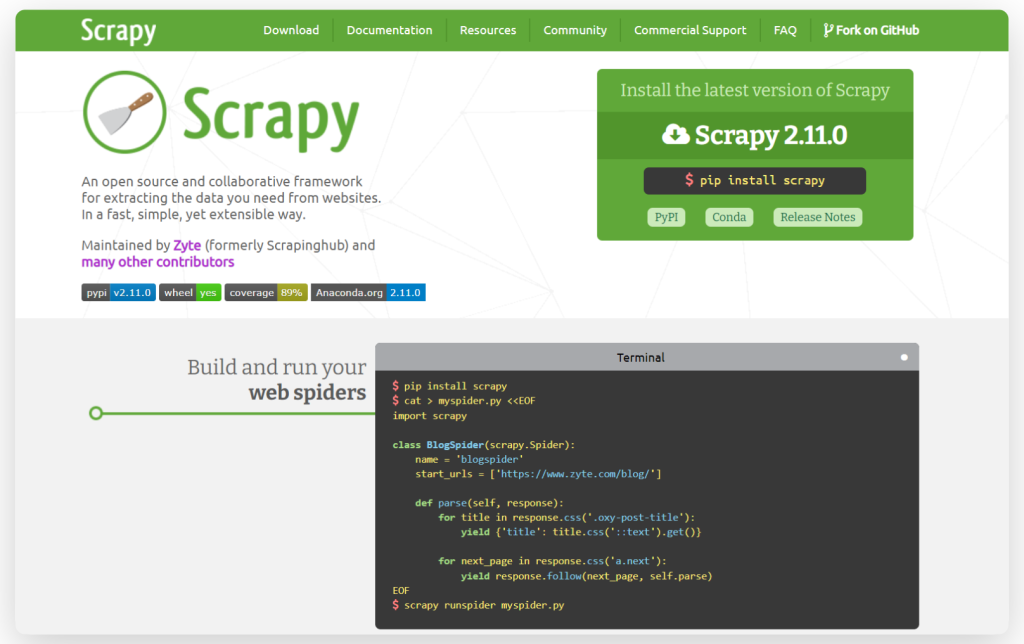

Scrapy adalah kerangka kerja web yang kuat dan sumber terbuka dan goresan yang dikenal karena kecepatan dan efisiensinya. Ditulis dalam Python, gesekan kompatibel dengan beberapa sistem operasi termasuk Linux, Windows, Mac, dan BSD. Kerangka kerja ini memungkinkan pembuatan agen pencarian khusus dan menawarkan fleksibilitas dalam menyesuaikan komponennya tanpa perlu mengubah sistem inti. Ini menjadikan Scrapy alat yang serba guna bagi pengembang yang ingin menyesuaikan alat pengikis mereka dengan persyaratan tertentu.

Fitur:

Berikut adalah contoh sederhana tentang cara menggunakan gesekan untuk mengikis data dari situs web:

import scrapy

class BlogSpider(scrapy.Spider):

name = 'blogspider'

start_urls = ['https://www.zyte.com/id/blog/']

def parse(self, response):

for title in response.css('.oxy-post-title'):

yield {'title': title.css('::text').get()}

for next_page in response.css('a.next'):

yield response.follow(next_page, self.parse)

Beautiful Soup adalah perpustakaan Python yang membuatnya mudah untuk mengikis informasi dari halaman web. Ini adalah alat yang hebat untuk pemula dan sering digunakan untuk proyek pengikisan cepat, atau ketika Anda perlu mengikis situs web dengan struktur HTML sederhana.

Fitur:

Berikut adalah contoh dasar tentang cara menggunakan sup yang indah:

from bs4 import BeautifulSoup

html_doc ="""<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

soup = BeautifulSoup(html_doc, 'html.parser')

print(soup.title.string) # Outputs "The Dormouse's story"

Cheerio adalah perpustakaan yang cepat, fleksibel, dan ramah pengguna di Node.js yang meniru fungsi inti jQuery. Memanfaatkan parser parse5 secara default, Cheerio juga menawarkan opsi untuk menggunakan HTMLParser2 yang lebih toleran terhadap kesalahan. Perpustakaan ini mampu mem -parsing hampir semua dokumen HTML atau XML, menjadikannya pilihan yang sangat baik untuk pengembang yang membutuhkan kemampuan pengikis web yang efisien dan serbaguna.

Fitur:

Inilah contoh Cheerio sederhana:

const cheerio = require('cheerio');

// some product webpage

const html = `

<html>

<head>

<title>Sample Page</title>

</head>

<body>

<h1>Welcome to a Product Page</h1>

<div class="products">

<div class="item">Product 1</div>

<div class="item">Product 2</div>

<div class="item">Product 3</div>

</div>

</body>

</html>

`;

const $ = cheerio.load(html);

$('.item').each(function () {

const product = $(this).text();

console.log(product);

});

Singkatnya, setiap scraper membawa fitur unik yang cocok untuk kebutuhan gesekan yang berbeda. Cheerio dan Sup yang indah adalah perpustakaan parsing HTML yang dioptimalkan untuk Node.js dan Python, masing -masing. Scrapy, alat berbasis Python lainnya, unggul dalam menangani skrip kompleks dan mengelola kumpulan data besar sebagai bagian dari kerangka kerja pengikis dan penguraian web yang komprehensif.

Bagi mereka yang mengevaluasi platform atau layanan untuk pengikisan web, berikut adalah rekomendasi yang disesuaikan berdasarkan kriteria seleksi umum:

Komentar: 0