hi

hi  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy एक मजबूत, उच्च-स्तरीय ढांचा है जिसे वेब स्क्रैपिंग और डेटा निष्कर्षण के लिए डिज़ाइन किया गया है, जो इसे डेटा पार्सिंग, मूल्य निगरानी, उपयोगकर्ता व्यवहार विश्लेषण, सोशल मीडिया इनसाइट्स और एसईओ विश्लेषण जैसे कार्यों के लिए आदर्श बनाता है। यह ढांचा कुशलता से डेटा के बड़े संस्करणों को संभालने के लिए सुसज्जित है। इसमें HTTP अनुरोधों के प्रबंधन, त्रुटि से निपटने और रोबोट्स के अनुपालन को सुनिश्चित करने के लिए अंतर्निहित तंत्र शामिल हैं, जो जटिल और बड़े पैमाने पर वेब डेटा संग्रह परियोजनाओं को नेविगेट करने के लिए आवश्यक हैं। यह समीक्षा यह बताएगी कि Scrapy क्या है, यह कैसे कार्य करता है, और उपयोगकर्ताओं को यह प्रदान करता है, इसकी क्षमताओं और अनुप्रयोगों की व्यापक समझ प्रदान करता है।

Scrapy फ्रेमवर्क एक शक्तिशाली ओपन-सोर्स वेब स्क्रैपिंग टूल है जो पायथन में लिखा गया है, जिसे उच्च दक्षता वाले क्रॉलिंग और वेबसाइटों से संरचित डेटा निकालने के लिए डिज़ाइन किया गया है। यह JSON और CSV प्रारूपों में निकाले गए डेटा को व्यवस्थित कर सकता है या इसे सीधे SQLite, MySQL, PostgreSQL और MongoDB जैसे डेटाबेस में स्टोर कर सकता है। Scrapy CSS चयनकर्ताओं और XPath सहित विभिन्न पार्सिंग विधियों का समर्थन करता है और JSON और XML प्रतिक्रियाओं को संभाल सकता है, जो API के साथ काम करते समय महत्वपूर्ण है।

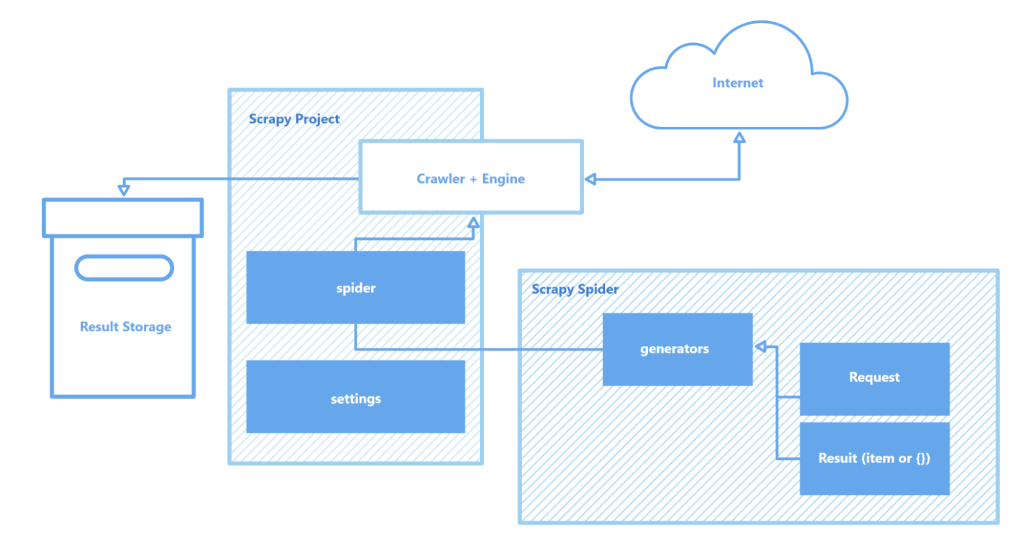

Scrapy "spiders" के माध्यम से संचालित होता है - विशेष क्रॉलर जो वेब पेज और फसल डेटा को नेविगेट करने के लिए परिभाषित निर्देशों का पालन करते हैं। ये मकड़ियों अनिवार्य रूप से स्क्रिप्ट हैं जो पाठ, चित्र या लिंक जैसी विशिष्ट प्रकार की वस्तुओं की पहचान और कैप्चर करते हैं। Scrapy द्वारा प्रदान किया गया एक इंटरैक्टिव रेंगने वाला शेल इन मकड़ियों के वास्तविक समय परीक्षण और डिबगिंग के लिए अनुमति देता है, जो क्रॉलर के सेटअप और अनुकूलन प्रक्रिया को बहुत बढ़ाता है।

Scrapy आर्किटेक्चर के प्रमुख घटकों में शामिल हैं:

कुल मिलाकर, Scrapy उपलब्ध सबसे मजबूत और लचीले वेब स्क्रैपिंग टूल में से एक के रूप में खड़ा है, जो सरल डेटा निष्कर्षण कार्यों से लेकर जटिल बड़े पैमाने पर वेब खनन परियोजनाओं तक सब कुछ के लिए उपयुक्त है।

यह खंड Scrapy फ्रेमवर्क की प्रमुख विशेषताओं को उजागर करता है: डेटा संग्रह और प्रसंस्करण में इसकी गति, कार्यक्षमता का विस्तार करने की क्षमता और पोर्टेबिलिटी। ये विशेषताएँ अपने प्रतिद्वंद्वियों से Scrapy को अलग करती हैं और इसे वेब स्क्रैपिंग क्षेत्र में एक लोकप्रिय विकल्प के रूप में स्थापित करती हैं।

Scrapy ट्विस्टेड, एक अतुल्यकालिक ओपन-सोर्स नेटवर्क इंजन द्वारा संचालित है। सिंक्रोनस ऑपरेशन के विपरीत, जहां एक कार्य को दूसरे शुरू होने से पहले पूरा किया जाना चाहिए, ट्विस्टेड कार्यों को समानांतर में निष्पादित करने की अनुमति देता है। इसका मतलब है कि Scrapy मकड़ियों एक साथ कई अनुरोधों और प्रक्रिया प्रतिक्रियाओं को भेज सकते हैं, डेटा संग्रह में गति और दक्षता को बढ़ा सकते हैं, विशेष रूप से बड़े पैमाने पर परियोजनाओं के लिए या एक साथ कई साइटों को स्कैन करते समय।

Scrapy की गति को कई कारकों द्वारा और बढ़ाया जाता है:

साथ में, ये विशेषताएं Scrapy को कुशलता से स्क्रैप करने और वेबसाइटों की भीड़ से डेटा एकत्र करने के लिए उपलब्ध सबसे तेज उपकरणों में से एक के रूप में स्थापित करती हैं, जिससे यह उत्पाद मूल्य की निगरानी, नौकरी लिस्टिंग, समाचार सभा, सोशल मीडिया विश्लेषण और शैक्षणिक अनुसंधान जैसे कार्यों के लिए एक अमूल्य संसाधन बन जाता है।

Scrapy की मॉड्यूलर आर्किटेक्चर इसकी अनुकूलनशीलता और विस्तार को बढ़ाता है, जिससे यह विभिन्न प्रकार के जटिल डेटा संग्रह कार्यों के लिए अच्छी तरह से अनुकूल होता है। MongoDB, PostgreSQL, और Elasticsearch जैसे विभिन्न डेटा स्टोरों के साथ एकीकरण के लिए इसका समर्थन, साथ ही Redis और RabbitMQ जैसे कतार प्रबंधन प्रणालियों, बड़े डेटा वॉल्यूम के प्रभावी हैंडलिंग के लिए अनुमति देता है। इसके अतिरिक्त, Scrapy प्रोमेथियस या लॉगस्टैश जैसे मॉनिटरिंग या लॉगिंग प्लेटफार्मों के साथ एकीकृत हो सकता है, मशीन लर्निंग डेटा संग्रह से लेकर खोज इंजन विकास तक की परियोजनाओं के लिए स्केलेबल और अनुकूलन योग्य स्क्रैपर कॉन्फ़िगरेशन को सक्षम कर सकता है।

Scrapy के आर्किटेक्चर के एक्स्टेंसिबल घटक:

इसके अलावा, एपीआई इंटरैक्शन के लिए कस्टम मॉड्यूल का समर्थन करने के लिए Scrapy की क्षमता बड़े पैमाने पर डेटा प्रोसेसिंग और जटिल परियोजना आवश्यकताओं की मांगों को पूरा करने के लिए स्केलिंग और टेलरिंग समाधान के लिए एक मजबूत ढांचा प्रदान करती है।

Scrapy का एक और महत्वपूर्ण लाभ इसकी पोर्टेबिलिटी है। फ्रेमवर्क विंडोज, मैकओएस और लिनक्स सहित कई ऑपरेटिंग सिस्टम का समर्थन करता है, जिससे यह विभिन्न विकास वातावरणों में उपयोग के लिए बहुमुखी बनाता है। स्थापना पायथन पैकेज मैनेजर (pip) का उपयोग करके सीधी है, और Scrapy के मॉड्यूलर संरचना और लचीले कॉन्फ़िगरेशन के लिए धन्यवाद, परियोजनाओं को आसानी से महत्वपूर्ण परिवर्तनों के बिना मशीनों के बीच स्थानांतरित किया जा सकता है।

इसके अलावा, Scrapy आभासी वातावरण का समर्थन करता है, जो परियोजना निर्भरता को अलग करता है और अन्य स्थापित पैकेजों के साथ संघर्षों से बचता है। यह सुविधा विशेष रूप से मूल्यवान है जब एक साथ कई परियोजनाओं पर काम कर रहे हैं या एक सर्वर पर अनुप्रयोगों को तैनात करते समय, एक स्वच्छ और स्थिर विकास वातावरण सुनिश्चित करते हैं।

Scrapy के साथ अधिक प्रभावी काम के लिए, विजुअल स्टूडियो कोड (वीएस कोड) या इसके एनालॉग्स जैसे कोड संपादक का उपयोग करने की सिफारिश की जाती है, क्योंकि फ्रेमवर्क के साथ बातचीत कमांड लाइन (सीएलआई) के माध्यम से किया जाता है। यह परियोजनाओं को प्रबंधित करने, साइटों को स्कैन करने और मकड़ियों को अधिक कुशलता से कॉन्फ़िगर करने की अनुमति देता है। इसके अतिरिक्त, निर्भरता का प्रबंधन करने के लिए आभासी वातावरण का उपयोग करने से पुस्तकालयों और पैकेज संस्करणों के बीच संघर्ष से बचने में मदद मिल सकती है, एक चिकनी वर्कफ़्लो सुनिश्चित करना।

Scrapy में एक परियोजना बनाना और चलाना सीधे चरणों की एक श्रृंखला शामिल है:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # प्रोजेक्ट सेटिंग्स

myproject/

__init__.py

items.py # डेटा मॉडल परिभाषाएँ

middlewares.py # Middleware

pipelines.py # डाटा प्रासेसिंग

settings.py # Scrapy सेटिंग्स

spiders/ # मकड़ियों का फ़ोल्डर

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

यहाँ, "quotes" QuotesSpider वर्ग में परिभाषित मकड़ी का नाम है। Scrapy निर्दिष्ट URL को क्रॉल करने और आपकी परिभाषित सेटिंग्स के अनुसार डेटा निकालने के लिए मकड़ी को निष्पादित करेगा।

scrapy crawl quotes -o quotes.json

Scrapy एक मजबूत, मुफ्त वेब स्क्रैपिंग फ्रेमवर्क है जिसे डेवलपर्स को स्वचालित डेटा निष्कर्षण और वेब पेजों से प्रसंस्करण के लिए व्यापक उपकरण देने के लिए डिज़ाइन किया गया है। इसकी एसिंक्रोनस आर्किटेक्चर और मॉड्यूलर संरचना उच्च गति और उत्कृष्ट स्केलेबिलिटी सुनिश्चित करती है, जिससे आवश्यकता के अनुसार कार्यक्षमता के विस्तार की सुविधा होती है। इसके अतिरिक्त, कस्टम प्रोटोकॉल के समर्थन के साथ विभिन्न पुस्तकालयों और डेटा भंडारण समाधानों के साथ Scrapy का सहज एकीकरण, विशिष्ट परियोजना आवश्यकताओं को पूरा करने के लिए क्रॉलर के अनुकूलन को सरल बनाता है। यह वेब Scrapyपिंग प्रक्रिया को न केवल अधिक कुशल बनाता है, बल्कि अधिक अनुकूलनीय और उपयोगकर्ता के अनुकूल भी बनाता है।

टिप्पणियाँ: 0