vn

vn  English

English  Español

Español  中國人

中國人  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy là một framework cấp cao, mạnh mẽ được thiết kế để thu thập và trích xuất dữ liệu web, lý tưởng cho các tác vụ như phân tích dữ liệu, theo dõi giá, phân tích hành vi người dùng, phân tích mạng xã hội và SEO. Framework này được trang bị để xử lý khối lượng lớn dữ liệu một cách hiệu quả. Nó bao gồm các cơ chế tích hợp để quản lý yêu cầu HTTP, xử lý lỗi và đảm bảo tuân thủ robots.txt, vốn rất quan trọng để điều hướng trong các dự án thu thập dữ liệu web phức tạp và quy mô lớn. Bài viết này sẽ đi sâu vào Scrapy là gì, cách nó hoạt động và những tính năng mà nó cung cấp cho người dùng, nhằm cung cấp cái nhìn toàn diện về năng lực và ứng dụng của nó.

Framework Scrapy là một công cụ mã nguồn mở mạnh mẽ được viết bằng Python, được thiết kế để thu thập dữ liệu hiệu suất cao và trích xuất dữ liệu có cấu trúc từ các trang web. Nó có thể tổ chức dữ liệu đã trích xuất thành định dạng JSON và CSV hoặc lưu trực tiếp vào các cơ sở dữ liệu như SQLite, MySQL, PostgreSQL và MongoDB. Scrapy hỗ trợ nhiều phương pháp phân tích cú pháp bao gồm CSS selectors và XPath, và có thể xử lý phản hồi JSON và XML, điều này rất quan trọng khi làm việc với các API.

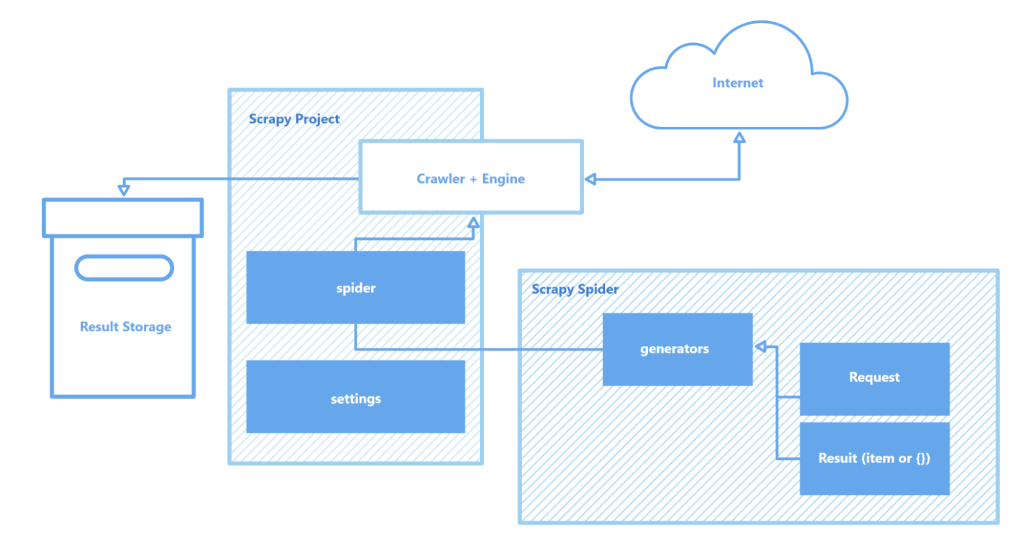

Scrapy hoạt động thông qua các “spider” – trình thu thập chuyên biệt tuân theo các hướng dẫn xác định để điều hướng các trang web và thu hoạch dữ liệu. Các spider này thực chất là các script có chức năng xác định và trích xuất các đối tượng cụ thể như văn bản, hình ảnh hoặc liên kết. Một trình shell thu thập dữ liệu tương tác được Scrapy cung cấp giúp thử nghiệm và gỡ lỗi các spider theo thời gian thực, qua đó nâng cao đáng kể quy trình thiết lập và tối ưu hóa.

Các thành phần chính của kiến trúc Scrapy bao gồm:

Tổng thể, Scrapy nổi bật như một trong những công cụ thu thập dữ liệu web mạnh mẽ và linh hoạt nhất, phù hợp với mọi thứ từ các tác vụ trích xuất dữ liệu đơn giản đến các dự án khai thác dữ liệu quy mô lớn phức tạp.

Phần này nêu bật các tính năng chính của Scrapy: tốc độ trong thu thập và xử lý dữ liệu, khả năng mở rộng chức năng và tính di động. Những đặc điểm này làm nổi bật Scrapy so với các đối thủ và biến nó thành lựa chọn phổ biến trong lĩnh vực thu thập dữ liệu web.

Scrapy được vận hành bởi Twisted – một engine mạng mã nguồn mở bất đồng bộ. Khác với xử lý tuần tự, nơi một tác vụ phải hoàn thành trước khi bắt đầu tác vụ khác, Twisted cho phép thực thi song song. Điều này nghĩa là các spider Scrapy có thể gửi nhiều yêu cầu và xử lý phản hồi đồng thời, tăng tốc độ và hiệu quả thu thập dữ liệu, đặc biệt trong các dự án quy mô lớn hoặc quét nhiều trang cùng lúc.

Tốc độ của Scrapy được tăng cường bởi nhiều yếu tố:

Tổng hợp lại, những tính năng này khiến Scrapy trở thành một trong những công cụ nhanh nhất để thu thập dữ liệu hiệu quả từ nhiều trang web, rất hữu ích cho các nhiệm vụ như giám sát giá sản phẩm, danh sách việc làm, thu thập tin tức, phân tích mạng xã hội và nghiên cứu học thuật.

Kiến trúc mô-đun của Scrapy nâng cao khả năng thích ứng và mở rộng, khiến nó phù hợp với nhiều nhiệm vụ thu thập dữ liệu phức tạp. Scrapy hỗ trợ tích hợp với nhiều kho dữ liệu khác nhau như MongoDB, PostgreSQL và Elasticsearch, cũng như các hệ thống quản lý hàng đợi như Redis và RabbitMQ, cho phép xử lý hiệu quả khối lượng dữ liệu lớn. Ngoài ra, Scrapy còn có thể tích hợp với các nền tảng giám sát hoặc ghi log như Prometheus hoặc Logstash, giúp cấu hình trình thu thập có thể mở rộng và tùy chỉnh cho các dự án từ thu thập dữ liệu phục vụ machine learning đến phát triển công cụ tìm kiếm.

Các thành phần mở rộng của kiến trúc Scrapy:

Thêm vào đó, khả năng hỗ trợ các module tùy chỉnh cho tương tác API của Scrapy cung cấp một nền tảng mạnh mẽ để mở rộng quy mô và điều chỉnh giải pháp phù hợp với yêu cầu xử lý dữ liệu lớn và các dự án phức tạp.

Một lợi thế quan trọng khác của Scrapy là tính di động. Framework này hỗ trợ nhiều hệ điều hành như Windows, macOS và Linux, khiến nó linh hoạt cho nhiều môi trường phát triển. Việc cài đặt rất đơn giản thông qua trình quản lý gói Python (pip), và nhờ vào cấu trúc mô-đun cũng như cấu hình linh hoạt của Scrapy, các dự án có thể dễ dàng được chuyển giữa các máy mà không cần thay đổi đáng kể.

Hơn nữa, Scrapy hỗ trợ các môi trường ảo (virtual environments), giúp cô lập các phụ thuộc dự án và tránh xung đột với các gói đã cài đặt khác. Tính năng này đặc biệt hữu ích khi làm việc với nhiều dự án cùng lúc hoặc khi triển khai ứng dụng lên máy chủ, đảm bảo môi trường phát triển sạch và ổn định.

Để làm việc hiệu quả hơn với Scrapy, nên sử dụng trình soạn thảo mã như Visual Studio Code (VS Code) hoặc phần mềm tương tự, vì việc tương tác với framework được thực hiện qua dòng lệnh (CLI). Điều này cho phép quản lý dự án, quét trang và cấu hình spider một cách hiệu quả. Ngoài ra, sử dụng môi trường ảo để quản lý các gói phụ thuộc có thể giúp tránh xung đột giữa các thư viện và phiên bản gói, đảm bảo quy trình làm việc mượt mà hơn.

Tạo và chạy một dự án Scrapy bao gồm một chuỗi các bước đơn giản:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Cài đặt dự án

myproject/

__init__.py

items.py # Định nghĩa mô hình dữ liệu

middlewares.py # Middlewares

pipelines.py # Xử lý dữ liệu

settings.py # Cài đặt phế liệu

spiders/ # Thư mục nhện

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Ở đây, “quotes” là tên của spider được định nghĩa trong lớp QuotesSpider. Scrapy sẽ chạy spider để thu thập dữ liệu từ URL đã chỉ định theo các thiết lập của bạn.

scrapy crawl quotes -o quotes.json

Scrapy là một framework thu thập dữ liệu web mạnh mẽ và miễn phí, được thiết kế để cung cấp cho lập trình viên các công cụ toàn diện để tự động hóa việc trích xuất và xử lý dữ liệu từ các trang web. Kiến trúc bất đồng bộ và cấu trúc mô-đun của nó đảm bảo tốc độ cao và khả năng mở rộng vượt trội, cho phép mở rộng chức năng khi cần thiết. Bên cạnh đó, sự tích hợp mượt mà của Scrapy với nhiều thư viện và giải pháp lưu trữ dữ liệu, cùng với hỗ trợ các giao thức tùy chỉnh, giúp đơn giản hóa việc tùy biến crawler để phù hợp với yêu cầu cụ thể của từng dự án. Điều này làm cho quy trình thu thập dữ liệu web không chỉ hiệu quả hơn mà còn linh hoạt và thân thiện hơn với người dùng.

Bình luận: 0