tr

tr  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy, web kazıma ve veri çıkarma için tasarlanmış sağlam, üst düzey bir çerçevedir ve veri ayrıştırma, fiyat izleme, kullanıcı davranışı analizi, sosyal medya içgörüleri ve SEO analizi gibi görevler için idealdir. Bu çerçeve, büyük hacimli verileri verimli bir şekilde işlemek için donatılmıştır. Karmaşık ve büyük ölçekli web veri toplama projelerinde gezinmek için gerekli olan HTTP isteklerini yönetmek, hata işleme ve robots.txt ile uyumluluğu sağlamak için yerleşik mekanizmalar içerir. Bu inceleme, Scrapy'nin ne olduğunu, nasıl çalıştığını ve kullanıcılara sunduğu özellikleri inceleyerek, yetenekleri ve uygulamaları hakkında kapsamlı bir anlayış sağlayacaktır.

Scrapy çerçevesi, Python'da yazılmış, yüksek verimli tarama ve web sitelerinden yapılandırılmış verileri ayıklamak için tasarlanmış güçlü bir açık kaynaklı web kazıma aracıdır. Çıkarılan verileri JSON ve CSV formatlarında düzenleyebilir veya doğrudan SQLite, MySQL, PostgreSQL ve MongoDB gibi veritabanlarında saklayabilir. Scrapy, CSS seçicileri ve XPath dahil olmak üzere çeşitli ayrıştırma yöntemlerini destekler ve API'lerle uğraşırken çok önemli olan JSON ve XML yanıtlarını işleyebilir.

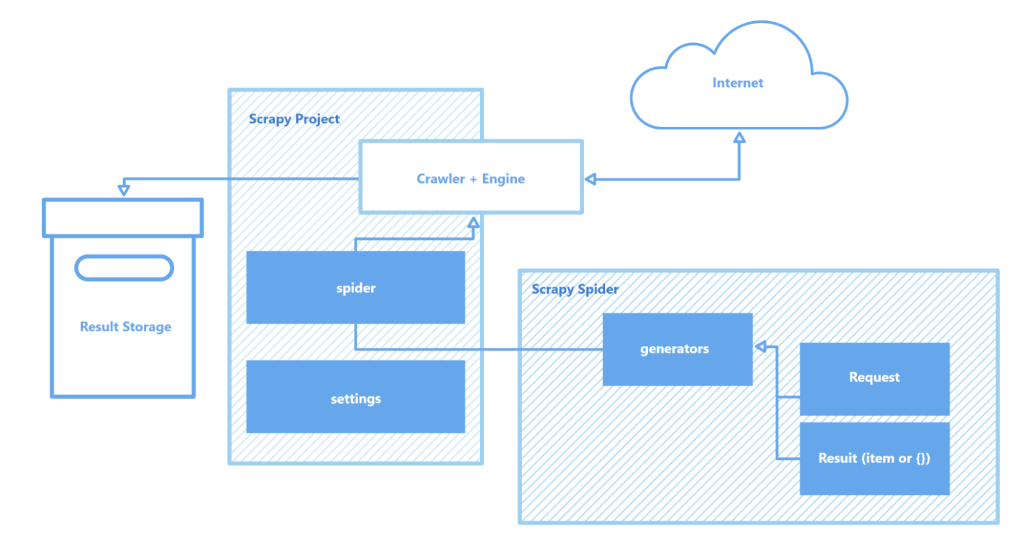

Scrapy, web sayfalarında gezinmek ve veri toplamak için tanımlanmış talimatları izleyen özel tarayıcılar olan "spiders" aracılığıyla çalışır. Bu örümcekler esasen metin, resim veya bağlantı gibi belirli nesne türlerini tanımlayan ve yakalayan komut dosyalarıdır. Scrapy tarafından sağlanan etkileşimli bir tarama kabuğu, bu örümceklerin gerçek zamanlı olarak test edilmesine ve hata ayıklanmasına olanak tanıyarak, tarayıcının kurulum ve optimizasyon sürecini büyük ölçüde geliştirir.

Scrapy mimarisinin temel bileşenleri şunlardır:

Genel olarak Scrapy, basit veri çıkarma görevlerinden karmaşık büyük ölçekli web madenciliği projelerine kadar her şey için uygun olan mevcut en sağlam ve esnek web kazıma araçlarından biri olarak öne çıkıyor.

Bu bölüm Scrapy çerçevesinin temel özelliklerini vurgulamaktadır: veri toplama ve işleme hızı, işlevselliği genişletme yeteneği ve taşınabilirlik. Bu özellikler Scrapy'yi rakiplerinden ayırır ve web kazıma arenasında popüler bir seçenek haline getirir.

Scrapy, asenkron bir açık kaynak ağ motoru olan Twisted tarafından desteklenmektedir. Bir görevin diğerinin başlamasından önce tamamlanması gereken eşzamanlı işlemlerin aksine, Twisted görevlerin paralel olarak yürütülmesine izin verir. Bu, Scrapy örümceklerinin aynı anda birden fazla istek gönderebileceği ve yanıtları işleyebileceği anlamına gelir, özellikle büyük ölçekli projeler için veya aynı anda birden fazla siteyi tararken veri toplamada hız ve verimliliği artırır.

Scrapy'nin hızı çeşitli faktörler tarafından daha da artırılır:

Bu özellikler birlikte, Scrapy'yi çok sayıda web sitesinden verimli bir şekilde veri kazıma ve toplama için mevcut en hızlı araçlardan biri haline getirerek, ürün fiyatı izleme, iş listeleri, haber toplama, sosyal medya analizi ve akademik araştırma gibi görevler için paha biçilmez bir kaynak haline getirir.

Scrapy'nin modüler mimarisi, uyarlanabilirliğini ve genişletilebilirliğini artırarak onu çeşitli karmaşık veri toplama görevleri için çok uygun hale getirir. MongoDB, PostgreSQL ve Elasticsearch gibi çeşitli veri depolarının yanı sıra Redis ve RabbitMQ gibi kuyruk yönetim sistemleriyle entegrasyon desteği, büyük veri hacimlerinin etkili bir şekilde ele alınmasını sağlar. Ayrıca Scrapy, Prometheus veya Logstash gibi izleme veya kayıt platformlarıyla entegre olabilir ve makine öğrenimi veri toplamadan arama motoru geliştirmeye kadar çeşitli projeler için ölçeklenebilir ve özelleştirilebilir kazıyıcı yapılandırmaları sağlar.

Scrapy'nin mimarisinin genişletilebilir bileşenleri:

Ayrıca, Scrapy'nin API etkileşimleri için özel modülleri destekleme yeteneği, büyük ölçekli veri işleme ve karmaşık proje gereksinimlerinin taleplerini karşılamak için çözümleri ölçeklendirmek ve uyarlamak için sağlam bir çerçeve sağlar.

Scrapy'nin bir diğer önemli avantajı da taşınabilirliğidir. Çerçeve, Windows, macOS ve Linux dahil olmak üzere birden fazla işletim sistemini destekleyerek çeşitli geliştirme ortamlarında kullanım için çok yönlü hale getirir. Python paket yöneticisi (pip) kullanılarak kurulum kolaydır ve Scrapy'nin modüler yapısı ve esnek yapılandırması sayesinde projeler önemli değişiklikler olmadan makineler arasında kolayca aktarılabilir.

Ayrıca Scrapy, proje bağımlılıklarını izole eden ve diğer yüklü paketlerle çakışmaları önleyen sanal ortamları destekler. Bu özellik, aynı anda birden fazla proje üzerinde çalışırken veya uygulamaları bir sunucuya dağıtırken özellikle değerlidir ve temiz ve istikrarlı bir geliştirme ortamı sağlar.

Scrapy ile daha etkili çalışmak için, Visual Studio Code (VS Code) veya benzerleri gibi bir kod düzenleyici kullanılması önerilir, çünkü çerçeve ile etkileşim komut satırı (CLI) üzerinden gerçekleştirilir. Bu, projelerin yönetilmesine, sitelerin taranmasına ve örümceklerin daha verimli bir şekilde yapılandırılmasına olanak tanır. Ayrıca, bağımlılıkları yönetmek için sanal ortamların kullanılması, kütüphaneler ve paket sürümleri arasındaki çakışmaları önlemeye yardımcı olarak daha sorunsuz bir iş akışı sağlayabilir.

Scrapy'de bir proje oluşturmak ve çalıştırmak bir dizi basit adım içerir:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Proje ayarları

myproject/

__init__.py

items.py # Veri modeli tanımları

middlewares.py # Middlewares

pipelines.py # Veri işleme

settings.py # Scrapy ayarları

spiders/ # Örümcekler klasörü

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Burada, "quotes" QuotesSpider sınıfında tanımlanan örümceğin adıdır. Scrapy, belirtilen URL'yi taramak ve tanımladığınız ayarlara göre veri çıkarmak için örümceği çalıştıracaktır.

scrapy crawl quotes -o quotes.json

Scrapy, geliştiricilere web sayfalarından otomatik veri çıkarma ve işleme için kapsamlı araçlar sunmak üzere tasarlanmış sağlam, ücretsiz bir web kazıma çerçevesidir. Eşzamansız mimarisi ve modüler yapısı, yüksek hız ve mükemmel ölçeklenebilirlik sağlayarak işlevselliğin gerektiği gibi genişletilmesini kolaylaştırır. Ek olarak, Scrapy'nin çeşitli kütüphaneler ve veri depolama çözümleriyle sorunsuz entegrasyonu ve özel protokol desteği, belirli proje gereksinimlerini karşılamak için tarayıcının özelleştirilmesini kolaylaştırır. Bu, web kazıma sürecini yalnızca daha verimli değil, aynı zamanda daha uyarlanabilir ve kullanıcı dostu hale getirir.

Yorumlar: 0