de

de  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Scrapy ist ein robustes High-Level-Framework, das für Web-Scraping und Datenextraktion entwickelt wurde. Es eignet sich ideal für Aufgaben wie Daten-Parsing, Preisüberwachung, Analyse des Nutzerverhaltens, Einblicke in soziale Medien und SEO-Analyse. Dieses Framework ist in der Lage, große Datenmengen effizient zu verarbeiten. Es enthält integrierte Mechanismen zur Verwaltung von HTTP-Anfragen, zur Fehlerbehandlung und zur Sicherstellung der Einhaltung von robots.txt, die für die Steuerung komplexer und umfangreicher Webdatenerfassungsprojekte unerlässlich sind. In diesem Beitrag wird erläutert, was Scrapy ist, wie es funktioniert und welche Funktionen es den Nutzern bietet, um ein umfassendes Verständnis für seine Fähigkeiten und Anwendungen zu vermitteln.

Das Scrapy-Framework ist ein leistungsstarkes, in Python geschriebenes Open-Source-Web-Scraping-Tool, das für das hocheffiziente Crawlen und Extrahieren strukturierter Daten aus Websites entwickelt wurde. Es kann die extrahierten Daten in JSON- und CSV-Formaten organisieren oder sie direkt in Datenbanken wie SQLite, MySQL, PostgreSQL und MongoDB speichern. Scrapy unterstützt verschiedene Parsing-Methoden, darunter CSS-Selektoren und XPath, und kann JSON- und XML-Antworten verarbeiten, was für den Umgang mit APIs entscheidend ist.

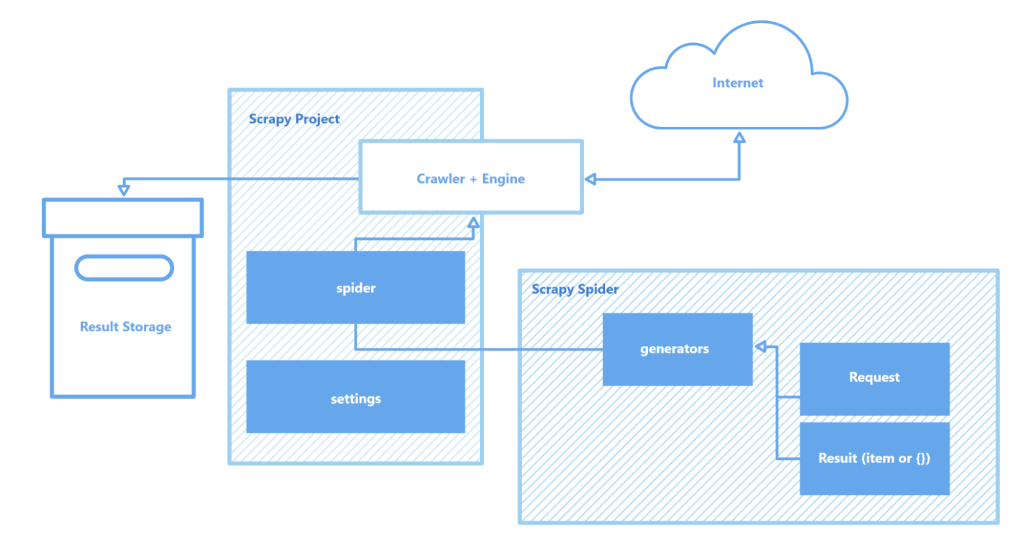

Scrapy arbeitet mit "Spidern" - spezialisierten Crawlern, die bestimmten Anweisungen folgen, um durch Webseiten zu navigieren und Daten zu sammeln. Diese Spider sind im Wesentlichen Skripte, die bestimmte Arten von Objekten wie Text, Bilder oder Links identifizieren und erfassen. Eine interaktive Crawling-Shell, die von Scrapy bereitgestellt wird, ermöglicht das Testen und Debuggen dieser Spider in Echtzeit, was den Einrichtungs- und Optimierungsprozess des Crawlers erheblich verbessert.

Zu den wichtigsten Komponenten der Scrapy-Architektur gehören:

Insgesamt ist Scrapy eines der robustesten und flexibelsten Web-Scraping-Tools auf dem Markt, das sich für alles eignet, von einfachen Datenextraktionsaufgaben bis hin zu komplexen groß angelegten Web-Mining-Projekten.

In diesem Abschnitt werden die wichtigsten Merkmale des Scrapy-Frameworks hervorgehoben: seine Geschwindigkeit bei der Datenerfassung und -verarbeitung, die Möglichkeit, die Funktionalität zu erweitern, und die Portabilität. Diese Eigenschaften unterscheiden Scrapy von seinen Konkurrenten und machen es zu einer beliebten Wahl im Bereich des Web Scraping.

Scrapy wird von Twisted unterstützt, einer asynchronen Open-Source-Netzwerk-Engine. Im Gegensatz zu synchronen Operationen, bei denen eine Aufgabe abgeschlossen sein muss, bevor eine andere beginnt, ermöglicht Twisted die parallele Ausführung von Aufgaben. Das bedeutet, dass Scrapy-Spider mehrere Anfragen senden und Antworten gleichzeitig verarbeiten können, was die Geschwindigkeit und Effizienz bei der Datenerfassung erhöht, insbesondere bei großen Projekten oder beim gleichzeitigen Scannen mehrerer Standorte.

Die Geschwindigkeit von Scrapy wird durch mehrere Faktoren weiter erhöht:

Zusammengenommen machen diese Funktionen Scrapy zu einem der schnellsten Tools, die es für das effiziente Scrapen und Sammeln von Daten aus einer Vielzahl von Websites gibt. Das macht es zu einer unschätzbaren Ressource für Aufgaben wie die Überwachung von Produktpreisen, Stellenangeboten, das Sammeln von Nachrichten, die Analyse sozialer Medien und die akademische Forschung.

Die modulare Architektur von Scrapy verbessert seine Anpassungsfähigkeit und Erweiterbarkeit, wodurch es sich für eine Vielzahl komplexer Datenerfassungsaufgaben eignet. Die Unterstützung für die Integration mit verschiedenen Datenspeichern wie MongoDB, PostgreSQL und Elasticsearch sowie Warteschlangenmanagementsystemen wie Redis und RabbitMQ ermöglicht die effektive Verarbeitung großer Datenmengen. Darüber hinaus kann Scrapy in Überwachungs- oder Protokollierungsplattformen wie Prometheus oder Logstash integriert werden, was skalierbare und anpassbare Scraper-Konfigurationen für Projekte ermöglicht, die von der Datensammlung für maschinelles Lernen bis zur Entwicklung von Suchmaschinen reichen.

Erweiterbare Komponenten der Architektur von Scrapy:

Darüber hinaus bietet Scrapy durch seine Fähigkeit, benutzerdefinierte Module für API-Interaktionen zu unterstützen, einen robusten Rahmen für die Skalierung und Anpassung von Lösungen an die Anforderungen einer umfangreichen Datenverarbeitung und komplexer Projektanforderungen.

Ein weiterer wesentlicher Vorteil von Scrapy ist seine Portabilität. Das Framework unterstützt mehrere Betriebssysteme, darunter Windows, macOS und Linux, und ist damit vielseitig in verschiedenen Entwicklungsumgebungen einsetzbar. Die Installation erfolgt unkompliziert über den Python-Paketmanager (pip), und dank des modularen Aufbaus und der flexiblen Konfiguration von Scrapy können Projekte ohne größere Änderungen zwischen verschiedenen Rechnern übertragen werden.

Außerdem unterstützt Scrapy virtuelle Umgebungen, die Projektabhängigkeiten isolieren und Konflikte mit anderen installierten Paketen vermeiden. Diese Funktion ist besonders wertvoll, wenn an mehreren Projekten gleichzeitig gearbeitet wird oder wenn Anwendungen auf einem Server bereitgestellt werden, um eine saubere und stabile Entwicklungsumgebung zu gewährleisten.

Für eine effektivere Arbeit mit Scrapy wird empfohlen, einen Code-Editor wie Visual Studio Code (VS Code) oder seine Analoga zu verwenden, da die Interaktion mit dem Framework über die Kommandozeile (CLI) erfolgt. Dies ermöglicht eine effizientere Verwaltung von Projekten, das Scannen von Websites und die Konfiguration von Spidern. Außerdem können durch die Verwendung virtueller Umgebungen zur Verwaltung von Abhängigkeiten Konflikte zwischen Bibliotheken und Paketversionen vermieden werden, was einen reibungsloseren Arbeitsablauf gewährleistet.

Das Erstellen und Ausführen eines Projekts in Scrapy umfasst eine Reihe von einfachen Schritten:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Projekt-Einstellungen

myproject/

__init__.py

items.py # Datenmodell-Definitionen

middlewares.py # Middlewares

pipelines.py # Datenverarbeitung

settings.py # Scrapy-Einstellungen

spiders/ # Ordner Spinnen

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Hier ist "quotes" der Name des Spiders, der in der Klasse QuotesSpider definiert ist. Scrapy führt den Spider aus, um die angegebene URL zu crawlen und Daten gemäß den von Ihnen definierten Einstellungen zu extrahieren.

scrapy crawl quotes -o quotes.json

Scrapy ist ein robustes, kostenloses Web-Scraping-Framework, das Entwicklern umfassende Werkzeuge für die automatisierte Datenextraktion und -verarbeitung aus Webseiten bietet. Die asynchrone Architektur und der modulare Aufbau sorgen für hohe Geschwindigkeit und hervorragende Skalierbarkeit und erleichtern die Erweiterung der Funktionalität nach Bedarf. Darüber hinaus vereinfacht die nahtlose Integration von Scrapy in verschiedene Bibliotheken und Datenspeicherlösungen sowie die Unterstützung von benutzerdefinierten Protokollen die Anpassung des Crawlers an spezifische Projektanforderungen. Dies macht den Web-Scraping-Prozess nicht nur effizienter, sondern auch anpassungsfähiger und benutzerfreundlicher.

Bemerkungen: 0