pt

pt  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski O Scrapy é uma estrutura robusta de alto nível concebida para raspagem da Web e extração de dados, o que o torna ideal para tarefas como análise de dados, monitorização de preços, análise do comportamento do utilizador, informações sobre redes sociais e análise de SEO. Esta estrutura está equipada para lidar com grandes volumes de dados de forma eficiente. Ele inclui mecanismos integrados para gerenciar solicitações HTTP, tratamento de erros e garantia de conformidade com o robots.txt, que são essenciais para navegar em projetos complexos e de grande escala de coleta de dados da Web. Esta revisão irá aprofundar o que é o Scrapy, como funciona e as funcionalidades que oferece aos utilizadores, fornecendo uma compreensão abrangente das suas capacidades e aplicações.

A estrutura Scrapy é uma poderosa ferramenta de raspagem da Web de código aberto escrita em Python, concebida para rastrear e extrair dados estruturados de sítios Web com elevada eficiência. Pode organizar os dados extraídos nos formatos JSON e CSV ou armazená-los diretamente em bases de dados como SQLite, MySQL, PostgreSQL e MongoDB. O Scrapy suporta vários métodos de análise, incluindo selectores CSS e XPath, e pode tratar respostas JSON e XML, o que é crucial quando se lida com APIs.

O Scrapy funciona através de "spiders" - crawlers especializados que seguem instruções definidas para navegar em páginas Web e recolher dados. Estes spiders são essencialmente scripts que identificam e capturam tipos específicos de objectos como texto, imagens ou links. Um shell de rastreio interativo fornecido pelo Scrapy permite o teste e a depuração em tempo real destes spiders, melhorando consideravelmente o processo de configuração e otimização do crawler.

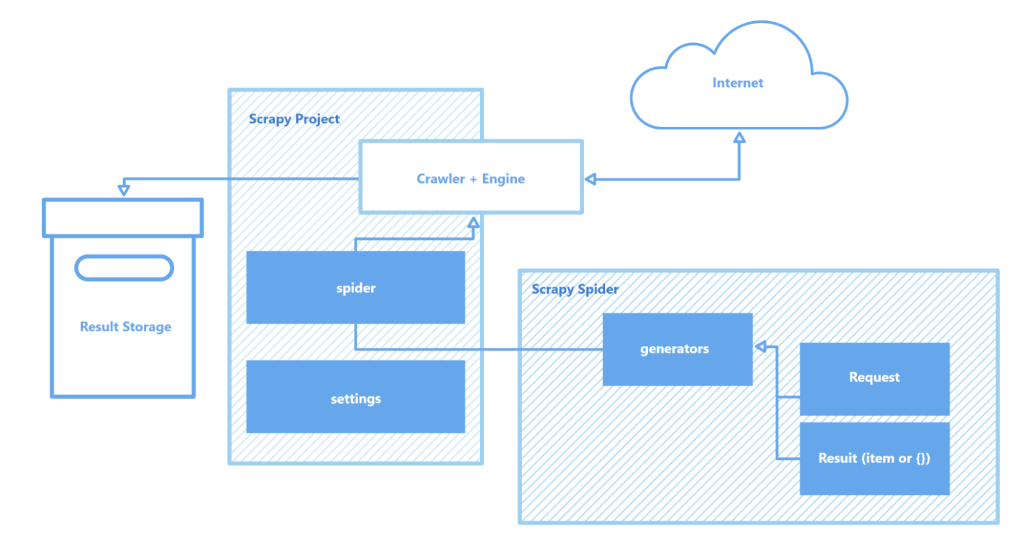

Os principais componentes da arquitetura Scrapy incluem:

No geral, o Scrapy destaca-se como uma das ferramentas de raspagem da Web mais robustas e flexíveis disponíveis, adequada para tudo, desde tarefas simples de extração de dados até projectos complexos de extração da Web em grande escala.

Esta secção destaca as principais caraterísticas da estrutura do Scrapy: a sua velocidade na recolha e processamento de dados, a capacidade de alargar a funcionalidade e a portabilidade. Esses atributos diferenciam o Scrapy de seus concorrentes e o estabelecem como uma escolha popular na área de raspagem da Web.

O Scrapy é alimentado pelo Twisted, um motor de rede assíncrono de código aberto. Ao contrário das operações síncronas, em que uma tarefa deve ser concluída antes de outra começar, o Twisted permite que as tarefas sejam executadas em paralelo. Isto significa que os spiders do Scrapy podem enviar vários pedidos e processar as respostas em simultâneo, aumentando a velocidade e a eficiência na recolha de dados, especialmente em projectos de grande escala ou ao analisar vários sites em simultâneo.

A velocidade do Scrapy é ainda aumentada por vários factores:

Em conjunto, estas caraterísticas fazem do Scrapy uma das ferramentas mais rápidas disponíveis para extrair e recolher dados de forma eficiente a partir de uma multiplicidade de sítios Web, tornando-o um recurso inestimável para tarefas como a monitorização de preços de produtos, listagens de empregos, recolha de notícias, análise de redes sociais e investigação académica.

A arquitetura modular do Scrapy aumenta a sua adaptabilidade e extensibilidade, tornando-o adequado para uma variedade de tarefas complexas de recolha de dados. Seu suporte para integração com vários armazenamentos de dados, como MongoDB, PostgreSQL e Elasticsearch, bem como sistemas de gerenciamento de filas, como Redis e RabbitMQ, permite o manuseio eficaz de grandes volumes de dados. Além disso, o Scrapy pode integrar-se com plataformas de monitorização ou registo como o Prometheus ou o Logstash, permitindo configurações de raspadores escaláveis e personalizáveis para projectos que vão desde a recolha de dados de aprendizagem automática até ao desenvolvimento de motores de busca.

Componentes extensíveis da arquitetura do Scrapy:

Além disso, a capacidade do Scrapy para suportar módulos personalizados para interações API fornece uma estrutura robusta para escalar e adaptar soluções para satisfazer as exigências do processamento de dados em grande escala e requisitos de projectos complexos.

Outra vantagem significativa do Scrapy é sua portabilidade. O framework suporta vários sistemas operacionais, incluindo Windows, macOS e Linux, tornando-o versátil para uso em vários ambientes de desenvolvimento. A instalação é simples usando o gerenciador de pacotes Python (pip) e, graças à estrutura modular e à configuração flexível do Scrapy, os projetos podem ser facilmente transferidos entre máquinas sem alterações significativas.

Além disso, o Scrapy suporta ambientes virtuais, que isolam as dependências do projeto e evitam conflitos com outros pacotes instalados. Esse recurso é particularmente valioso ao trabalhar em vários projetos simultaneamente ou ao implantar aplicativos em um servidor, garantindo um ambiente de desenvolvimento limpo e estável.

Para um trabalho mais eficaz com o Scrapy, recomenda-se a utilização de um editor de código como o Visual Studio Code (VS Code) ou os seus análogos, uma vez que a interação com a estrutura é realizada através da linha de comandos (CLI). Isso permite gerenciar projetos, escanear sites e configurar spiders de forma mais eficiente. Além disso, o uso de ambientes virtuais para gerenciar dependências pode ajudar a evitar conflitos entre bibliotecas e versões de pacotes, garantindo um fluxo de trabalho mais suave.

Criar e executar um projeto no Scrapy envolve uma série de etapas simples:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Definições do projeto

myproject/

__init__.py

items.py # Definições do modelo de dados

middlewares.py # Middlewares

pipelines.py # Processamento de dados

settings.py # Definições do Scrapy

spiders/ # Pasta de aranhas

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Aqui, "quotes" é o nome do spider definido na classe QuotesSpider. O Scrapy executará o spider para rastrear o URL especificado e extrair dados de acordo com as configurações definidas.

scrapy crawl quotes -o quotes.json

O Scrapy é uma estrutura de raspagem da Web robusta e gratuita, concebida para fornecer aos programadores ferramentas abrangentes para extração e processamento automatizados de dados de páginas Web. A sua arquitetura assíncrona e a sua estrutura modular garantem uma elevada velocidade e uma excelente escalabilidade, facilitando a expansão da funcionalidade conforme necessário. Além disso, a integração perfeita do Scrapy com várias bibliotecas e soluções de armazenamento de dados, juntamente com o suporte para protocolos personalizados, simplifica a personalização do crawler para satisfazer os requisitos específicos do projeto. Isto torna o processo de recolha de dados da Web não só mais eficiente, mas também mais adaptável e fácil de utilizar.

Comentários: 0