pt

pt  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski As ferramentas de raspagem da Web são software especializado concebido para extrair automaticamente dados de sítios Web, organizando-os num formato utilizável. Estas ferramentas são essenciais para várias tarefas, como a recolha de dados, o arquivo digital e a realização de análises aprofundadas. Com a capacidade de extrair e analisar meticulosamente os dados da página, as ferramentas avançadas de raspagem da Web garantem a precisão e a relevância das informações que recolhem.

A sua capacidade de lidar com a extração de dados em grande escala torna-as um recurso crítico para as empresas envolvidas na análise da concorrência, pesquisa de mercado e geração de leads. Estas ferramentas não só simplificam os processos, como também proporcionam vantagens competitivas significativas, oferecendo rapidamente conhecimentos profundos.

Neste artigo, exploraremos as principais ferramentas de raspagem da web de 2024. Cobriremos uma variedade de opções, incluindo ferramentas baseadas em navegador, estruturas de programação, bibliotecas, APIs e soluções de software como serviço (SaaS).

Ao selecionar uma ferramenta de raspagem da Web, há vários fatores-chave a serem considerados:

A escolha de uma ferramenta de raspagem da Web depende em grande parte da complexidade da tarefa e do volume de dados que está a ser processado. Para tarefas mais simples, as extensões do navegador são muitas vezes suficientes. São fáceis de instalar e não requerem conhecimentos de programação, o que as torna uma boa escolha para tarefas simples de recolha de dados. Para soluções mais complexas e personalizáveis, as estruturas são mais adequadas, pois oferecem mais flexibilidade e controlo. Se for necessário um elevado nível de automatização e gestão, os raspadores orientados para API fornecem um serviço totalmente gerido que pode tratar grandes volumes de dados de forma eficiente.

Fizemos a curadoria de uma lista dos 11 melhores raspadores que atendem a uma variedade de necessidades. Essa seleção inclui programas poderosos projetados para tarefas complexas de raspagem da Web, bem como ferramentas universais que são fáceis de usar e não exigem conhecimento de programação. Quer seja um programador experiente que necessita de capacidades robustas de extração de dados ou um principiante que procura recolher facilmente dados da Web, esta lista tem opções que se adequam a diferentes níveis de especialização e exigências do projeto.

A Bright Data oferece uma plataforma de raspagem da Web robusta e de nível empresarial que inclui um IDE do Web Scraper com modelos de código prontos. Esses modelos são gerenciados e atualizados regularmente, garantindo que as operações de raspagem permaneçam eficazes, mesmo que o layout do site de destino seja alterado.

Bright Data também usa rotação de proxy e permite que você salve dados raspados em vários formatos, como JSON e CSV, ou diretamente para soluções de armazenamento em nuvem, como Google Cloud Storage ou Amazon S3.

Caraterísticas:

O raspador está disponível a partir de US $ 4,00 por mês e oferece uma versão de avaliação gratuita para os usuários testarem seus recursos. Ele é bem visto no G2, onde tem uma classificação de 4,6 de 5,0.

O Octoparse é uma ferramenta de raspagem da Web sem código e fácil de usar que simplifica as tarefas de raspagem sem exigir nenhuma habilidade de codificação. Projetado para usuários experientes e novatos, ele oferece uma abordagem visual para a extração de dados, exigindo o mínimo ou nenhuma habilidade de codificação.

Uma das caraterísticas de destaque do Octoparse é o seu assistente de IA. Esta funcionalidade ajuda os utilizadores a detetar automaticamente padrões de dados em websites e oferece dicas úteis para uma extração de dados eficaz. Além disso, o Octoparse oferece uma biblioteca de modelos predefinidos para sites populares, que podem ser usados para obter dados instantaneamente.

Caraterísticas:

O raspador começa em US $ 75,00 por mês e inclui uma avaliação gratuita. Ele é classificado como 4.5 / 5.0 no Capterra e 4.3 / 5.0 no G2.

O WebScraper.io é uma extensão do Chrome e do Firefox projetada para uso regular e programado para extrair grandes quantidades de dados manual ou automaticamente.

É gratuito para uso local, com um serviço de nuvem pago disponível para agendar e gerenciar trabalhos de raspagem por meio de uma API. Essa ferramenta também suporta a raspagem de sites dinâmicos e salva dados em formatos estruturados como CSV, XLSX ou JSON.

O WebScraper.io facilita a raspagem da Web através de uma interface de apontar e clicar, permitindo que os utilizadores criem Mapas de Sites e seleccionem elementos sem qualquer conhecimento de codificação. Também é versátil para casos de uso como pesquisa de mercado, geração de leads e projetos acadêmicos.

Caraterísticas:

O raspador tem um preço de US $ 50 por mês e oferece uma avaliação gratuita. Ele tem uma classificação Capterra de 4,7 em 5.

Começar a usar o Scraper API é fácil para quem não é desenvolvedor, pois tudo o que os usuários precisam é de uma chave de API e URL para começar a raspar. Além de suportar renderizações JavaScript, o Scraper API é totalmente personalizável, permitindo que os usuários personalizem a solicitação e os parâmetros de cabeçalho para atender às suas necessidades.

Caraterísticas:

Você deve formatar suas solicitações para o ponto de extremidade da API da seguinte maneira:

import requests

payload = {'api_key': 'APIKEY', 'url': 'https://httpbin.org/ip'}

r = requests.get('http://api.scraperapi.com', params=payload)

print(r.text)

Este raspador está disponível a um preço introdutório de US $ 49 por mês e vem com uma avaliação gratuita. Ele tem uma classificação Capterra de 4,6 em 5 e uma classificação G2 de 4,3 em 5.

O Scraping Dog se destaca por sua simplicidade e facilidade de uso, fornecendo uma API que pode ser rapidamente integrada a vários aplicativos e fluxos de trabalho. É uma solução que atende a um amplo espetro de requisitos de raspagem, desde tarefas simples de coleta de dados até operações mais complexas.

O Scrapingdog também suporta renderização JS, que pode ser usada para raspar sites que exigem várias chamadas de API para carregar completamente.

Caraterísticas:

Aqui está um exemplo básico de como usar o endpoint da API do Scraping Dog:

import requests

url = "https://api.scrapingdog.com/scrape"

params = {

"api_key": "5e5a97e5b1ca5b194f42da86",

"url": "http://httpbin.org/ip",

"dynamic": "false"

}

response = requests.get(url, params=params)

print(response.text)

O raspador está disponível a partir de $ 30 por mês e inclui um teste gratuito. Ele tem uma classificação Trustpilot de 4,6 em 5.

O Apify é uma plataforma de software aberta que facilita o desenvolvimento e a execução de ferramentas de extração de dados, automação da Web e integração da Web em escala. É uma plataforma versátil baseada em nuvem que fornece um conjunto abrangente de ferramentas de raspagem e automação da Web. Ele foi projetado para desenvolvedores que precisam criar, executar e dimensionar tarefas de extração de dados e raspagem da Web sem gerenciar servidores.

O Apify também vem com uma biblioteca de raspagem da Web de código aberto chamada Crawlee e é compatível com Python e JavaScript. Com o Apify, você pode integrar seu conteúdo facilmente a aplicativos de terceiros, como Google Drive, GitHub e Slack, além de criar suas próprias integrações com webhooks e APIs.

Caraterísticas:

O raspador começa em US $ 49 por mês e inclui uma versão gratuita. Ele tem uma classificação de 4,8 de 5 em ambos Capterra e G2.

O ScrapingBee é uma API de raspagem da Web versátil, criada para lidar com uma ampla gama de tarefas de raspagem da Web com eficiência. Ele se destaca em áreas como raspagem de imóveis, monitoramento de preços e extração de revisões, permitindo que os usuários coletem dados sem problemas, sem medo de serem bloqueados.

A flexibilidade e a eficácia do ScrapingBee fazem dele um recurso inestimável para programadores, profissionais de marketing e investigadores que pretendem automatizar e simplificar o processo de recolha de dados de várias fontes em linha.

Caraterísticas:

Este raspador está disponível a partir de US $ 49 por mês e inclui uma versão gratuita. Ele possui uma classificação perfeita de 5,0 de 5 em Capterra.

O Diffbot se destaca com seus recursos avançados de IA e aprendizado de máquina, tornando-o altamente eficaz para a extração de conteúdo de páginas da web. É uma solução totalmente automatizada que é ótima na extração de dados estruturados.

O Diffbot é ideal para equipas de marketing e empresas focadas na geração de leads, pesquisa de mercado e análise de sentimentos. A sua capacidade de processar e estruturar dados em tempo real torna-o uma ferramenta poderosa para aqueles que precisam de uma extração de dados rápida e precisa sem a necessidade de uma configuração técnica extensa.

Caraterísticas:

O raspador tem um preço de $ 299 por mês e inclui um teste gratuito. Ele tem uma classificação Capterra de 4,5 em 5.

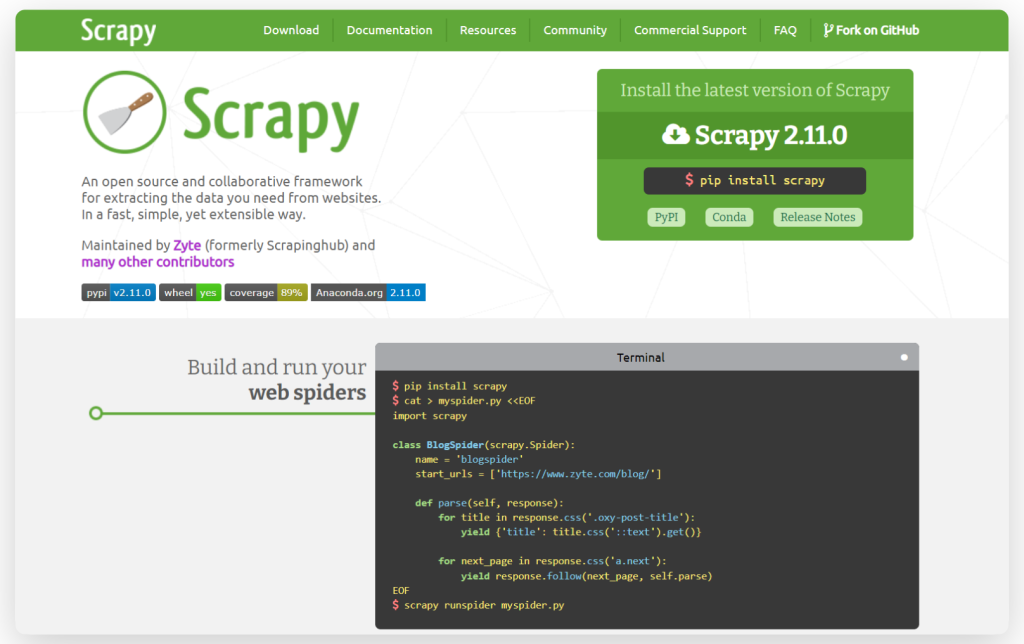

O Scrapy é uma estrutura robusta e de código aberto para rastreamento e raspagem da Web, conhecida por sua velocidade e eficiência. Escrito em Python, o Scrapy é compatível com vários sistemas operacionais, incluindo Linux, Windows, Mac e BSD. A estrutura permite a criação de agentes de pesquisa personalizados e oferece flexibilidade na personalização de seus componentes sem a necessidade de alterar o sistema principal. Isso torna o Scrapy uma ferramenta versátil para desenvolvedores que desejam adaptar suas ferramentas de raspagem a requisitos específicos.

Caraterísticas:

Aqui está um exemplo simples de como usar o Scrapy para extrair dados de um site:

import scrapy

class BlogSpider(scrapy.Spider):

name = 'blogspider'

start_urls = ['https://www.zyte.com/pt/blog/']

def parse(self, response):

for title in response.css('.oxy-post-title'):

yield {'title': title.css('::text').get()}

for next_page in response.css('a.next'):

yield response.follow(next_page, self.parse)

Beautiful Soup é uma biblioteca Python que facilita a recolha de informação de páginas web. É uma ótima ferramenta para iniciantes e é frequentemente usada para projetos rápidos de raspagem, ou quando você precisa raspar um site com estrutura HTML simples.

Caraterísticas:

Aqui está um exemplo básico de como usar o Beautiful Soup:

from bs4 import BeautifulSoup

html_doc ="""<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

soup = BeautifulSoup(html_doc, 'html.parser')

print(soup.title.string) # Outputs "The Dormouse's story"

Cheerio é uma biblioteca rápida, flexível e fácil de usar em Node.js que imita a funcionalidade central do jQuery. Utilizando o parser parse5 por padrão, Cheerio também oferece a opção de usar o htmlparser2, mais tolerante a erros. Esta biblioteca é capaz de analisar quase qualquer documento HTML ou XML, tornando-a uma excelente escolha para desenvolvedores que precisam de recursos de raspagem da web eficientes e versáteis.

Caraterísticas:

Aqui está um exemplo simples de Cheerio:

const cheerio = require('cheerio');

// some product webpage

const html = `

<html>

<head>

<title>Sample Page</title>

</head>

<body>

<h1>Welcome to a Product Page</h1>

<div class="products">

<div class="item">Product 1</div>

<div class="item">Product 2</div>

<div class="item">Product 3</div>

</div>

</body>

</html>

`;

const $ = cheerio.load(html);

$('.item').each(function () {

const product = $(this).text();

console.log(product);

});

Em resumo, cada raspador traz recursos exclusivos adequados para diferentes necessidades de raspagem. Cheerio e Beautiful Soup são bibliotecas de análise de HTML otimizadas para Node.js e Python, respetivamente. O Scrapy, outra ferramenta baseada em Python, é excelente para lidar com scripts complexos e gerenciar grandes conjuntos de dados como parte de uma estrutura abrangente de raspagem e análise da Web.

Para aqueles que estão avaliando plataformas ou serviços para raspagem da Web, aqui estão recomendações personalizadas com base em critérios de seleção comuns:

Comentários: 0