pl

pl  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia Skrobanie recenzji Amazon za pomocą Pythona jest przydatne podczas przeprowadzania analizy konkurencji, sprawdzania recenzji i przeprowadzania badań rynkowych. W tym artykule pokazano, jak skutecznie skrobać recenzje produktów na Amazon za pomocą Pythona, BeautifulSoup i bibliotek Requests.

Przed rozpoczęciem procesu scrapingu, upewnij się, że masz zainstalowane niezbędne biblioteki Python:

pip install requests

pip install beautifulsoup4Skupimy się na wyodrębnianiu recenzji produktów ze strony Amazon i przeanalizujemy każdy etap procesu scrapingu krok po kroku.

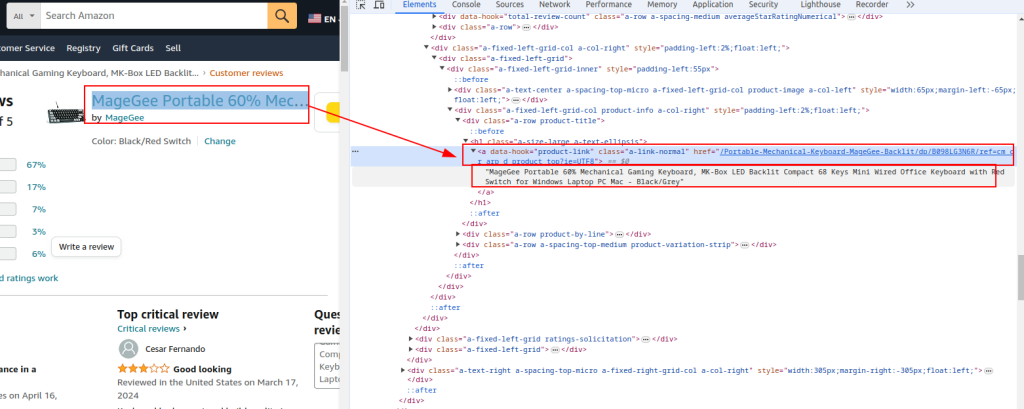

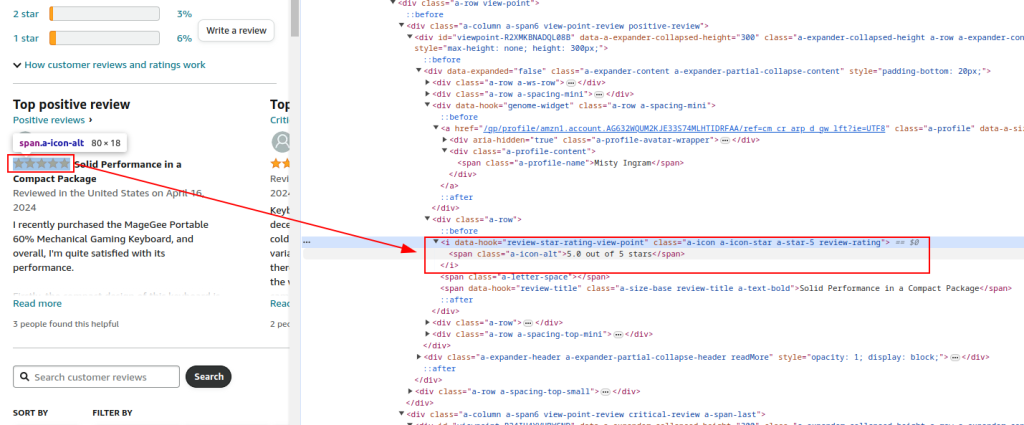

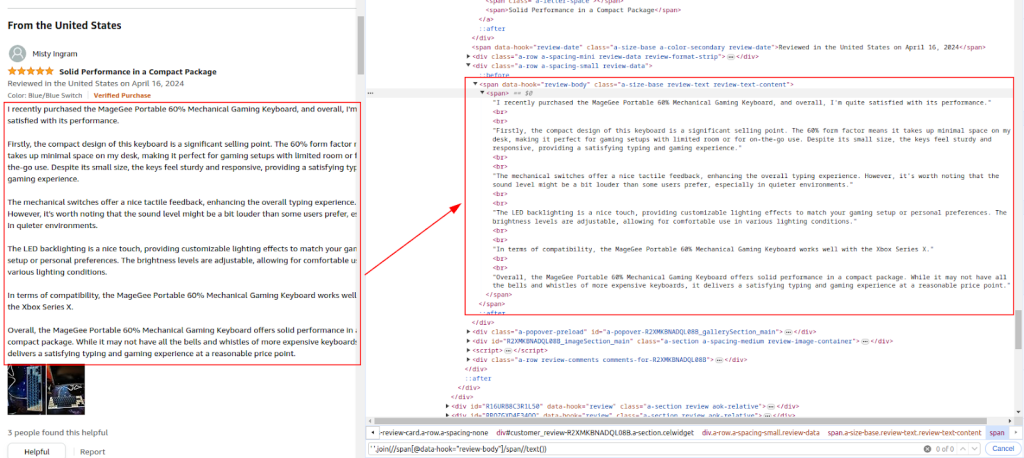

Sprawdź strukturę HTML strony z recenzjami produktów Amazon, aby zidentyfikować elementy, które chcemy zeskrobać: nazwy recenzentów, oceny i komentarze.

Tytuł produktu i adres URL:

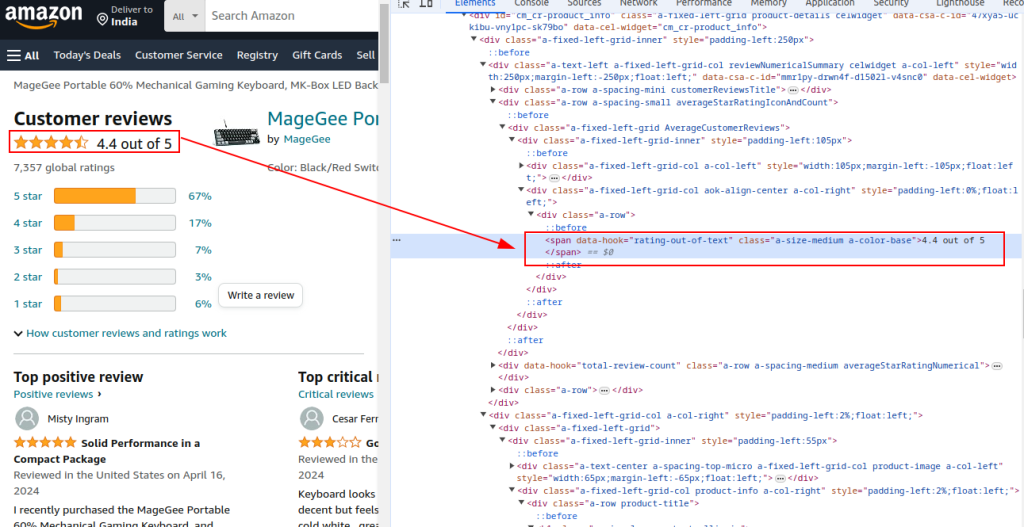

Łączna ocena:

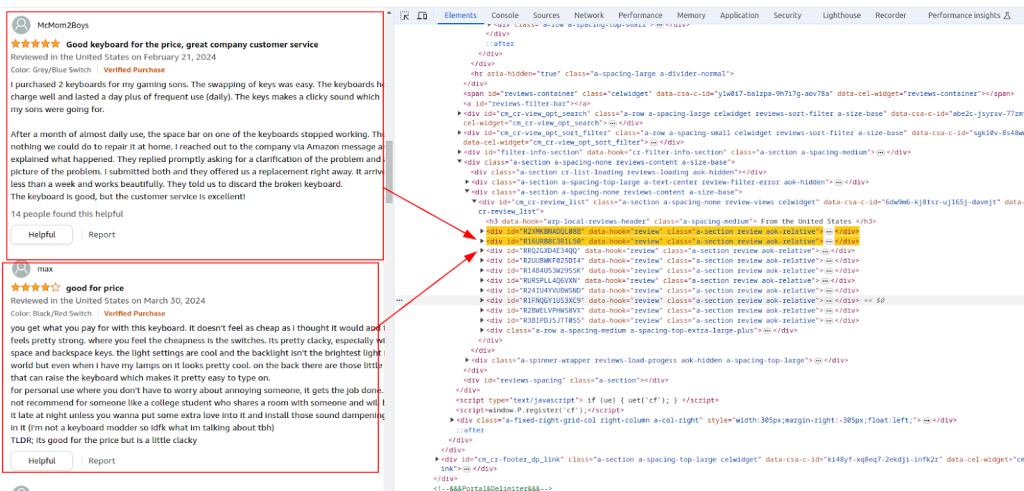

Sekcja recenzji:

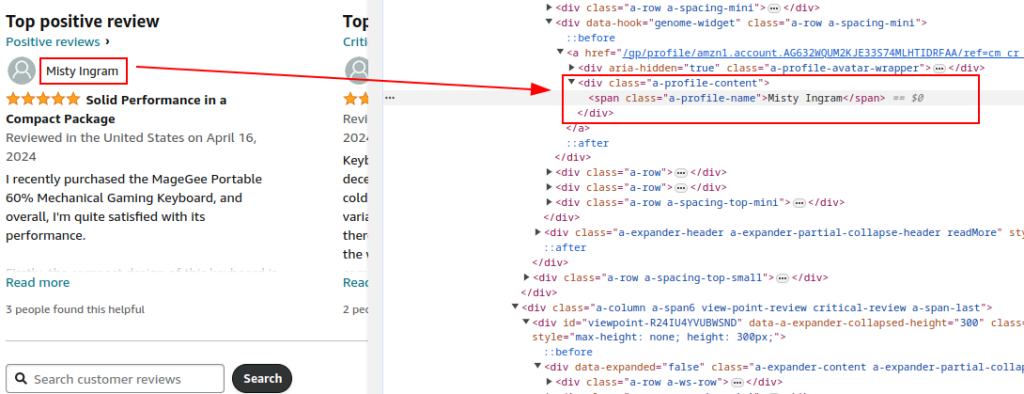

Nazwa autora:

Ocena:

Komentarz:

Użyj biblioteki Requests do wysyłania żądań HTTP GET do strony z recenzjami produktów Amazon. Skonfiguruj nagłówki, aby naśladować legalne zachowanie przeglądarki i uniknąć wykrycia. Proxy i pełne nagłówki żądań są niezbędne, aby uniknąć zablokowania przez Amazon.

Korzystanie z serwerów proxy pomaga w rotacji adresów IP w celu uniknięcia zakazów IP i limitów szybkości ze strony Amazon. Ma to kluczowe znaczenie dla skrobania na dużą skalę, aby zachować anonimowość i zapobiec wykryciu. W tym przypadku szczegóły proxy są dostarczane przez usługę proxy.

Uwzględnienie różnych nagłówków, takich jak Accept-Encoding, Accept-Language, Referer, Connection i Upgrade-Insecure-Requests, naśladuje prawidłowe żądanie przeglądarki, zmniejszając ryzyko oznaczenia jako bot.

import requests

url = "https://www.amazon.com/Portable-Mechanical-Keyboard-MageGee-Backlit/product-reviews/B098LG3N6R/ref=cm_cr_dp_d_show_all_btm?ie=UTF8&reviewerType=all_reviews"

# Przykład proxy dostarczonego przez usługę proxy

proxy = {

'http': 'http://your_proxy_ip:your_proxy_port',

'https': 'https://your_proxy_ip:your_proxy_port'

}

headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7',

'accept-language': 'en-US,en;q=0.9',

'cache-control': 'no-cache',

'dnt': '1',

'pragma': 'no-cache',

'sec-ch-ua': '"Not/A)Brand";v="99", "Google Chrome";v="91", "Chromium";v="91"',

'sec-ch-ua-mobile': '?0',

'sec-fetch-dest': 'document',

'sec-fetch-mode': 'navigate',

'sec-fetch-site': 'same-origin',

'sec-fetch-user': '?1',

'upgrade-insecure-requests': '1',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

}

# Wyślij żądanie HTTP GET do adresu URL z nagłówkami i proxy

try:

response = requests.get(url, headers=headers, proxies=proxy, timeout=10)

response.raise_for_status() # Raise an exception for bad response status

except requests.exceptions.RequestException as e:

print(f"Error: {e}")

Przeanalizuj zawartość HTML odpowiedzi za pomocą BeautifulSoup, aby wyodrębnić typowe szczegóły produktu, takie jak adres URL, tytuł i łączna ocena.

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.content, 'html.parser')

# Wyodrębnianie typowych szczegółów produktu

product_url = soup.find('a', {'data-hook': 'product-link'}).get('href', '')

product_title = soup.find('a', {'data-hook': 'product-link'}).get_text(strip=True)

total_rating = soup.find('span', {'data-hook': 'rating-out-of-text'}).get_text(strip=True)

Kontynuuj analizowanie zawartości HTML w celu wyodrębnienia nazw recenzentów, ocen i komentarzy na podstawie zidentyfikowanych wyrażeń XPath.

reviews = []

review_elements = soup.find_all('div', {'data-hook': 'review'})

for review in review_elements:

author_name = review.find('span', class_='a-profile-name').get_text(strip=True)

rating_given = review.find('i', class_='review-rating').get_text(strip=True)

comment = review.find('span', class_='review-text').get_text(strip=True)

reviews.append({

'Product URL': product_url,

'Product Title': product_title,

'Total Rating': total_rating,

'Author': author_name,

'Rating': rating_given,

'Comment': comment,

})

Użyj wbudowanego modułu CSV Pythona, aby zapisać wyodrębnione dane do pliku CSV w celu dalszej analizy.

import csv

# Definiowanie ścieżki pliku CSV

csv_file = 'amazon_reviews.csv'

# Definiowanie nazw pól CSV

fieldnames = ['Product URL', 'Product Title', 'Total Rating', 'Author', 'Rating', 'Comment']

# Zapisywanie danych do pliku CSV

with open(csv_file, mode='w', newline='', encoding='utf-8') as file:

writer = csv.DictWriter(file, fieldnames=fieldnames)

writer.writeheader()

for review in reviews:

writer.writerow(review)

print(f"Data saved to {csv_file}")

Oto kompletny kod do pobierania danych z recenzji Amazon i zapisywania ich do pliku CSV:

import requests

from bs4 import BeautifulSoup

import csv

import urllib3

urllib3.disable_warnings()

# Adres URL strony z recenzjami produktów Amazon

url = "https://www.amazon.com/Portable-Mechanical-Keyboard-MageGee-Backlit/product-reviews/B098LG3N6R/ref=cm_cr_dp_d_show_all_btm?ie=UTF8&reviewerType=all_reviews"

# Serwer proxy dostarczony przez usługę proxy z autoryzacją IP

path_proxy = 'your_proxy_ip:your_proxy_port'

proxy = {

'http': f'http://{path_proxy}',

'https': f'https://{path_proxy}'

}

# Nagłówki dla żądania HTTP

headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7',

'accept-language': 'en-US,en;q=0.9',

'cache-control': 'no-cache',

'dnt': '1',

'pragma': 'no-cache',

'sec-ch-ua': '"Not/A)Brand";v="99", "Google Chrome";v="91", "Chromium";v="91"',

'sec-ch-ua-mobile': '?0',

'sec-fetch-dest': 'document',

'sec-fetch-mode': 'navigate',

'sec-fetch-site': 'same-origin',

'sec-fetch-user': '?1',

'upgrade-insecure-requests': '1',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

}

# Wysyłanie żądania HTTP GET do adresu URL z nagłówkami i obsługa wyjątków

try:

response = requests.get(url, headers=headers, timeout=10, proxies=proxy, verify=False)

response.raise_for_status() # Raise an exception for bad response status

except requests.exceptions.RequestException as e:

print(f"Error: {e}")

# Parsowanie zawartości HTML przy użyciu BeautifulSoup

soup = BeautifulSoup(response.content, 'html.parser')

# Wyodrębnianie typowych szczegółów produktu

product_url = soup.find('a', {'data-hook': 'product-link'}).get('href', '') # Extract product URL

product_title = soup.find('a', {'data-hook': 'product-link'}).get_text(strip=True) # Extract product title

total_rating = soup.find('span', {'data-hook': 'rating-out-of-text'}).get_text(strip=True) # Extract total rating

# Wyodrębnianie poszczególnych recenzji

reviews = []

review_elements = soup.find_all('div', {'data-hook': 'review'})

for review in review_elements:

author_name = review.find('span', class_='a-profile-name').get_text(strip=True) # Extract author name

rating_given = review.find('i', class_='review-rating').get_text(strip=True) # Extract rating given

comment = review.find('span', class_='review-text').get_text(strip=True) # Extract review comment

# Przechowuj każdą recenzję w słowniku

reviews.append({

'Product URL': product_url,

'Product Title': product_title,

'Total Rating': total_rating,

'Author': author_name,

'Rating': rating_given,

'Comment': comment,

})

# Definiowanie ścieżki pliku CSV

csv_file = 'amazon_reviews.csv'

# Definiowanie nazw pól CSV

fieldnames = ['Product URL', 'Product Title', 'Total Rating', 'Author', 'Rating', 'Comment']

# Zapisywanie danych do pliku CSV

with open(csv_file, mode='w', newline='', encoding='utf-8') as file:

writer = csv.DictWriter(file, fieldnames=fieldnames)

writer.writeheader()

for review in reviews:

writer.writerow(review)

# Drukuj wiadomość z potwierdzeniem

print(f"Data saved to {csv_file}")

Podsumowując, należy podkreślić, że wybór niezawodnych serwerów proxy jest kluczowym krokiem w pisaniu skryptów do skrobania stron internetowych. Zapewnia to skuteczne omijanie blokad i ochronę przed filtrami antybotowymi. Najbardziej odpowiednimi opcjami do skrobania są rezydencjalne serwery proxy, które oferują wysoki współczynnik zaufania i dynamiczne adresy IP, wraz ze statycznymi serwerami proxy ISP, które zapewniają wysoką prędkość i stabilność operacyjną.

Komentarze: 0