pl

pl  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia Scrapy to solidny, wysokopoziomowy framework przeznaczony do skrobania stron internetowych i ekstrakcji danych, dzięki czemu idealnie nadaje się do zadań takich jak analizowanie danych, monitorowanie cen, analiza zachowań użytkowników, wgląd w media społecznościowe i analiza SEO. Framework ten jest przystosowany do wydajnej obsługi dużych ilości danych. Zawiera wbudowane mechanizmy zarządzania żądaniami HTTP, obsługi błędów i zapewniania zgodności z robots.txt, które są niezbędne do poruszania się po złożonych i zakrojonych na szeroką skalę projektach gromadzenia danych internetowych. Niniejsza recenzja zagłębia się w to, czym jest Scrapy, jak działa i jakie funkcje oferuje użytkownikom, zapewniając kompleksowe zrozumienie jego możliwości i zastosowań.

Framework Scrapy to potężne narzędzie do skrobania stron internetowych o otwartym kodzie źródłowym napisane w języku Python, zaprojektowane do wysokowydajnego indeksowania i wyodrębniania ustrukturyzowanych danych ze stron internetowych. Może organizować wyodrębnione dane do formatów JSON i CSV lub bezpośrednio przechowywać je w bazach danych, takich jak SQLite, MySQL, PostgreSQL i MongoDB. Scrapy obsługuje różne metody parsowania, w tym selektory CSS i XPath, i może obsługiwać odpowiedzi JSON i XML, co ma kluczowe znaczenie w przypadku interfejsów API.

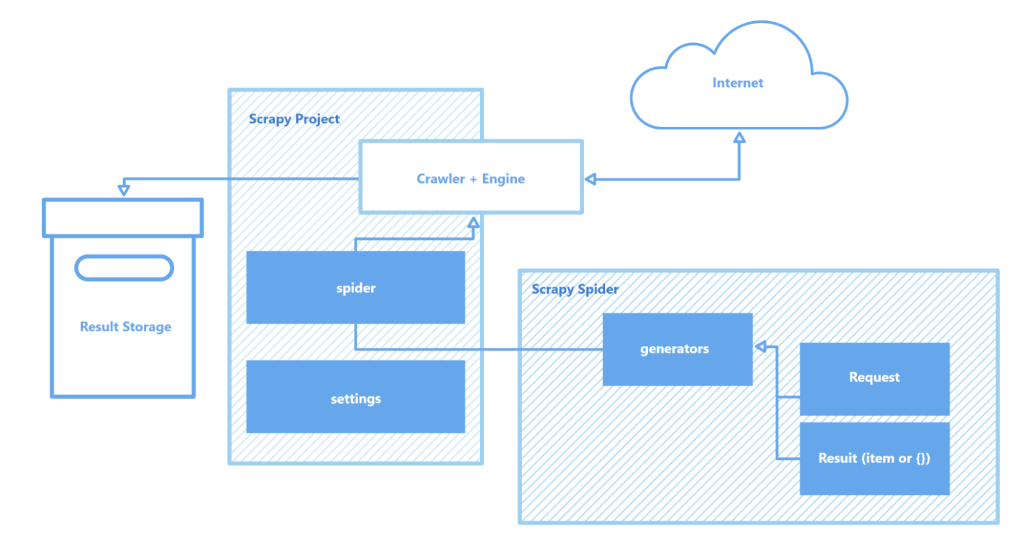

Scrapy działa za pośrednictwem "spiders" - wyspecjalizowanych robotów indeksujących, które wykonują określone instrukcje, aby poruszać się po stronach internetowych i zbierać dane. Pająki te są zasadniczo skryptami, które identyfikują i przechwytują określone typy obiektów, takie jak tekst, obrazy lub linki. Interaktywna powłoka crawlingu dostarczana przez Scrapy pozwala na testowanie i debugowanie tych pająków w czasie rzeczywistym, znacznie usprawniając proces konfiguracji i optymalizacji crawlera.

Kluczowe komponenty architektury Scrapy obejmują:

Ogólnie rzecz biorąc, Scrapy wyróżnia się jako jedno z najbardziej solidnych i elastycznych dostępnych narzędzi do skrobania stron internetowych, odpowiednie do wszystkiego, od prostych zadań ekstrakcji danych po złożone projekty eksploracji sieci na dużą skalę.

Ta sekcja podkreśla kluczowe cechy frameworka Scrapy: szybkość gromadzenia i przetwarzania danych, możliwość rozszerzania funkcjonalności i przenośność. Atrybuty te odróżniają Scrapy od konkurencji i sprawiają, że jest to popularny wybór na arenie skrobania stron internetowych.

Scrapy jest zasilany przez Twisted, asynchroniczny silnik sieciowy o otwartym kodzie źródłowym. W przeciwieństwie do operacji synchronicznych, w których jedno zadanie musi zostać ukończone przed rozpoczęciem kolejnego, Twisted pozwala na równoległe wykonywanie zadań. Oznacza to, że pająki Scrapy mogą wysyłać wiele żądań i przetwarzać odpowiedzi jednocześnie, zwiększając szybkość i wydajność gromadzenia danych, szczególnie w przypadku projektów na dużą skalę lub podczas skanowania wielu witryn jednocześnie.

Szybkość Scrapy jest dodatkowo zwiększana przez kilka czynników:

Wszystkie te funkcje sprawiają, że Scrapy jest jednym z najszybszych dostępnych narzędzi do wydajnego skrobania i gromadzenia danych z wielu stron internetowych, co czyni go nieocenionym źródłem do zadań takich jak monitorowanie cen produktów, ofert pracy, gromadzenie wiadomości, analiza mediów społecznościowych i badania naukowe.

Modułowa architektura Scrapy zwiększa jej możliwości adaptacyjne i rozszerzalność, dzięki czemu dobrze nadaje się do różnych złożonych zadań gromadzenia danych. Obsługa integracji z różnymi magazynami danych, takimi jak MongoDB, PostgreSQL i Elasticsearch, a także systemami zarządzania kolejkami, takimi jak Redis i RabbitMQ, pozwala na efektywną obsługę dużych ilości danych. Ponadto Scrapy może integrować się z platformami monitorowania lub rejestrowania, takimi jak Prometheus lub Logstash, umożliwiając skalowalne i konfigurowalne konfiguracje skrobaków dla projektów, od gromadzenia danych uczenia maszynowego po rozwój wyszukiwarek.

Rozszerzalne komponenty architektury Scrapy:

Co więcej, zdolność Scrapy do obsługi niestandardowych modułów do interakcji API zapewnia solidne ramy do skalowania i dostosowywania rozwiązań w celu spełnienia wymagań przetwarzania danych na dużą skalę i złożonych wymagań projektowych.

Kolejną istotną zaletą Scrapy jest jego przenośność. Framework obsługuje wiele systemów operacyjnych, w tym Windows, macOS i Linux, dzięki czemu jest wszechstronny w użyciu w różnych środowiskach programistycznych. Instalacja jest prosta przy użyciu menedżera pakietów Python (pip), a dzięki modułowej strukturze i elastycznej konfiguracji Scrapy, projekty mogą być łatwo przenoszone między maszynami bez znaczących zmian.

Co więcej, Scrapy obsługuje środowiska wirtualne, które izolują zależności projektu i pozwalają uniknąć konfliktów z innymi zainstalowanymi pakietami. Ta funkcja jest szczególnie cenna podczas pracy nad wieloma projektami jednocześnie lub podczas wdrażania aplikacji na serwerze, zapewniając czyste i stabilne środowisko programistyczne.

W celu bardziej efektywnej pracy ze Scrapy zaleca się korzystanie z edytora kodu, takiego jak Visual Studio Code (VS Code) lub jego odpowiedników, ponieważ interakcja z frameworkiem odbywa się za pośrednictwem wiersza poleceń (CLI). Pozwala to na bardziej efektywne zarządzanie projektami, skanowanie witryn i konfigurowanie pająków. Dodatkowo, wykorzystanie środowisk wirtualnych do zarządzania zależnościami może pomóc uniknąć konfliktów między bibliotekami i wersjami pakietów, zapewniając płynniejszy przepływ pracy.

Tworzenie i uruchamianie projektu w Scrapy obejmuje szereg prostych kroków:

pip install scrapy

scrapy startproject myproject

myproject/

scrapy.cfg # Ustawienia projektu

myproject/

__init__.py

items.py # Definicje modelu danych

middlewares.py # Oprogramowanie pośredniczące

pipelines.py # Przetwarzanie danych

settings.py # Ustawienia Scrapy

spiders/ # Folder pająków

__init__.py

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

scrapy crawl quotes

Tutaj "quotes" jest nazwą pająka zdefiniowanego w klasie QuotesSpider. Scrapy wykona pająka, aby przeszukać określony adres URL i wyodrębnić dane zgodnie ze zdefiniowanymi ustawieniami.

scrapy crawl quotes -o quotes.json

Scrapy to solidny, darmowy framework do skrobania stron internetowych, zaprojektowany w celu zapewnienia programistom kompleksowych narzędzi do automatycznego wyodrębniania i przetwarzania danych ze stron internetowych. Jego asynchroniczna architektura i modułowa struktura zapewniają dużą szybkość i doskonałą skalowalność, ułatwiając rozszerzanie funkcjonalności w razie potrzeby. Dodatkowo, bezproblemowa integracja Scrapy z różnymi bibliotekami i rozwiązaniami do przechowywania danych, wraz z obsługą niestandardowych protokołów, upraszcza dostosowanie crawlera do konkretnych wymagań projektu. Sprawia to, że proces skrobania stron internetowych jest nie tylko bardziej wydajny, ale także bardziej elastyczny i przyjazny dla użytkownika.

Komentarze: 0