de

de  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  اردو

اردو  Indonesia

Indonesia  Polski

Polski Helium Scraper ist ein fortschrittliches Web-Scraping-Tool, das auf die Automatisierung des Prozesses der Datenextraktion aus Websites zugeschnitten ist.

Dieses Tool wird im E-Commerce häufig zur Überwachung von Produktpreisen und -verfügbarkeit eingesetzt und ermöglicht es Unternehmen, ihre Wettbewerber zu analysieren und ihre Preisstrategien zu optimieren. Darüber hinaus dient es als wertvolle Ressource in der Marketingforschung, indem es Daten über Kundenrezensionen und -präferenzen sammelt, was zu einem umfassenden Verständnis der Marktdynamik und des Verbraucherverhaltens beiträgt. Helium Scraper spielt auch eine entscheidende Rolle im Reputationsmanagement, indem es die Verfolgung von Unternehmens- oder Produkterwähnungen im Internet automatisiert und zeitnahe Reaktionen auf öffentliches Feedback erleichtert.

Helium Scraper ist mit mehreren einzigartigen Funktionen ausgestattet, die sowohl die Ersteinrichtung als auch den Scraping-Prozess rationalisieren. Eines seiner herausragenden Merkmale ist die visuelle Schnittstelle, die es den Nutzern ermöglicht, Daten zu extrahieren, ohne dass sie programmieren müssen. Damit ist das Tool auch für Nutzer ohne umfassende technische Kenntnisse oder Programmierfähigkeiten leicht zugänglich.

Helium Scraper enthält integrierte Projektvorlagen, die den Start neuer Scraping-Projekte vereinfachen. Diese Vorlagen sind vorkonfiguriert, um bestimmte Datentypen wie Produktdetails, Preise, Bewertungen und Kontaktinformationen von verschiedenen Online-Plattformen und Social-Media-Seiten zu erfassen.

Nutzer können auf eine große Auswahl an Vorlagen zugreifen, indem sie das offizielle Helium Scraper Forum besuchen. Dieses Forum enthält Vorlagen, die sowohl von den Entwicklern von Helium Scraper als auch von der Nutzergemeinschaft erstellt wurden. Nach dem Herunterladen einer Vorlage kann diese leicht an die spezifischen Anforderungen eines Projekts angepasst werden. Diese Funktion verkürzt nicht nur die Einrichtungszeit, sondern beschleunigt auch den Datenerfassungsprozess.

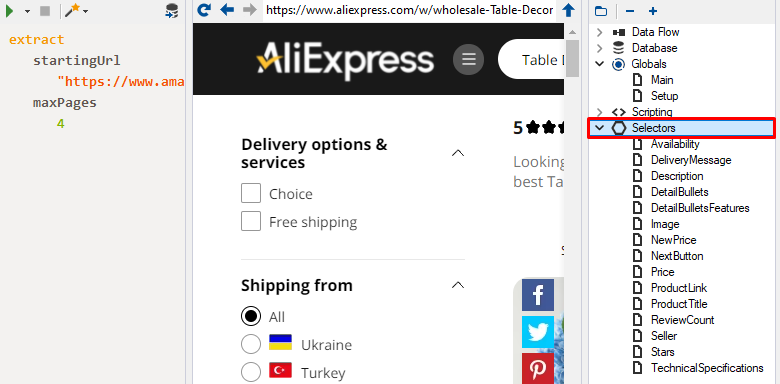

Helium Scraper verfügt über fortschrittliche Datenselektoren, die seine Fähigkeit verbessern, Elemente auf Webseiten präzise zu identifizieren und auszuwählen. Diese Selektoren sind in hohem Maße anpassbar, so dass sie sich an die dynamischen Umgebungen moderner Webanwendungen anpassen können, in denen sich Element-IDs und Klassen häufig ändern können. Diese Anpassungsfähigkeit ist entscheidend für das effektive Scraping von Daten aus modernen, interaktiven Websites, bei denen herkömmliche Scraping-Methoden möglicherweise nicht ausreichen.

Die fortschrittlichen Selektoren in Helium Scraper ermöglichen die Erstellung komplexer Selektionsregeln, die es den Benutzern ermöglichen, den Datenerfassungsprozess auf spezifische Genauigkeitsanforderungen zuzuschneiden. Durch die Verwendung hochentwickelter Algorithmen zur Mustererkennung und prädiktiver Logik stellen diese Selektoren sicher, dass nur relevante und genaue Informationen erfasst werden, wodurch die Wahrscheinlichkeit der Erfassung irrelevanter Daten oder Fehler verringert wird.

Die Integration von SQL-ähnlichen Abfragen in Helium Scraper erweitert seine Funktionalität, indem es den Benutzern ermöglicht, komplexe Datenverarbeitungsvorgänge direkt während des Scraping-Prozesses durchzuführen. Diese Funktion zeichnet sich dadurch aus, dass sie nicht nur das Filtern und Sortieren von Daten ermöglicht, sondern auch deren Aggregation unmittelbar nach der Extraktion. Diese Funktionen rationalisieren die Vorbereitung der Daten für die Analyse und den Export und reduzieren die Notwendigkeit von Nachbearbeitungsschritten erheblich.

Benutzer können anspruchsvolle Abfragen erstellen, um detaillierte Berichte zu generieren, Markttrends zu analysieren oder Daten für nachfolgende Geschäftsprozesse vorzubereiten. Diese Funktionalität bietet ein tiefes Verständnis der gesammelten Daten und erleichtert schnelle Strategieanpassungen als Reaktion auf sich verändernde Marktbedingungen. Die Einbeziehung von SQL-ähnlichen Abfragefunktionen verwandelt Helium Scraper von einem reinen Datenerfassungswerkzeug in eine robuste Plattform für die analytische Verarbeitung.

Helium Scraper unterscheidet sich von anderen Tools dadurch, dass der Preis in Form einer einmaligen Zahlung angeboten wird, die einen unbefristeten Zugang zu den Funktionen ermöglicht. Es ist wichtig zu erwähnen, dass alle Funktionen in jeder Abonnementstufe verfügbar sind, mit Unterschieden nur in der Anzahl der gleichzeitig erlaubten Nutzer und dem Umfang des Online-Supports. Außerdem haben die Nutzer die Möglichkeit, das Tool mit einer 10-tägigen Testversion zu testen. Im Folgenden werden wir die verschiedenen verfügbaren Tarife und ihre spezifischen Funktionen näher erläutern.

Dieser Tarif ist ideal für Einzelanwender und bietet vollen Zugriff auf alle Scraper-Funktionen. Es beinhaltet drei Monate lang globale Updates sowie unbegrenzte Routine-Updates. Mit einem Preis von 99$ ist es eine kosteneffiziente Option für alle, die neu anfangen oder kleinere Projekte verwalten.

Dieser Plan ist für bis zu zwei Benutzer konzipiert und umfasst einen Monat Premium-Support und sechs Monate globale Updates. Es eignet sich für Fachleute, die einen umfangreicheren Support und einen längeren Update-Zugang wünschen, mit einer einmaligen Gebühr von 199$.

Dieser Plan richtet sich an kleine Teams und ermöglicht es bis zu fünf Mitarbeitern, den Scraper zu nutzen. Es bietet drei Monate Premium-Support und ein Jahresabonnement für wichtige Updates und ist damit ideal für gemeinsame Projekte in Unternehmen. Dieser Plan ist für 399$ erhältlich.

Die umfassendste Option ist für Großprojekte und bis zu zehn Teammitglieder gedacht. Dieser Plan bietet sechs Monate Premium-Online-Support und zwei Jahre lang Zugang zu wichtigen Updates und richtet sich an Unternehmen mit umfangreichen Anforderungen an das Data Scraping. Der Preis für das Abonnement beträgt 699 $.

| Zolltarif | Basic | Professional | Business | Enterprise |

|---|---|---|---|---|

| Preis | $99 | $199 | $399 | $699 |

| Zugang zu allen Scraper-Funktionen | Ja | Ja | Ja | Ja |

| Anzahl der Nutzer | 1 | 2 | 5 | 10 |

| Premium-Unterstützung | Nein | 1 Monat | 3 Monate | 6 Monate |

| Unbegrenzte Anzahl von Basis-Updates | Ja | Ja | Ja | Ja |

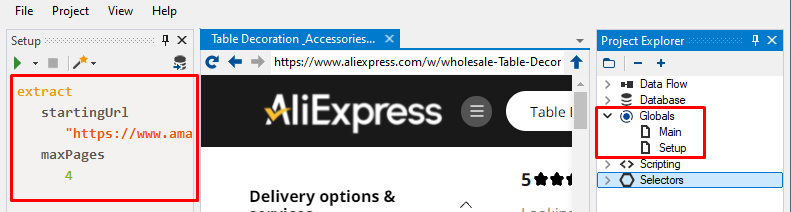

Die Benutzeroberfläche von Helium Scraper ist so gestaltet, dass sie dem Benutzer Bequemlichkeit und Effizienz bietet, mit einem geradlinigen visuellen Design ohne unnötige Elemente. Im Folgenden werden wir alle wichtigen Registerkarten und Optionen im Detail erkunden, die eine nahtlose Navigation und Bedienung ermöglichen.

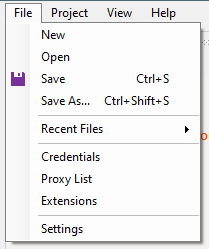

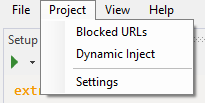

Auf dieser Registerkarte können Benutzer ein neues Projekt erstellen, ein bestehendes Projekt hochladen und Projekte nach Bedarf speichern. Zusätzliche Optionen umfassen:

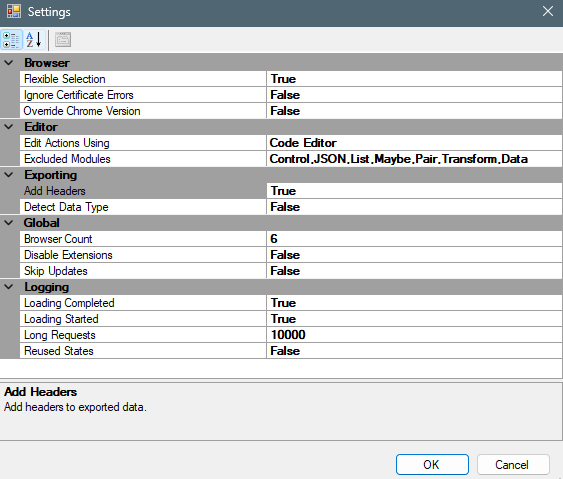

Außerdem können die Benutzer im Abschnitt "Einstellungen" globale Parser-Einstellungen vornehmen, um den Scraping-Prozess an ihre Bedürfnisse anzupassen.

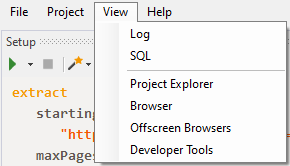

Die nächste Registerkarte ist in zwei Hauptoptionen unterteilt:

Zusätzliche Werkzeuge sind enthalten, um die Transparenz und Handhabbarkeit des Scraping-Prozesses zu verbessern:

Als Nächstes werden wir das Hauptarbeitsfenster und seine verschiedenen Funktionen im Detail betrachten.

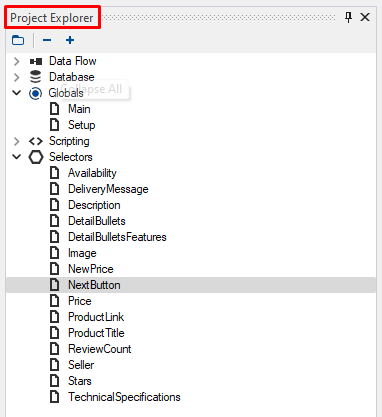

Das Hauptarbeitsfenster, das sich auf der rechten Seite des Bildschirms befindet, dient als zentraler Knotenpunkt für die Verwaltung aller Aspekte von Scraping-Projekten. Hier können Benutzer durch ihre Projekte navigieren, die Struktur der gesammelten Daten einsehen und auf verfügbare Skripte zugreifen. Um dieses Menü nutzen zu können, muss der Benutzer beim Starten des Programms zunächst ein Projekt erstellen.

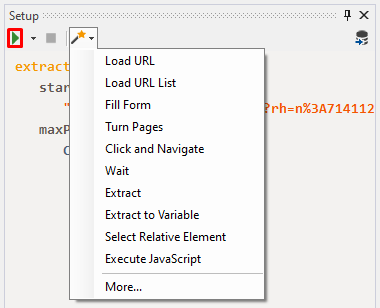

Auf der linken Seite des Bildschirms kann der Benutzer das Parsing-Skript konfigurieren und seine Struktur beobachten. In diesem Bereich kann das Skript auch gestartet oder gestoppt werden. Durch Klicken auf das im Screenshot dargestellte Symbol können die Benutzer ein Menü öffnen, das zusätzliche Projektoptionen bietet.

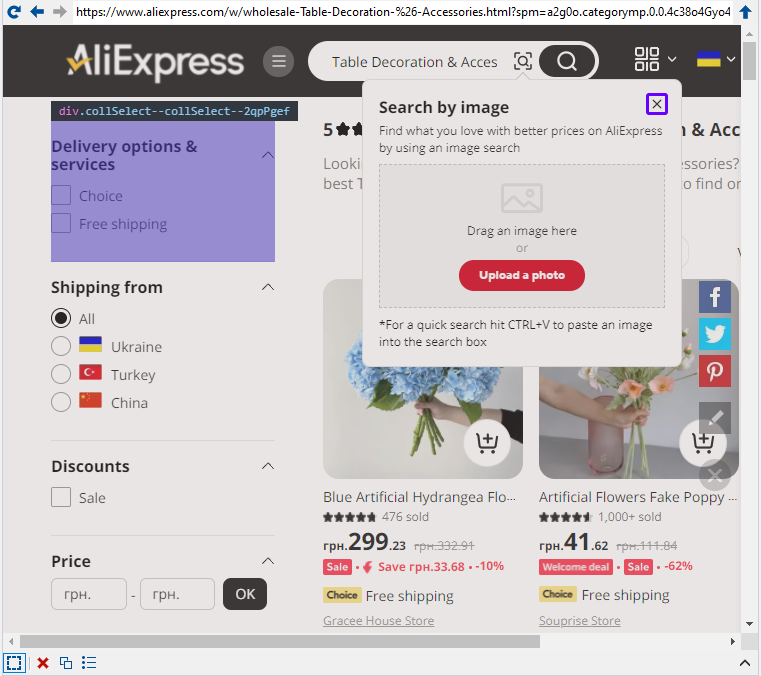

In der Mitte des Bildschirms befindet sich ein Browser-Fenster, das eine bessere Kontrolle über den Scraping-Prozess durch die visuelle Schnittstelle der zu scannenden Seite bietet.

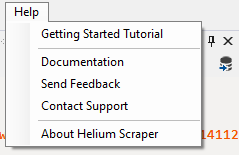

Die Registerkarte "Hilfe" in Helium Scraper bietet wichtige Ressourcen für Schulung und Support. Sie enthält ein "Getting Started Tutorial" für neue Benutzer, eine umfassende "Dokumentation" mit detaillierten Anleitungen und hilfreichen Informationen, eine Option, um "Feedback" an die Entwickler zu senden, eine "Contact Support"-Funktion, um technische Probleme anzusprechen, und einen "About Helium Scraper"-Abschnitt, der Versionsinformationen und Copyright-Details enthält.

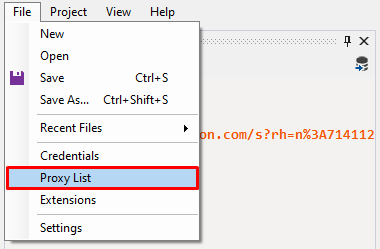

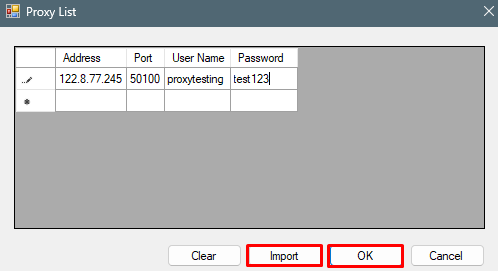

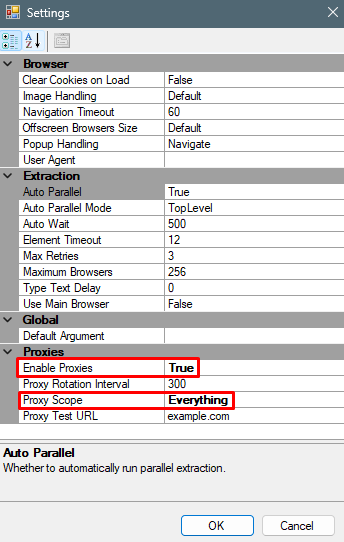

Die Einrichtung eines Proxys in Helium Scraper ist entscheidend für die Anonymisierung von Aktivitäten und die Umgehung von Beschränkungen, die von Webseiten auferlegt werden. Die Verwendung eines Proxys hilft dabei, IP-Blockierungen bei häufigen Anfragen an die gleiche Ressource zu verhindern, die Last zu verteilen, um die Leistung zu verbessern, und den Zugriff auf regional beschränkte Inhalte zu ermöglichen. Um einen Proxyserver in Helium Scraper zu integrieren, folgen Sie diesen Schritten:

Diese Einstellung stellt sicher, dass der Proxyserver in allen laufenden Browsern funktioniert. Für kompliziertere Konfigurationen wie Proxy-Rotation konsultieren Sie bitte die Dokumentation auf der offiziellen Website. Insbesondere die Verwendung von Proxyservern für das Web-Scraping kann die Effizienz Ihrer Scraping-Aktivitäten erheblich steigern, da sie einen hohen Vertrauensfaktor und eine große Auswahl an Geolokationen bietet, was für komplexe Aufgaben unerlässlich ist.

Helium Scraper ist ein leistungsfähiges Werkzeug zur Verbesserung von Datenerfassungs- und Analyseprozessen. Seine visuelle Schnittstelle und die Fähigkeit, SQL-ähnliche Abfragen zu verwenden, ermöglichen es den Nutzern, die Überwachung der Websites von Wettbewerbern zu automatisieren, Preisänderungen und Produktverfügbarkeit zu analysieren und Markenerwähnungen online zu verfolgen.

Bemerkungen: 0