ur

ur  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  Indonesia

Indonesia  Polski

Polski Scrapy ایک مضبوط اور اعلیٰ سطح کا فریم ورک ہے جو ویب اسکریپنگ اور ڈیٹا نکالنے کے لیے ڈیزائن کیا گیا ہے، جو اسے ڈیٹا پارسنگ، قیمتوں کی نگرانی، صارف کے رویے کے تجزیے، سوشل میڈیا بصیرت، اور SEO تجزیے جیسے کاموں کے لیے مثالی بناتا ہے۔ یہ فریم ورک بڑی مقدار میں ڈیٹا کو مؤثر طریقے سے سنبھالنے کے لیے لیس ہے۔ اس میں HTTP درخواستوں کا انتظام، خرابیوں کا ازالہ، اور robots.txt کی تعمیل کو یقینی بنانے کے لیے بلٹ ان میکانزم شامل ہیں، جو پیچیدہ اور بڑے پیمانے پر ویب ڈیٹا جمع کرنے کے منصوبوں کو نیویگیٹ کرنے کے لیے ضروری ہیں۔ یہ جائزہ Scrapy کیا ہے، یہ کیسے کام کرتا ہے، اور یہ صارفین کو کیا خصوصیات پیش کرتا ہے، اس پر غور کرے گا، اس کی صلاحیتوں اور اطلاقات کی جامع تفہیم فراہم کرے گا۔

Scrapy فریم ورک ایک طاقتور اوپن سورس ویب اسکریپنگ ٹول ہے جو Python میں لکھا گیا ہے، جو ویب سائٹس سے منظم ڈیٹا کو نکالنے اور اعلیٰ کارکردگی کے ساتھ کرالنگ کے لیے ڈیزائن کیا گیا ہے۔ یہ نکالا گیا ڈیٹا JSON اور CSV فارمیٹس میں منظم کر سکتا ہے یا اسے براہ راست SQLite، MySQL، PostgreSQL، اور MongoDB جیسے ڈیٹا بیس میں محفوظ کر سکتا ہے۔ Scrapy مختلف پارسنگ طریقوں کی حمایت کرتا ہے جن میں CSS سلیکٹرز اور XPath شامل ہیں اور یہ JSON اور XML جوابات کو سنبھال سکتا ہے، جو APIs کے ساتھ کام کرتے وقت اہم ہے۔

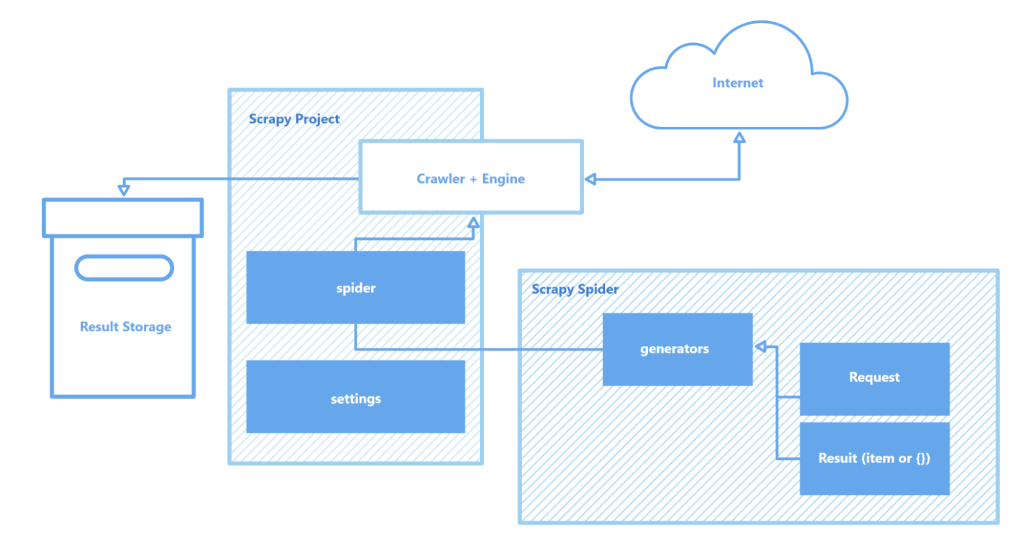

Scrapy "spiders" کے ذریعے کام کرتا ہے – خصوصی کرالرز جو ویب صفحات کو نیویگیٹ کرنے اور ڈیٹا حاصل کرنے کے لیے متعین ہدایات پر عمل کرتے ہیں۔ یہ اسپائڈرز بنیادی طور پر اسکرپٹس ہوتے ہیں جو متن، تصاویر، یا لنکس جیسے مخصوص اقسام کے آبجیکٹس کی شناخت اور گرفت کرتے ہیں۔ Scrapy کی طرف سے فراہم کردہ ایک انٹرایکٹو کرالنگ شیل ان اسپائڈرز کی حقیقی وقت میں جانچ اور خرابیوں کا ازالہ کرنے کی اجازت دیتا ہے، جو کرالر کے سیٹ اپ اور اصلاح کے عمل کو بہت بہتر بناتا ہے۔

Scrapy کی فن تعمیر کے کلیدی اجزاء میں شامل ہیں:

مجموعی طور پر، Scrapy دستیاب سب سے مضبوط اور لچکدار ویب اسکریپنگ ٹولز میں سے ایک کے طور پر نمایاں ہے، جو سادہ ڈیٹا نکالنے کے کاموں سے لے کر پیچیدہ بڑے پیمانے پر ویب مائننگ منصوبوں تک ہر چیز کے لیے موزوں ہے۔

یہ سیکشن Scrapy فریم ورک کی کلیدی خصوصیات کو اجاگر کرتا ہے: ڈیٹا جمع کرنے اور پروسیسنگ میں اس کی رفتار، فعالیت کو بڑھانے کی صلاحیت، اور پورٹیبلٹی۔ یہ خصوصیات Scrapy کو اس کے حریفوں سے ممتاز کرتی ہیں اور ویب اسکریپنگ کے میدان میں اسے ایک مقبول انتخاب بناتی ہیں۔

Scrapy Twisted کے ذریعہ تقویت یافتہ ہے، جو ایک غیر متزامن اوپن سورس نیٹ ورک انجن ہے۔ متزامن آپریشنز کے برعکس جہاں ایک کام کو مکمل کرنا ضروری ہوتا ہے اس سے پہلے کہ دوسرا شروع ہو، Twisted متوازی طور پر کاموں کو انجام دینے کی اجازت دیتا ہے۔ اس کا مطلب ہے کہ Scrapy اسپائڈرز متعدد درخواستیں بھیج سکتے ہیں اور جوابات کو بیک وقت پروسیس کر سکتے ہیں، خاص طور پر بڑے پیمانے پر منصوبوں یا متعدد سائٹس کو بیک وقت اسکین کرنے کے لیے رفتار اور کارکردگی کو بڑھاتے ہوئے۔

Scrapy کی رفتار کو کئی عوامل مزید بڑھاتے ہیں:

یہ تمام خصوصیات مل کر Scrapy کو دستیاب تیز ترین ٹولز میں سے ایک بناتی ہیں، جو متعدد ویب سائٹس سے مؤثر طریقے سے ڈیٹا کو سکریپ اور جمع کرنے کے لیے دستیاب ہے، اور اسے مصنوعات کی قیمتوں کی نگرانی، ملازمت کی فہرستوں، خبروں کے حصول، سوشل میڈیا تجزیے، اور تعلیمی تحقیق جیسے کاموں کے لیے انمول وسائل بناتی ہیں۔

Scrapy کی ماڈیولر فن تعمیر اس کی موافقت پذیری اور توسیع پذیری کو بہتر بناتی ہے، جس سے یہ مختلف پیچیدہ ڈیٹا اکٹھا کرنے کے کاموں کے لیے موزوں بنتی ہے۔ یہ MongoDB، PostgreSQL، اور Elasticsearch جیسے مختلف ڈیٹا اسٹورز کے ساتھ انضمام، نیز Redis اور RabbitMQ جیسے قطار کے نظم و نسق کے نظام کی حمایت کرتا ہے، جو بڑی مقدار میں ڈیٹا کو مؤثر طریقے سے سنبھالنے کی اجازت دیتا ہے۔ مزید برآں، Scrapy Prometheus یا Logstash جیسے مانیٹرنگ یا لاگنگ پلیٹ فارمز کے ساتھ انضمام کر سکتا ہے، جس سے مشین لرننگ ڈیٹا اکٹھا کرنے سے لے کر سرچ انجن کی تیاری تک کے منصوبوں کے لیے قابل توسیع اور حسب ضرورت سکریپر کنفیگریشنز ممکن بنتی ہیں۔

Scrapy کی فن تعمیر کے توسیع پذیر اجزاء:

اس کے علاوہ، Scrapy کی API تعاملات کے لیے کسٹم ماڈیولز کی حمایت کی صلاحیت ایک مضبوط فریم ورک مہیا کرتی ہے جو بڑے پیمانے پر ڈیٹا پروسیسنگ اور پیچیدہ منصوبہ جاتی تقاضوں کو پورا کرنے کے لیے اسکیل اور حسب ضرورت حل فراہم کرتا ہے۔

Scrapy کا ایک اور اہم فائدہ اس کی پورٹیبلٹی ہے۔ یہ فریم ورک متعدد آپریٹنگ سسٹمز جیسے Windows، macOS، اور Linux کو سپورٹ کرتا ہے، جو اسے مختلف ترقیاتی ماحول میں استعمال کے لیے ہمہ گیر بناتا ہے۔ انسٹالیشن Python پیکیج مینیجر (pip) کے ذریعے سیدھی سادی ہے، اور Scrapy کی ماڈیولر ساخت اور لچکدار کنفیگریشن کی بدولت، منصوبے مشینوں کے درمیان بغیر بڑی تبدیلیوں کے آسانی سے منتقل کیے جا سکتے ہیں۔

مزید برآں، Scrapy ورچوئل ماحول کی حمایت کرتا ہے، جو منصوبے کی انحصاریوں کو الگ تھلگ کرتا ہے اور دیگر انسٹال شدہ پیکیجز کے ساتھ تصادم سے بچاتا ہے۔ یہ خصوصیت خاص طور پر اس وقت قیمتی ہے جب ایک ساتھ کئی منصوبوں پر کام کیا جا رہا ہو یا جب ایپلی کیشنز کو سرور پر تعینات کیا جا رہا ہو، تاکہ صاف اور مستحکم ترقیاتی ماحول کو یقینی بنایا جا سکے۔

Scrapy کے ساتھ مؤثر کام کے لیے تجویز دی جاتی ہے کہ Visual Studio Code (VS Code) یا اس جیسے کسی کوڈ ایڈیٹر کا استعمال کیا جائے، کیونکہ فریم ورک کے ساتھ تعامل کمانڈ لائن (CLI) کے ذریعے کیا جاتا ہے۔ یہ منصوبوں کا نظم، سائٹس کو اسکین کرنا، اور اسپائڈرز کو کنفیگر کرنا زیادہ مؤثر بناتا ہے۔ نیز، ورچوئل ماحول کا استعمال انحصاریوں کا نظم کرنے میں مدد دیتا ہے تاکہ لائبریریوں اور پیکیج ورژنز کے درمیان تنازعات سے بچا جا سکے، جس سے کام کا بہاؤ ہموار ہوتا ہے۔

Scrapy میں منصوبہ بنانے اور چلانے میں کچھ سادہ اقدامات شامل ہوتے ہیں:

1.سب سے پہلے، اس بات کو یقینی بنائیں کہ Scrapy انسٹال ہے، اس کے لیے درج ذیل کمانڈ ٹرمینل میں چلائیں:

pip install scrapy

2.Scrapy انسٹال ہونے کے بعد، اپنے منصوبے کے لیے ایک نیا ڈائریکٹری بنائیں اور اس میں داخل ہوں۔ نیچے دی گئی کمانڈ سے اپنا نیا منصوبہ شروع کریں۔ فرض کریں آپ اپنے منصوبے کا نام “myproject” رکھ رہے ہیں

scrapy startproject myproject

3.یہ کمانڈ آپ کے منصوبے کے لیے ایک معیاری ڈائریکٹری ڈھانچہ تیار کرتی ہے جیسا کہ نیچے ہے

myproject/

scrapy.cfg # Project settings

myproject/

__init__.py

items.py # Data model definitions

middlewares.py # Middlewares

pipelines.py # Data processing

settings.py # Scrapy settings

spiders/ # Spiders folder

__init__.py

4.اس کے بعد، اسپائڈر بنانے کے لیے "spiders" فولڈر میں جائیں اور ایک نئی فائل بنائیں، جیسے "quotes_spider.py"، اور اسے درج ذیل بنیادی کوڈ سے بھریں تاکہ اقوال کو سکریپ کیا جا سکے:

import scrapy

class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = ['http://quotes.toscrape.com/']

def parse(self, response):

for quote in response.css('div.quote'):

yield {

'text': quote.css('span.text::text').get(),

'author': quote.css('span small::text').get(),

}

5.اسپائڈر کو چلانے اور کرالنگ شروع کرنے کے لیے کمانڈ درج کریں:

scrapy crawl quotes

یہاں "quotes" وہ نام ہے جو QuotesSpider کلاس میں اسپائڈر کے لیے مقرر کیا گیا ہے۔ Scrapy مخصوص URL پر اسپائڈر چلائے گا اور آپ کی متعین کردہ ترتیبات کے مطابق ڈیٹا نکالے گا۔

6.اگر آپ نکالا گیا ڈیٹا محفوظ کرنا چاہتے ہیں، مثال کے طور پر ایک JSON فائل میں، تو آپ -o پیرامیٹر کے ساتھ آؤٹ پٹ فائل کی وضاحت کر سکتے ہیں جیسے:

scrapy crawl quotes -o quotes.json

Scrapy ایک طاقتور، مفت ویب اسکریپنگ فریم ورک ہے جو ڈویلپرز کو ویب صفحات سے خودکار ڈیٹا نکالنے اور پروسیسنگ کے لیے جامع ٹولز فراہم کرتا ہے۔ اس کا غیر متزامن فن تعمیر اور ماڈیولر ساخت اعلیٰ رفتار اور شاندار توسیع پذیری کو یقینی بناتے ہیں، جو حسب ضرورت فعالیت کی توسیع کو آسان بناتا ہے۔ اس کے علاوہ، Scrapy کی مختلف لائبریریوں اور ڈیٹا اسٹوریج حل کے ساتھ بغیر رکاوٹ کے انضمام، نیز کسٹم پروٹوکولز کی حمایت، سکریپر کی تخصیص کو سادہ بناتا ہے تاکہ وہ مخصوص منصوبے کی ضروریات کو پورا کر سکے۔ یہ ویب اسکریپنگ کے عمل کو نہ صرف زیادہ مؤثر بناتا ہے بلکہ زیادہ لچکدار اور صارف دوست بھی۔

تبصرے: 0