ur

ur  English

English  Español

Español  中國人

中國人  Tiếng Việt

Tiếng Việt  Deutsch

Deutsch  Українська

Українська  Português

Português  Français

Français  भारतीय

भारतीय  Türkçe

Türkçe  한국인

한국인  Italiano

Italiano  Gaeilge

Gaeilge  Indonesia

Indonesia  Polski

Polski ای کامرس دیووں جیسے کہ ایمیزون سے ڈیٹا حاصل کرنا مارکیٹ کے تجزیے، قیمتوں کی حکمت عملیوں، اور مصنوعات کی تحقیق کے لیے اہم ہے۔ یہ ڈیٹا ویب سکریپنگ کے ذریعے حاصل کیا جا سکتا ہے، جو کہ ایک طریقہ ہے جس میں ویب سائٹس سے بڑی مقدار میں معلومات نکالی جاتی ہیں۔ تاہم، ایمیزون اپنے ڈیٹا کی سختی سے حفاظت کرتا ہے، جس کی وجہ سے روایتی سکریپنگ تکنیکیں اکثر بے اثر ہو جاتی ہیں۔ اس جامع گائیڈ میں، ہم ایمیزون سے مصنوعات کا ڈیٹا جمع کرنے کے طریقوں کا جائزہ لیں گے اور پلیٹ فارم کے مضبوط اینٹی سکریپنگ سسٹمز سے بچنے کی حکمت عملیوں پر بحث کریں گے۔ ہم پائتھن، پراکسیز، اور جدید سکریپنگ تکنیکوں کے استعمال کو تلاش کریں گے جو ان چیلنجز پر قابو پانے اور آپ کے کاروبار یا تحقیق کے مقاصد کے لیے مطلوبہ ڈیٹا کو مؤثر طریقے سے حاصل کرنے میں مدد دے سکتے ہیں۔

ایمیزون سے کامیابی سے ڈیٹا سکریپ کرنے کے لیے، آپ نیچے دیے گئے ساختہ الگورتھم کی پیروی کر سکتے ہیں۔ اس طریقہ سے آپ مطلوبہ معلومات کو مؤثر اور درست طریقے سے حاصل کر سکیں گے۔

مرحلہ 1: ایمیزون کے پروڈکٹ پیجز پر HTTP درخواستیں بھیجنا:

مرحلہ 2: HTML مواد کا پارسنگ کرنا:

مرحلہ 3: ڈیٹا کو محفوظ کرنا:

ایمیزون کئی اقدامات کرتا ہے تاکہ سکریپنگ کی کوششوں کو روک سکے، جن میں کنکشن کی رفتار کی حدود، CAPTCHA کا انضمام، اور IP بلاکنگ شامل ہیں۔ صارفین ان رکاوٹوں کو دور کرنے کے لیے جوابی اقدامات اپنا سکتے ہیں، جیسے کہ اعلی معیار کی پراکسیز کا استعمال۔

وسیع سکریپنگ سرگرمیوں کے لیے، پائتھن کی جدید تکنیکیں استعمال کی جا سکتی ہیں تاکہ مصنوعات کا بڑا ڈیٹا حاصل کیا جا سکے۔ ان تکنیکوں میں ہیڈر سٹفنگ اور TLS فنگرپرنٹنگ شامل ہیں، جو کہ ڈیٹیکشن سے بچنے اور کامیاب ڈیٹا نکالنے کو یقینی بنانے میں مدد دیتی ہیں۔

یہ اقدامات مضمون کے آنے والے حصوں میں وضاحت کیے گئے ہیں جہاں ہم پائتھن 3.12.2 کا عملی اطلاق دیکھیں گے۔

ویب سکریپنگ پروجیکٹ شروع کرنے کے لیے، ہم HTML پارسنگ کے لیے lxml لائبریری اور ایمیزون ویب سرور کی طرف بھیجی جانے والی HTTP درخواستوں کا انتظام کرنے کے لیے requests لائبریری کا استعمال کرتے ہوئے ایک بنیادی سکریپر قائم کریں گے۔

ہمارا فوکس ایمیزون پروڈکٹ پیجز سے ضروری معلومات جیسے کہ مصنوعات کے نام، قیمتیں، اور ریٹنگز کو نکالنے پر ہوگا۔ ہم HTML کو مؤثر طریقے سے پارس کرنے اور درخواستوں کا انتظام کرنے کی تکنیکیں بھی پیش کریں گے، تاکہ ڈیٹا کو درست اور منظم طریقے سے نکالا جا سکے۔

پروجیکٹ کی ضروریات کو برقرار رکھنے اور تنازعات سے بچنے کے لیے، اس ویب سکریپنگ منصوبے کے لیے ایک علیحدہ ورچوئل ماحول بنانا مشورہ دیا جاتا ہے۔ ورچوئل ماحول قائم کرنے کے لیے "venv" یا "pyenv" جیسے آلات کا استعمال تجویز کیا جاتا ہے۔

آپ کو درج ذیل تیسری پارٹی کی پائتھن لائبریریوں کی ضرورت ہوگی:

یہ HTTP درخواستیں بھیجنے اور ویب مواد حاصل کرنے کے لیے استعمال ہوتا ہے۔ یہ اکثر ویب سکریپنگ اور ویب APIs کے ساتھ تعامل کے لیے استعمال ہوتا ہے۔

تنصیب:

pip install requestsایک لائبریری جو XML اور HTML دستاویزات کو پارس کرنے اور ان میں ترمیم کرنے کے لیے استعمال ہوتی ہے۔ یہ اکثر ویب سکریپنگ اور ویب پیجز سے منظم ڈیٹا کے ساتھ کام کرنے کے لیے استعمال ہوتا ہے۔

تنصیب:

pip install lxmlیہاں ہمیں اپنی سکریپر کو چلانے کے لیے ضروری لائبریریوں کو امپورٹ کرنے کی ضرورت ہے۔ جس میں HTTP درخواستوں کو ہینڈل کرنے کے لیے requests لائبریری، CSV فائل کے عمل کو ہینڈل کرنے کے لیے CSV لائبریری، random لائبریری جو کہ تصادفی اقدار پیدا کرنے اور تصادفی انتخاب کرنے کے لیے استعمال ہوتی ہے، lxml لائبریری جو کہ خام HTML مواد کو پارس کرنے کے لیے استعمال ہوتی ہے، اور Dict اور List جو کہ قسم کی ہنٹنگ کے لیے استعمال ہوتی ہیں۔

import requests

import csv

import random

from lxml import html

from typing import Dict, Listدرج ذیل کوڈ اسنیپٹ ایک CSV فائل کو پڑھتا ہے جس کا نام amazon_product_urls.csv ہے جہاں ہر لائن میں ایمیزون پروڈکٹ پیج کا URL ہوتا ہے۔ کوڈ صفوں کے اوپر دہرائی کرتا ہے، ہر صف سے URLs کو نکال کر انہیں URLs نامی فہرست میں شامل کرتا ہے۔

with open('amazon_product_urls.csv', 'r') as file:

reader = csv.DictReader(file)

for row in reader:

urls.append(row['url'])درخواست کے ہیڈرز HTTP درخواستوں میں اہم کردار ادا کرتے ہیں، جو کلائنٹ اور درخواست کی پیچیدہ معلومات فراہم کرتے ہیں۔ سکریپنگ کے دوران، ڈیٹیکشن سے بچنے اور آپ کی مطلوبہ معلومات کو آسانی سے حاصل کرنے کے لیے مجاز صارف کے عناوین کی کاپی کرنا اہم ہے۔ عام طور پر استعمال ہونے والے ہیڈرز کی نقل کرتے ہوئے، سکریپرز ڈیٹیکشن کی تکنیکوں سے بچ سکتے ہیں، اس بات کو یقینی بناتے ہوئے کہ ڈیٹا مستقل طور پر نکالا جائے جبکہ اخلاقی معیارات کو برقرار رکھا جائے۔

پراکسیز ویب سکریپنگ میں ثالث کے طور پر کام کرتی ہیں، سکریپر کے IP ایڈریس کو ماسک کرتی ہیں تاکہ سرور کے ڈیٹیکشن اور بلاکنگ سے بچا جا سکے۔ گھومتی ہوئی پراکسیز آپ کو ہر درخواست کے ساتھ نیا IP ایڈریس بھیجنے کی اجازت دیتی ہیں، ممکنہ بلاکس سے بچنے میں مدد کرتی ہیں۔ رہائشی یا موبائل پراکسیز کا استعمال اینٹی سکریپنگ اقدامات کے خلاف مزاحمت کو مضبوط بناتا ہے کیونکہ اس میں حقیقی میزبان اور فراہم کنندہ کا ڈیٹیکشن ہوتا ہے۔

درخواست کے ہیڈرز اور پراکسی سرورز کو IP ایڈریس کی اجازت کے ساتھ ضم کرنے کا کوڈ:

headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7',

'accept-language': 'en-IN,en;q=0.9',

'dnt': '1',

'sec-ch-ua': '"Google Chrome";v="123", "Not:A-Brand";v="8", "Chromium";v="123"',

'sec-ch-ua-mobile': '?0',

'sec-ch-ua-platform': '"Windows"',

'sec-fetch-dest': 'document',

'sec-fetch-mode': 'navigate',

'sec-fetch-site': 'same-origin',

'sec-fetch-user': '?1',

'upgrade-insecure-requests': '1',

}

proxies = {'http': '', 'https': ''}یہاں، ہم صارف ایجنٹوں کے مجموعے کی فہرست بنائیں گے، جس میں سے ہر درخواست کے لیے تصادفی طور پر ایک صارف ایجنٹ کا انتخاب کیا جائے گا۔ ایک ہیڈر گردش میکانزم کو نافذ کرنا، جیسے کہ ہر درخواست کے بعد صارف ایجنٹ کو گھمانا، بوٹ ڈیٹیکشن کے اقدامات سے بچنے میں مزید مدد دے سکتا ہے۔

useragents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/101.0.4591.54 Safari/537.36",

"Mozilla/5.0 (Windows NT 7_0_2; Win64; x64) AppleWebKit/541.38 (KHTML, like Gecko) Chrome/105.0.1585 Safari/537.36",

"Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/107.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/102.0.7863.44 Safari/537.36"

]

headers['user-agent'] = random.choice(useragnets)ایک مخصوص URL پر کسٹم ہیڈرز کے ساتھ ایک HTTP GET درخواست بھیجتا ہے، 30 سیکنڈ کا ٹائم آؤٹ، اور درخواست کے لیے پراکسیز کا تعین کیا جاتا ہے۔

response = requests.get(url=url, headers=headers, proxies=proxies, timeout=30)ضروری ڈیٹا پوائنٹس: عنوان، قیمت، اور ریٹنگز۔ اب، ہم ان عناصر کے لیے متعلقہ XPath کی شناخت کرنے کے لیے Chrome DevTools کے "Inspect" فیچر کا استعمال کریں گے جو ایمیزون پروڈکٹ پیج سے عنوان نکالنے کے لیے استعمال کیا جاتا ہے۔

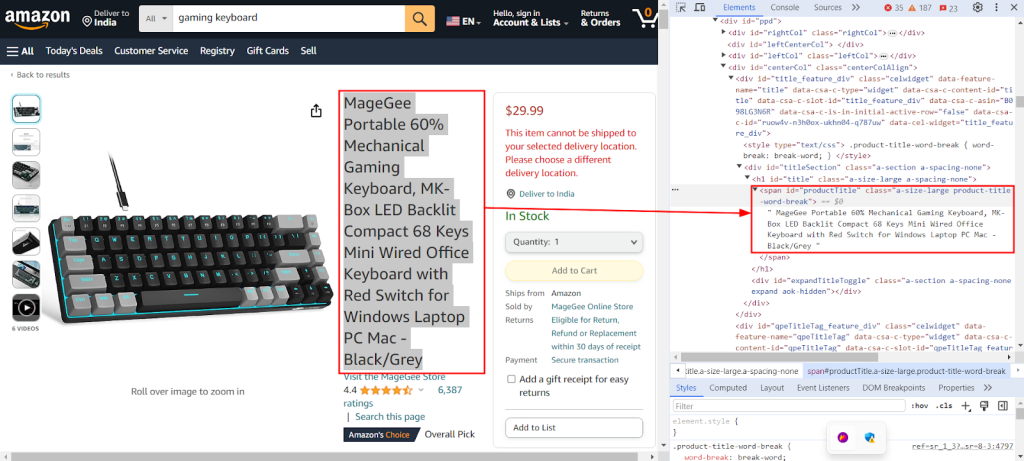

نیچے دی گئی تصویر دکھاتی ہے کہ کروم ڈیوٹولز "Inspect" فیچر کا استعمال کرتے ہوئے ایمیزون پروڈکٹ پیج سے عنوان نکالنے کے لیے XPath `//span[@id="productTitle"]/text()` کو کیسے تلاش کیا جاتا ہے۔

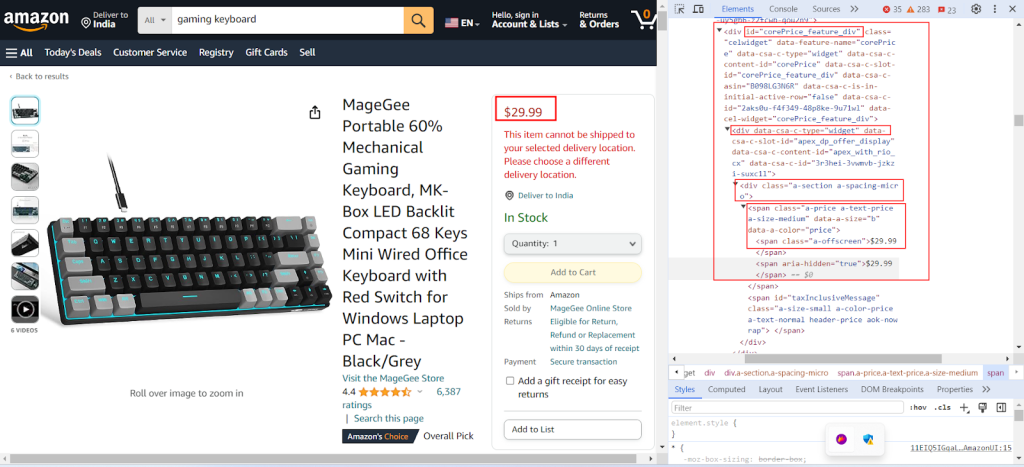

درج ذیل تصویر دکھاتی ہے کہ ایمیزون پروڈکٹ پیج سے قیمت نکالنے کے لیے متعلقہ XPath `//div[@id="corePrice_feature_div"]/div/div/span/span/text()` کیسے تلاش کیا جاتا ہے۔

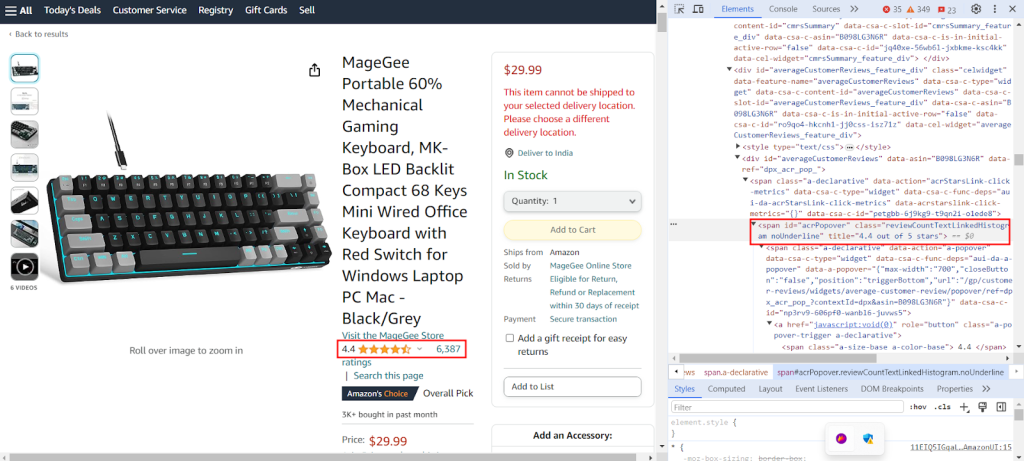

تصویر دکھاتی ہے کہ ایمیزون پروڈکٹ پیج سے ریٹنگز نکالنے کے لیے متعلقہ XPath `//span[@id="acrPopover"]/@title'` کیسے تلاش کیا جاتا ہے۔

ایک ڈکشنری بنائیں جو کہ ویب پیج سے مخصوص معلومات نکالنے کے لیے XPath کے اظہارات فراہم کرے: مصنوعات کا عنوان، ریٹنگز، اور قیمت۔

xpath_queries = {'title': '//span[@id="productTitle"]/text()', 'ratings': '//span[@id="acrPopover"]/@title', 'price': '//span[@class="a-offscreen"]/text()'}ذیل کا کوڈ GET درخواست سے حاصل کردہ HTML مواد کو ایک ساختہ درخت کی شکل میں پارس کرتا ہے، جس سے اس کے عناصر اور اوصاف کی نیویگیشن اور ہیرا پھیری آسان ہو جاتی ہے۔

tree = html.fromstring(response.text)

درج ذیل کوڈ اسنیپٹ ایک XPath کوئری کا استعمال کرتے ہوئے پارس کردہ HTML درخت سے ڈیٹا نکالتا ہے اور اسے ایک مخصوص کلید کے ساتھ ڈکشنری میں تفویض کرتا ہے۔ strip() کا استعمال کسی بھی صورت میں ابتدائی اور آخری خالی جگہوں کو دور کرنے کے لیے کیا جاتا ہے۔ یہ XPath کوئری کا پہلا نتیجہ بازیافت کرتا ہے اور اسے extracted_data ڈکشنری میں دی گئی کلید کے تحت ذخیرہ کرتا ہے۔

data = tree.xpath(xpath_query)[0].strip()

extracted_data[key] = data

درج ذیل کوڈ extracted_data ڈکشنری سے ڈیٹا کو product_data.csv نامی CSV فائل میں لکھتا ہے۔ اس بات کو یقینی بنائیں کہ ہیڈر لائن صرف اس صورت میں لکھی گئی ہو جب فائل خالی ہو۔ اگر فائل خالی نہیں ہے، تو یہ ڈیٹا کو CSV فائل میں اضافی صف کے طور پر شامل کرتا ہے۔ یہ فنکشن CSV فائل کو مستقل طور پر نکالے گئے نئے ڈیٹا کے ساتھ اپ ڈیٹ کرنے کی اجازت دیتا ہے بغیر موجودہ متن کو اوور رائٹ کیے۔

csv_file_path = 'product_data.csv'

fieldnames = ['title', 'ratings', 'price']

with open(csv_file_path, 'a', newline='') as csvfile:

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

if csvfile.tell() == 0:

writer.writeheader()

writer.writerow(extracted_data)

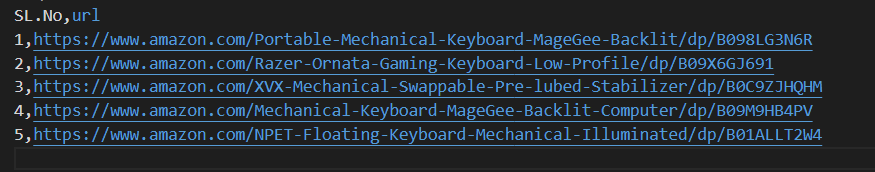

براہ کرم ہمارے مکمل کوڈ کا حوالہ دیں، جو آپ کو جلدی شروع کرنے میں مدد کرے گا۔ کوڈ اچھی طرح سے ساختہ اور دستاویزی ہے، جس سے یہ ابتدائی افراد کے لیے دوستانہ ہے۔ اس کوڈ کو چلانے کے لیے، صارف کے پاس اسی ڈائریکٹری میں "amazon_product_urls" نامی CSV فائل ہونی چاہیے۔ ذیل میں CSV فائل کی ساخت ہے:

import requests

import csv

import random

from lxml import html

from typing import Dict, List

def send_requests(

url: str, headers: Dict[str, str], proxies: Dict[str, str]

) -> List[Dict[str, str]]:

"""

کئی URLs کو ہیڈرز اور پراکسیز کے ساتھ HTTP GET درخواستیں بھیجتا ہے۔

دلائل:

urls (str): وہ URL جس پر درخواستیں بھیجی جائیں۔

headers (Dict[str, str]): درخواست کے ہیڈرز پر مشتمل ڈکشنری۔

proxies (Dict[str, str]): پراکسی سیٹنگز پر مشتمل ڈکشنری۔

واپسی:

جواب: جواب کے ڈیٹا پر مشتمل جواب کا آبجیکٹ ہر URL کے لیے۔

"""

try:

response = requests.get(url, headers=headers, proxies=proxies, timeout=30)

# جواب کی توثیق

if len(response.text) > 10000:

return response

return None

except Exception as e:

print(f"URL {url} حاصل کرنے میں خرابی ہوئی: {str(e)}")

def extract_data_from_html(

response, xpath_queries: Dict[str, str]

) -> Dict[str, List[str]]:

"""

XPath کوئریز کا استعمال کرتے ہوئے HTML مواد سے ڈیٹا نکالتا ہے۔

دلائل:

response (جواب): جواب کا آبجیکٹ۔

xpath_queries (Dict[str, str]): ڈیٹا نکالنے کے لیے XPath کوئریز پر مشتمل ڈکشنری۔

واپسی:

Dict[str, str]: ہر XPath کوئری کے لیے نکالا گیا ڈیٹا پر مشتمل ڈکشنری۔

"""

extracted_data = {}

tree = html.fromstring(response.text)

for key, xpath_query in xpath_queries.items():

data = tree.xpath(xpath_query)[0].strip()

extracted_data[key] = data

return extracted_data

def save_to_csv(extracted_data: Dict[str, any]):

"""

DictWriter کا استعمال کرتے ہوئے ڈکشنری کو CSV فائل میں ایک صف کے طور پر محفوظ کرتا ہے۔

دلائل:

extracted_data (Dict[str, any]): ایک صف کے ڈیٹا کی نمائندگی کرنے والی ڈکشنری۔

"""

csv_file_path = "product_data.csv"

fieldnames = ["title", "ratings", "price"]

with open(csv_file_path, "a", newline="") as csvfile:

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

if csvfile.tell() == 0:

writer.writeheader() # صرف اس صورت میں ہیڈر لکھیں جب فائل خالی ہو

writer.writerow(extracted_data)

def main():

# CSV فائل سے URLs پڑھنا

urls = []

with open("amazon_product_urls.csv", "r") as file:

reader = csv.DictReader(file)

for row in reader:

urls.append(row["url"])

# درخواست کے ہیڈرز کی وضاحت

headers = {

"accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.7",

"accept-language": "en-IN,en;q=0.9",

"dnt": "1",

"sec-ch-ua": '"Google Chrome";v="123", "Not:A-Brand";v="8", "Chromium";v="123"',

"sec-ch-ua-mobile": "?0",

"sec-ch-ua-platform": '"Windows"',

"sec-fetch-dest": "document",

"sec-fetch-mode": "navigate",

"sec-fetch-site": "same-origin",

"sec-fetch-user": "?1",

"upgrade-insecure-requests": "1",

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/123.0.0.0 Safari/537.36",

}

useragents = [

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/101.0.4591.54 Safari/537.36",

"Mozilla/5.0 (Windows NT 7_0_2; Win64; x64) AppleWebKit/541.38 (KHTML, like Gecko) Chrome/105.0.1585 Safari/537.36",

"Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/107.0.0.0 Safari/537.36",

"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/102.0.7863.44 Safari/537.36"

]

# پراکسیز کی وضاحت

proxies = {"http": "IP:Port", "https": "IP:Port"}

# URLs کو درخواستیں بھیجنا

for url in urls:

# ہیڈرز میں صارف ایجنٹ کی گردش

headers["user-agent"] = random.choice(useragnets)

response = send_requests(url, headers, proxies)

if response:

# HTML مواد سے ڈیٹا نکالنا

xpath_queries = {

"title": '//span[@id="productTitle"]/text()',

"ratings": '//span[@id="acrPopover"]/@title',

"price": '//span[@class="a-offscreen"]/text()',

}

extracted_data = extract_data_from_html(response, xpath_queries)

# نکالا ہوا ڈیٹا CSV فائل میں محفوظ کرنا

save_to_csv(extracted_data)

if __name__ == "__main__":

main()ڈیٹا سنٹر IPv4، گھومتی ہوئی موبائل، ISP، اور رہائشی پراکسیز سمیت مختلف پراکسی حل دستیاب ہیں تاکہ ڈیٹا کے بغیر کسی رکاوٹ کے نکالنے کے لیے۔ پراکسیز کو منتخب کرنے میں ڈیٹا کی لوڈ کو مدنظر رکھنا، صارف ایجنٹ کو صحیح طریقے سے استعمال کرنا، اور مطلوبہ معلومات کو حاصل کرنے کے لیے صحیح تکنیک کا استعمال ضروری ہے۔ پراکسیز کے مختلف اقسام کے فوائد اور نقصانات کو سمجھنا ضروری ہے تاکہ آپ اپنے پروجیکٹ کے لیے بہترین پراکسی کا انتخاب کر سکیں۔

| قسم | فوائد | نقصانات |

|---|---|---|

| ڈیٹا سنٹر پراکسیز |

تیز رفتار اور کارکردگی۔ سستا۔ بڑی تعداد میں درخواستوں کے لیے مثالی۔ |

آسانی سے پتہ لگایا اور بلیک لسٹ کیا جا سکتا ہے۔ اینٹی سکریپنگ یا اینٹی بوٹ سسٹمز کے خلاف قابل اعتماد نہیں۔ |

| رہائشی پراکسیز |

حقیقی رہائشی IPs کی وجہ سے اعلی جواز۔ مقام کے لحاظ سے ڈیٹا سکریپنگ کے لیے عالمی IP کی دستیابی۔ IP کی گردش کی صلاحیتیں۔ |

ڈیٹا سنٹر پراکسیز کے مقابلے میں زیادہ مہنگا۔ |

| موبائل پراکسیز |

انتہائی جائز IPs۔ بلاکس اور تصدیق کے پیغامات سے بچنے کے لیے مؤثر۔ |

دیگر پراکسی اقسام کے مقابلے میں زیادہ مہنگا۔ موبائل نیٹ ورک پر انحصار کی وجہ سے ڈیٹا سنٹر پراکسیز کے مقابلے میں سست۔ |

| ISP پراکسیز |

انتہائی قابل اعتماد IPs۔ رہائشی IPs سے تیز۔ |

محدود IP کی دستیابی۔ IP کی گردش دستیاب نہیں۔ |

ایمیزون سے مصنوعات کا ڈیٹا سکریپ کرنا اینٹی سکریپنگ میکانزم کو مؤثر طریقے سے نیویگیٹ کرنے کے لیے محتاط تیاری کی ضرورت ہوتی ہے۔ پراکسی سرورز کے ساتھ پائتھن کا استعمال مؤثر ڈیٹا پروسیسنگ اور مطلوبہ معلومات کے ہدف بنائے ہوئے اخراج کو فعال کرتا ہے۔ جب ویب سکریپنگ کے لیے پراکسیز کا انتخاب کرتے ہیں، تو کارکردگی، لاگت، سرور کی قابل اعتمادیت، اور آپ کے پروجیکٹ کی مخصوص ضروریات جیسے عوامل کو مدنظر رکھنا ضروری ہے۔ متحرک پراکسیز کا استعمال اور سیکیورٹی اقدامات کا مقابلہ کرنے کے لیے حکمت عملیوں کو نافذ کرنا بلاک ہونے کے خطرے کو کم کر سکتا ہے اور سکریپنگ کے عمل کی مجموعی کارکردگی کو بڑھا سکتا ہے۔

تبصرے: 0